Si noti che in alcuni casi, la multicollinearità non è un “male” così grave da richiedere sforzi significativi per identificarla ed eliminarla. Fondamentalmente, tutto dipende dagli obiettivi dello studio.

Se il compito principale del modello è prevedere i valori futuri della variabile dipendente, quindi con un coefficiente di determinazione R2(gt; 0,9) sufficientemente ampio, la presenza di multicollinearità di solito non influisce sulle qualità predittive del modello (se in futuro verranno mantenute le stesse relazioni tra le variabili correlate di prima).

Se è necessario determinare la misura in cui ciascuna variabile esplicativa influenza la variabile dipendente, è probabile che la multicollinearità, che porta a errori standard più ampi, distorca le vere relazioni tra le variabili. In questa situazione, la multicollinearità è un problema serio.

Non esiste un metodo unico per eliminare la multicollinearità adatto in ogni caso. Questo perché le cause e le conseguenze della multicollinearità sono ambigue e dipendono in gran parte dai risultati del campione.

Esclusione di variabili dal modello

Il metodo più semplice per eliminare la multicollinearità è escludere una o più variabili correlate dal modello. È necessaria una certa cautela quando si utilizza questo metodo. In questa situazione sono possibili errori di specificazione, quindi nei modelli econometrici applicati è consigliabile non escludere variabili esplicative finché la multicollinearità non diventa un problema serio.

Ottenere più dati o un nuovo campione

Poiché la multicollinearità dipende direttamente dal campione, è possibile che con un campione diverso non ci sia multicollinearità o la cosa non sia così grave. A volte, per ridurre la multicollinearità, è sufficiente aumentare la dimensione del campione. Ad esempio, se utilizzi dati annuali, puoi passare ai dati trimestrali. L’aumento della quantità di dati riduce la varianza dei coefficienti di regressione e quindi aumenta la loro significatività statistica. Tuttavia, ottenere un nuovo campione o ampliare quello vecchio non è sempre possibile o comporta costi elevati. Inoltre, questo approccio può aumentare l’autocorrelazione. Questi problemi limitano l'uso di questo metodo.

Modifica delle specifiche del modello

In alcuni casi, il problema della multicollinearità può essere risolto modificando le specifiche del modello: cambiando la forma del modello o aggiungendo variabili esplicative che non erano state prese in considerazione nel modello originale, ma influenzano significativamente la variabile dipendente. Se questo metodo è giustificato, il suo utilizzo riduce la somma delle deviazioni quadrate, riducendo così l’errore standard della regressione. Ciò si traduce in una riduzione degli errori standard dei coefficienti.

Utilizzo di informazioni anticipate su alcuni parametri

A volte, quando si costruisce un modello di regressione multipla, è possibile utilizzare informazioni preliminari, in particolare i valori noti di alcuni coefficienti di regressione.

È probabile che i valori dei coefficienti calcolati per alcuni modelli preliminari (solitamente più semplici) o per un modello simile basato su un campione precedentemente ottenuto possano essere utilizzati per il modello attualmente in fase di sviluppo.

Selezione delle variabili esplicative più significative. Procedura per collegare in sequenza gli elementi

Passare a un numero inferiore di variabili esplicative può ridurre la duplicazione delle informazioni fornite da tratti altamente interdipendenti. Questo è esattamente ciò che incontriamo nel caso della multicollinearità delle variabili esplicative.

36. metodi per identificare la multicolliarità. correlazione parziale

Le maggiori difficoltà nell'utilizzo dell'apparato di regressione multipla sorgono in presenza di multicollinearità delle variabili fattoriali, quando più di due fattori sono legati tra loro da una relazione lineare.

La multicollinearità per la regressione multipla lineare è la presenza di una relazione lineare tra le variabili fattore incluse nel modello.

La multicollinearità è una violazione di una delle principali condizioni alla base della costruzione di un modello di regressione multipla lineare.

La multicollinearità in forma matriciale è la dipendenza tra le colonne della matrice delle variabili fattore X:

Se non si tiene conto del vettore unitario, la dimensione di questa matrice è uguale a n*n. Se il rango della matrice X è inferiore a n, il modello ha multicollinearità completa o rigorosa. Ma in pratica, la multicollinearità completa non si verifica quasi mai.

Si può concludere che uno dei motivi principali della presenza di multicollinearità in un modello di regressione multipla è una matrice inadeguata delle variabili fattore X.

Quanto più forte è la multicollinearità delle variabili fattoriali, tanto meno affidabile è la stima della distribuzione della quantità di variazione spiegata tra i singoli fattori utilizzando il metodo dei minimi quadrati.

L’inclusione di fattori multicollineari nel modello è indesiderabile per diversi motivi:

1) l'ipotesi principale sull'insignificanza dei coefficienti di regressione multipla può essere confermata, ma il modello di regressione stesso, se testato utilizzando il test F, risulta essere significativo, il che indica un valore sovrastimato del coefficiente di correlazione multipla;

2) le stime ottenute dei coefficienti del modello di regressione multipla possono essere irragionevolmente gonfiate o avere segni errati;

3) aggiungere o escludere una o due osservazioni dai dati originali ha un forte impatto sulle stime dei coefficienti del modello;

4) i fattori multicollineari inclusi nel modello di regressione multipla possono renderlo inadatto per un ulteriore utilizzo.

Non esistono metodi specifici per rilevare la multicollinearità, ma è comune utilizzare una serie di tecniche empiriche. Nella maggior parte dei casi, l'analisi di regressione multipla inizia con la considerazione della matrice di correlazione delle variabili fattore R o matrice (XTX).

La matrice di correlazione delle variabili fattoriali è una matrice di coefficienti lineari di correlazione a coppie di variabili fattoriali che è simmetrica rispetto alla diagonale principale:

dove rij è il coefficiente lineare di correlazione di coppia tra le variabili fattore i-esima e j-esima,

Ce ne sono sulla diagonale della matrice di correlazione, perché il coefficiente di correlazione della variabile fattore con se stessa è uguale a uno.

Quando consideriamo questa matrice per identificare i fattori multicollineari, siamo guidati dalle seguenti regole:

1) se la matrice di correlazione delle variabili fattoriali contiene coefficienti di correlazione a coppie in valore assoluto maggiori di 0,8, allora concludono che esiste multicollinearità in questo modello di regressione multipla;

2) calcolare gli autovalori della matrice di correlazione delle variabili fattore λmin e λmax. Se λmin‹10-5, allora c'è multicollinearità nel modello di regressione. Se l'atteggiamento

poi concludono anche che esistono variabili fattore multicollineari;

3) calcolare il determinante della matrice di correlazione delle variabili fattoriali. Se il suo valore è molto piccolo, allora è presente multicollinearità nel modello di regressione.

37. modi per risolvere il problema della multicolliarità

Se il modello di regressione stimato deve essere utilizzato per studiare le relazioni economiche, è obbligatorio eliminare i fattori multicollineari perché la loro presenza nel modello può portare a segnali errati dei coefficienti di regressione.

Quando si costruisce una previsione basata su un modello di regressione con fattori multicollineari, è necessario valutare la situazione in base all'entità dell'errore di previsione. Se il suo valore è soddisfacente, il modello può essere utilizzato nonostante la multicollinearità. Se l’errore di previsione è ampio, uno dei metodi per aumentare l’accuratezza della previsione è eliminare i fattori multicollineari dal modello di regressione.

I modi principali per eliminare la multicollinearità in un modello di regressione multipla includono:

1) uno dei modi più semplici per eliminare la multicollinearità è ottenere dati aggiuntivi. Tuttavia, nella pratica, in alcuni casi, l’attuazione di questo metodo può risultare molto difficoltosa;

2) un metodo per trasformare le variabili, ad esempio, invece dei valori di tutte le variabili che partecipano al modello (inclusa quella risultante), puoi prendere i loro logaritmi:

lny=β0+β1lnx1+β2lnx2+ε.

Tuttavia anche questo metodo non è in grado di garantire la completa eliminazione della multicollinearità dei fattori;

Se i metodi considerati non hanno aiutato ad eliminare la multicollinearità dei fattori, si passa all'utilizzo di metodi distorti per stimare parametri sconosciuti di un modello di regressione o metodi per escludere variabili da un modello di regressione multipla.

Se nessuna delle variabili fattoriali incluse nel modello di regressione multipla può essere esclusa, viene utilizzato uno dei principali metodi distorti per la stima dei coefficienti del modello di regressione: regressione di cresta o cresta.

Quando si utilizza il metodo di regressione della cresta, un piccolo numero τ viene aggiunto a tutti gli elementi diagonali della matrice (XTX): 10-6 ‹ τ ‹ 0,1. La stima dei parametri sconosciuti di un modello di regressione multipla viene effettuata utilizzando la formula:

dove ln è la matrice identità.

Il risultato dell'applicazione della regressione ridge è una riduzione degli errori standard dei coefficienti del modello di regressione multipla dovuta alla loro stabilizzazione su un certo numero.

L'analisi delle componenti principali è uno dei metodi principali per eliminare le variabili da un modello di regressione multipla.

Questo metodo viene utilizzato per eliminare o ridurre la multicollinearità delle variabili fattore in un modello di regressione. L'essenza del metodo è ridurre il numero di variabili fattoriali ai fattori che influiscono in modo più significativo. Ciò si ottiene mediante la trasformazione lineare di tutte le variabili fattoriali xi (i=0,...,n) in nuove variabili chiamate componenti principali, ovvero viene effettuata una transizione dalla matrice delle variabili fattoriali X alla matrice delle componenti principali F. In questo caso si richiede che l'isolamento della prima componente principale corrisponda al massimo della varianza totale di tutte le variabili fattore xi (i=0,...,n), la seconda componente corrisponda al massimo di la varianza rimanente, dopo aver escluso l'influenza della prima componente principale, ecc.

Il metodo di inclusione graduale delle variabili consiste nel selezionare dall'intero insieme possibile di variabili fattore esattamente quelle che hanno un impatto significativo sulla variabile di risultato.

Il metodo di inclusione passo passo viene eseguito secondo il seguente algoritmo:

1) tra tutte le variabili fattore, il modello di regressione include quelle variabili che corrispondono al modulo più grande del coefficiente lineare di correlazione a coppie con la variabile di risultato;

2) quando si aggiungono nuove variabili fattoriali al modello di regressione, la loro significatività viene verificata utilizzando il test F di Fisher. Allo stesso tempo, viene avanzata l'ipotesi principale sull'inclusione ingiustificata della variabile fattore xk nel modello di regressione multipla. L'ipotesi opposta è una dichiarazione sull'opportunità di includere la variabile fattore xk nel modello di regressione multipla. Il valore critico del criterio F è definito come Fcrit(a;k1;k2), dove a è il livello di significatività, k1=1 e k2=n–l sono il numero di gradi di libertà, n è il volume del popolazione del campione, l è il numero di parametri stimati dal campione. Il valore osservato del criterio F viene calcolato utilizzando la formula:

dove q è il numero di variabili fattore già incluse nel modello di regressione.

Quando si verifica l'ipotesi principale, sono possibili le seguenti situazioni.

Fob›Fcrit, allora viene respinta l’ipotesi principale relativa all’ingiustificata inclusione della variabile fattore xk nel modello di regressione multipla. Pertanto, l’inclusione di questa variabile nel modello di regressione multipla è giustificata.

Se il valore osservato del criterio F (calcolato dai dati del campione) è inferiore o uguale al valore critico del criterio F (determinato dalla tabella di distribuzione Fisher-Snedecor), ovvero Fobs.≤Fcrit, allora l'ipotesi principale è accettata l’inclusione ingiustificata della variabile fattore xk nella regressione del modello multiplo. Pertanto, questa variabile fattore non può essere inclusa nel modello senza comprometterne la qualità

3) viene verificata la significatività delle variabili fattore finché non esiste almeno una variabile per la quale la condizione Fob›Fcrit non è soddisfatta.

38. variabili fittizie. Prova del cibo

Il termine “variabili dummy” viene utilizzato in contrapposizione alle variabili “significative”, che mostrano il livello di un indicatore quantitativo assumendo valori da un intervallo continuo. Di norma, una variabile dummy è una variabile indicatore che riflette una caratteristica qualitativa. Le più comunemente utilizzate sono variabili fittizie binarie che assumono due valori, 0 e 1, a seconda di una determinata condizione. Ad esempio, in un sondaggio condotto su un gruppo di persone, uno 0 potrebbe significare che la persona intervistata è un uomo e un 1 potrebbe significare una donna. Le variabili fittizie a volte includono un regressore costituito da sole unità (ad esempio, una costante, un termine di intercetta), nonché una tendenza temporale.

Le variabili dummy, essendo esogene, non creano alcuna difficoltà nell'utilizzo di OLS. Le variabili fittizie sono uno strumento efficace per costruire modelli di regressione e testare ipotesi.

Supponiamo che sia stato costruito un modello di regressione sulla base dei dati raccolti. Il ricercatore deve chiedersi se valga la pena introdurre ulteriori variabili dummy nel modello risultante o se il modello di base sia ottimale. Questo problema viene risolto utilizzando il metodo o test di Chow. Viene utilizzato in situazioni in cui la popolazione del campione principale può essere divisa in parti o sottocampioni. In questo caso, è possibile verificare l'ipotesi che i sottocampioni siano più efficaci del modello di regressione complessivo.

Assumeremo che il modello di regressione generale sia un modello di regressione non vincolata. Indichiamo questo modello con ONU. Considereremo casi speciali del modello di regressione senza restrizioni come sottocampioni separati. Indichiamo questi sottocampioni parziali come PR.

Introduciamo la seguente notazione:

PR1 – primo sottocampione;

PR2 – secondo sottocampione;

ESS(PR1) – somma dei quadrati dei residui del primo sottocampione;

ESS(PR2) – somma dei quadrati dei residui del secondo sottocampione;

ESS(UN) è la somma dei quadrati dei residui per il modello di regressione complessivo.

– la somma dei quadrati dei residui per le osservazioni del primo sottocampione nel modello di regressione generale;

– la somma dei quadrati dei residui per le osservazioni del secondo sottocampione nel modello di regressione generale.

Per particolari modelli di regressione, sono valide le seguenti disuguaglianze:

Condizione (ESS(PR1)+ESS(PR2))= ESS(UN) viene effettuata solo se i coefficienti dei modelli di regressione parziale e i coefficienti del modello di regressione generale senza restrizioni sono gli stessi, ma in pratica tale coincidenza è molto rara.

L'ipotesi principale è affermata come l'affermazione che la qualità del modello di regressione non vincolata complessivo è migliore della qualità dei modelli di regressione parziale o dei sottocampioni.

L'ipotesi alternativa o opposta afferma che la qualità del modello di regressione generale non vincolata è peggiore della qualità di modelli di regressione specifici o sottocampioni

Queste ipotesi vengono verificate utilizzando il test F Fisher-Snedecor.

Il valore osservato del test F viene confrontato con il valore critico del test F, determinato dalla tabella di distribuzione Fisher-Snedecor.

UN k1=m+1 E k2=n-2m-2.

Il valore osservato del criterio F viene calcolato utilizzando la formula: dove ESS(ONU)–ESS(PR1)–ESS(PR2)– valore che caratterizza il miglioramento della qualità del modello di regressione dopo averlo suddiviso in sottocampioni;

M– numero di variabili fattore (anche dummy);

N– la dimensione della popolazione totale del campione.

Se il valore osservato del test F (calcolato dai dati del campione) è maggiore del valore critico del test F (determinato dalla tabella di distribuzione Fisher-Snedecor), ad es. Fob>Fcrit, allora l'ipotesi principale viene rifiutata e la qualità dei particolari modelli di regressione supera la qualità del modello di regressione generale.

Se il valore osservato del test F (calcolato dai dati del campione) è inferiore o uguale al valore critico del test F (determinato dalla tabella di distribuzione Fisher-Snedecor), ad es. Fob?Fcrit, allora si accetta l’ipotesi principale e non ha senso suddividere la regressione complessiva in sottocampioni.

Se viene testata la significatività della regressione di base o della regressione ristretta, viene avanzata l'ipotesi principale della forma:

La validità di questa ipotesi viene verificata utilizzando il test F di Fisher-Snedecor.

Il valore critico del test Fisher F è determinato dalla tabella di distribuzione Fisher-Snedecor in base al livello di significatività UN e due gradi di libertà k1=m+1 E k2=n–k–1.

Il valore osservato del criterio F viene convertito nella forma:

Quando si verificano le ipotesi, sono possibili le seguenti situazioni.

Se il valore osservato del test F (calcolato dai dati del campione) è maggiore del valore critico del test F (determinato dalla tabella di distribuzione Fisher-Snedecor), ad es. Fob›Fcrit, quindi l'ipotesi principale viene rifiutata e ulteriori variabili dummy devono essere introdotte nel modello di regressione perché la qualità del modello di regressione vincolata è superiore alla qualità del modello di regressione di base o vincolato.

Se il valore osservato del test F (calcolato dai dati del campione) è inferiore o uguale al valore critico del test F (determinato dalla tabella di distribuzione Fisher-Snedecor), ad es. Fob?Fcrit, allora l'ipotesi principale è accettata e il modello di regressione di base è soddisfacente; non ha senso introdurre ulteriori variabili dummy nel modello;

39. sistema di equazioni simultanee (variabili endogene, esogene, ritardate). Esempi economicamente significativi di sistemi di equazioni simultanee

Finora abbiamo considerato modelli econometrici definiti da equazioni che esprimono la variabile dipendente (spiegata) in termini di variabili esplicative. Tuttavia, gli oggetti economici reali studiati utilizzando metodi econometrici portano ad un ampliamento del concetto di modello econometrico descritto da un sistema di equazioni e identità di regressione1.

1 A differenza delle equazioni di regressione, le identità non contengono parametri del modello da stimare e non includono una componente casuale.

Una caratteristica di questi sistemi è che ciascuna delle equazioni del sistema, oltre alle “proprie” variabili esplicative, può includere variabili spiegate di altre equazioni. Pertanto, non abbiamo una variabile dipendente, ma un insieme di variabili dipendenti (spiegate) correlate dalle equazioni del sistema. Tale sistema è detto anche sistema di equazioni simultanee, sottolineando il fatto che nel sistema le stesse variabili sono contemporaneamente considerate dipendenti in alcune equazioni e indipendenti in altre.

I sistemi di equazioni simultanee descrivono in modo più completo un oggetto economico contenente molte variabili endogene (formate all'interno del funzionamento dell'oggetto) ed esogene (impostate dall'esterno) interconnesse. In questo caso, le variabili ritardate (prese nel momento precedente) possono agire come endogene ed esogene.

Un classico esempio di tale sistema è il modello di domanda Qd e offerta Qs (vedi § 9.1), quando la domanda di un prodotto è determinata dal suo prezzo P e dal reddito del consumatore /, l'offerta di un prodotto è determinata dal suo prezzo P e si raggiunge un equilibrio tra domanda e offerta:

In questo sistema, la variabile esogena è il reddito del consumatore /, e la variabile endogena è la domanda (offerta) del prodotto Qd = Q» = Q e il prezzo del prodotto (prezzo di equilibrio) R.

In un altro modello di domanda e offerta, la variabile che spiega l’offerta Qf può non essere solo il prezzo del bene P in un dato momento /, cioè Pb ma anche il prezzo del prodotto nel momento precedente Ptb cioè. variabile endogena ritardata:

th"=P4+P5^+Pb^-1+Є2.

Riassumendo quanto sopra, possiamo dire che il modello econometrico consente di spiegare il comportamento delle variabili endogene in funzione dei valori delle variabili endogene esogene e ritardate (in altre parole, in funzione di variabili predeterminate, cioè predeterminate).

Concludendo la nostra considerazione del concetto di modello econometrico, va notato quanto segue. Non tutti i modelli economici e matematici che rappresentano una descrizione matematica e statistica dell'oggetto economico in esame possono essere considerati econometrici. Diventa econometrico solo se riflette questo oggetto sulla base di dati empirici (statistici) che lo caratterizzano.

40. metodo dei minimi quadrati indiretti

Se l'i -esima equazione stocastica della forma strutturale viene identificata esattamente, i parametri di questa equazione (i coefficienti dell'equazione e la varianza dell'errore casuale) vengono ripristinati in modo univoco dai parametri del sistema ridotto. Pertanto, per stimare i parametri di tale equazione, è sufficiente stimare i coefficienti di ciascuna delle equazioni della forma ridotta utilizzando il metodo dei minimi quadrati (separatamente per ciascuna equazione) e ottenere una stima della matrice di covarianza Q degli errori in la forma ridotta, e quindi utilizzare le relazioni PG = B ed E = GTQT, sostituendo in esse, al posto di P, una matrice stimata di coefficienti della forma ridotta P e una matrice stimata di covarianza degli errori in forma ridotta £2 . Questa procedura è chiamata minimi quadrati indiretti (minimi quadrati indiretti ILS). Le stime risultanti dei coefficienti dell'i-esima equazione stocastica della forma strutturale ereditano la proprietà di consistenza delle stime della forma ridotta. Tuttavia, non ereditano proprietà degli stimatori in forma ridotta come imparzialità ed efficienza poiché sono ottenuti come risultato di alcune trasformazioni non lineari. Di conseguenza, con un numero limitato di osservazioni, anche queste stime naturali possono essere soggette a notevoli distorsioni. A questo proposito, quando si considerano vari metodi per stimare i coefficienti delle equazioni strutturali, si preoccupano principalmente di garantire la coerenza delle stime risultanti.

41. problemi di identificabilità di sistemi di equazioni simultanee

Con la corretta specificazione del modello, il compito di identificare un sistema di equazioni si riduce a una stima corretta e inequivocabile dei suoi coefficienti. La valutazione diretta dei coefficienti delle equazioni è possibile solo in sistemi di equazioni apparentemente non correlate per i quali sono soddisfatti i prerequisiti di base per la costruzione di un modello di regressione, in particolare la condizione che le variabili fattoriali non siano correlate con i residui.

Nei sistemi ricorsivi è sempre possibile eliminare il problema della correlazione dei residui con le variabili fattore sostituendo come valori delle variabili fattore non effettivi, ma valori modello di variabili endogene che agiscono come variabili fattore. Il processo di identificazione si svolge come segue:

1. Viene identificata un'equazione che non contiene variabili endogene come fattori. Si trova il valore calcolato della variabile endogena di questa equazione.

2. Considera la seguente equazione, in cui è inclusa come fattore la variabile endogena trovata nel passaggio precedente. I valori del modello (stimati) di questa variabile endogena forniscono la capacità di identificare questa equazione, ecc.

Nel sistema di equazioni in forma ridotta non si pone il problema della correlazione delle variabili fattoriali con le deviazioni, poiché in ciascuna equazione vengono utilizzate come variabili fattoriali solo variabili predefinite. Pertanto, se sono soddisfatti altri prerequisiti, il sistema ricorsivo è sempre identificabile.

Quando si considera un sistema di equazioni simultanee sorge un problema di identificazione.

Individuare in questo caso significa determinare la possibilità di ricalcolare inequivocabilmente i coefficienti del sistema in forma ridotta in coefficienti strutturali.

Il modello strutturale (7.3) lo contiene nella sua interezza ![]() parametri che devono essere determinati. La forma data del modello contiene i parametri per intero. Pertanto, per determinare

parametri che devono essere determinati. La forma data del modello contiene i parametri per intero. Pertanto, per determinare ![]() parametri sconosciuti del modello strutturale, è possibile elaborare equazioni. Tali sistemi sono incerti e i parametri del modello strutturale nel caso generale non possono essere determinati in modo univoco.

parametri sconosciuti del modello strutturale, è possibile elaborare equazioni. Tali sistemi sono incerti e i parametri del modello strutturale nel caso generale non possono essere determinati in modo univoco.

Per ottenere l'unica soluzione possibile è necessario assumere che alcuni coefficienti strutturali del modello, a causa della loro debole relazione con la variabile endogena del lato sinistro del sistema, siano pari a zero. Ciò ridurrà il numero di coefficienti strutturali del modello. Ridurre il numero dei coefficienti strutturali del modello è possibile anche in altri modi: ad esempio equiparando tra loro alcuni coefficienti, cioè assumendo che il loro impatto sulla variabile endogena in formazione sia lo stesso, ecc.

Dal punto di vista dell’identificabilità, i modelli strutturali possono essere suddivisi in tre tipologie:

· identificabile;

· non identificabile;

· sovraidentificato.

Modello identificabile, se tutti i suoi coefficienti strutturali sono determinati univocamente, in modo unico, dai coefficienti della forma ridotta del modello, cioè se il numero dei parametri del modello strutturale è pari al numero dei parametri della forma ridotta del il modello.

Modello non identificabile, se il numero di coefficienti del modello ridotto è inferiore al numero di coefficienti strutturali e, di conseguenza, i coefficienti strutturali non possono essere stimati attraverso i coefficienti della forma ridotta del modello.

Modello sovraidentificabile, se il numero di coefficienti del modello ridotto è maggiore del numero di coefficienti strutturali. In questo caso, in base ai coefficienti di forma ridotti, si possono ottenere due o più valori di un coefficiente strutturale. Un modello sovraidentificabile, a differenza di un modello non identificabile, è praticamente risolvibile, ma richiede metodi speciali per trovare i parametri.

Per determinare il tipo di modello strutturale, è necessario verificare l'identificabilità di ciascuna delle sue equazioni.

Un modello è considerato identificabile se ogni equazione del sistema è identificabile. Se almeno una delle equazioni del sistema non è identificabile, allora l'intero modello è considerato non identificabile. Oltre a quelli identificabili, un modello sovraidentificato contiene almeno un'equazione sovraidentificata.

42. Metodo dei minimi quadrati in tre passaggi

La procedura più efficace per la stima dei sistemi di equazioni di regressione combina il metodo della stima simultanea e il metodo delle variabili strumentali. Il metodo corrispondente è detto dei minimi quadrati a tre passi. Consiste nel fatto che nella prima fase si applica il metodo generalizzato dei minimi quadrati al modello originale (9.2) per eliminare la correlazione dei termini casuali. Il metodo dei minimi quadrati in due passaggi viene quindi applicato alle equazioni risultanti.

Ovviamente, se i termini casuali (9.2) non sono correlati, il metodo a tre passi si riduce ad uno a due passi, mentre allo stesso tempo, se la matrice B è identità, il metodo a tre passi è una procedura per simultaneità stima delle equazioni come esternamente non correlate.

Applichiamo il metodo in tre fasi al modello in esame (9.24):

ai=19,31; Pi=l.77; a2=19,98; p2=0,05; y=1,4. (6,98) (0,03) (4,82) (0,08) (0,016)

Poiché il coefficiente p2 è insignificante, l’equazione per la dipendenza di Y da X ha la forma:

y = 16,98 + 1,4x

Si noti che praticamente coincide con l'equazione (9.23).

Come è noto, purificare un'equazione dalla correlazione di termini casuali è un processo iterativo. Di conseguenza, quando si utilizza il metodo in tre fasi, il programma del computer richiede il numero di iterazioni o la precisione richiesta. Notiamo un'importante proprietà del metodo in tre fasi, che ne garantisce la massima efficienza.

Per un numero sufficientemente elevato di iterazioni, le stime dei minimi quadrati in tre passaggi coincidono con le stime di massima verosimiglianza.

È noto che gli stimatori di massima verosimiglianza funzionano meglio su campioni di grandi dimensioni.

43. concetto di serie storica economica. Vista generale del modello delle serie temporali moltiplicativo e additivo.

44. modellazione degli andamenti delle serie storiche, delle fluttuazioni stagionali e cicliche.

Esistono diversi approcci per analizzare la struttura delle serie temporali contenenti fluttuazioni stagionali o cicliche.

1 APPROCCIO. Calcolo dei valori delle componenti stagionali mediante il metodo della media mobile e costruzione di un modello di serie storiche additivo o moltiplicativo.

Vista generale del modello additivo: (T - componente di tendenza, S - stagionale, E - casuale).

Vista generale del modello moltiplicativo:

Selezione di un modello basato sull'analisi della struttura delle fluttuazioni stagionali (se l'ampiezza delle fluttuazioni è approssimativamente costante - additiva, se aumenta/diminuisce - moltiplicativa).

La costruzione dei modelli si riduce al calcolo dei valori di T, S, E per ciascun livello della serie.

Costruzione del modello:

1. allineamento delle serie originali mediante il metodo della media mobile;

2.calcolo dei valori dei componenti S;

3. Eliminando la componente stagionale dai livelli iniziali della serie e ottenendo dati allineati ( T+E) in additivo o ( T*E) nel modello moltiplicativo.

4. Livellamento analitico ( T+E) O ( T*E) e calcolo del valore T utilizzando il livello di tendenza ottenuto.

5.Calcolo dei valori ottenuti dal modello ( T+S) O ( T*S).

6.Calcolo degli errori assoluti e/o relativi.

Se i valori di errore ottenuti non contengono autocorrelazione, possono essere utilizzati per sostituire i livelli originali della serie e successivamente utilizzare la serie temporale degli errori E analizzare la relazione tra la serie originale e altre serie temporali.

2 APPROCCIO. Costruzione di un modello di regressione comprendente il fattore tempo e le variabili dummy. Il numero di variabili fittizie in tale modello dovrebbe essere inferiore di uno rispetto al numero di momenti (periodi) di tempo all'interno di un ciclo di oscillazione. Ad esempio, quando si modellano dati trimestrali, il modello deve includere quattro variabili indipendenti: un fattore temporale e tre variabili fittizie. Ciascuna variabile fittizia riflette la componente stagionale (ciclica) della serie temporale per qualsiasi periodo. È pari a uno (1) per un dato periodo e a zero (0) per tutti gli altri. Lo svantaggio di un modello con variabili dummy è la presenza di un gran numero di variabili.

45. funzione di autocorrelazione. Il suo utilizzo per identificare la presenza o l'assenza di trend e componenti cicliche

Autocorrelazione dei livelli delle serie storiche.

Se in una serie temporale sono presenti trend e fluttuazioni cicliche, ogni livello successivo della serie dipende da quelli precedenti. Viene chiamata la dipendenza dalla correlazione tra livelli successivi di una serie temporale autocorrelazione dei livelli delle serie.

Quantitativamente, l'autocorrelazione dei livelli delle serie viene misurata utilizzando un coefficiente di correlazione lineare tra i livelli della serie temporale originale e i livelli di questa serie, spostati di diversi passi nel tempo.

Consideriamo, ad esempio, una serie temporale ![]() . Determiniamo il coefficiente di correlazione tra la serie e .

. Determiniamo il coefficiente di correlazione tra la serie e .

Una delle formule di lavoro per il calcolo del coefficiente di correlazione è:

E le serie temporali, ad es. al ritardo 2. È determinato dalla formula:

(4)

(4)

Si noti che all'aumentare del ritardo diminuisce il numero di coppie di valori da cui viene calcolato il coefficiente di correlazione. In genere, il ritardo non può essere superiore a un quarto del numero di osservazioni.

Notiamo due importanti proprietà dei coefficienti di autocorrelazione.

Innanzitutto, i coefficienti di autocorrelazione vengono calcolati per analogia con il coefficiente di correlazione lineare, vale a dire caratterizzano solo la vicinanza della connessione lineare tra i due livelli della serie storica considerata. Pertanto, il coefficiente di autocorrelazione può giudicare solo la presenza di un trend lineare (o quasi lineare). Per le serie temporali che hanno una forte tendenza non lineare (ad esempio esponenziale), il coefficiente di autocorrelazione del livello può avvicinarsi allo zero.

Disposizioni fondamentali

Se i regressori nel modello sono collegati da una stretta dipendenza funzionale, allora multicollinearità completa (perfetta).. Questo tipo di multicollinearità può verificarsi, ad esempio, in un problema di regressione lineare risolto con il metodo dei minimi quadrati, se il determinante della matrice è uguale a zero. La multicollinearità completa non ci consente di stimare in modo inequivocabile i parametri del modello originale e di separare i contributi dei regressori alla variabile di output sulla base dei risultati delle osservazioni.

Nei problemi con dati reali, il caso di multicollinearità completa è estremamente raro. Nel dominio applicativo invece spesso abbiamo a che fare multicollinearità parziale, che è caratterizzato da coefficienti di correlazione a coppie tra regressori. Nel caso di multicollinearità parziale la matrice avrà rango pieno, ma il suo determinante sarà prossimo allo zero. In questo caso, è formalmente possibile ottenere stime dei parametri del modello e dei loro indicatori di accuratezza, ma saranno tutti instabili.

Tra le conseguenze della multicollinearità parziale ci sono le seguenti:

- aumento delle varianze delle stime dei parametri

- diminuzione dei valori della statistica t per i parametri, che porta a una conclusione errata sulla loro significatività statistica

- ottenere stime instabili dei parametri del modello e delle loro varianze

- la possibilità di ottenere un segno errato dal punto di vista teorico della stima del parametro

Non esistono criteri quantitativi precisi per rilevare la multicollinearità parziale. I seguenti sono più spesso usati come segni della sua presenza:

Metodi per eliminare la multicollinearità

Esistono due approcci principali per risolvere questo problema.

Indipendentemente da come viene effettuata la selezione dei fattori, la riduzione del loro numero porta ad un miglioramento della condizionalità della matrice e, di conseguenza, ad un aumento della qualità delle stime dei parametri del modello.

Oltre ai metodi elencati, ce n'è un altro, più semplice, che dà risultati abbastanza buoni: questo è metodo di precentratura. L'essenza del metodo è che prima di trovare i parametri del modello matematico, i dati di origine vengono centrati: la media della serie viene sottratta da ciascun valore nella serie di dati: . Questa procedura ci consente di separare gli iperpiani delle condizioni LSM in modo che gli angoli tra loro siano perpendicolari. Di conseguenza, le stime del modello diventano stabili (Costruzione di modelli multifattoriali in condizioni di multicollinearità).

DOMANDE PER L'ESAME DEL CORSO

"ECONOMETRIA (livello avanzato)"

1. Modello di regressione multipla. Tipi di modelli di regressione multipla.

2. Modulo di registrazione della matrice e formula della matrice per la stima di parametri di regressione multipli.

3. Valutare la qualità dell'equazione di regressione. Componenti spiegate e non spiegate dell'equazione di regressione.

4. Coefficiente di determinazione e coefficiente di correlazione, loro calcolo in un modello di regressione accoppiata.

5. Coefficiente multiplo selettivo di determinazione e verifica del suo significato mediante il test di Fisher.

6. Verifica del significato di un'equazione di regressione multipla utilizzando il test di Fisher.

Il significato dell'equazione di regressione, vale a dire adattamento del modello econometrico Y= UNˆ0 + UNÈ 1 X+ e i dati reali (empirici), ci permettono di farlo

determinare se l'equazione di regressione è adatta per l'uso pratico (per analisi e previsioni) o meno.

Per verificare il significato dell'equazione, utilizzare F- Criterio di Fisher. Viene calcolato dai dati effettivi come il rapporto tra imparziale

la varianza della componente residua alla varianza della serie originaria. Il significato del coefficiente di determinazione viene verificato utilizzando il criterio di Fisher, il cui valore calcolato si trova utilizzando la formula:

,

,

dove è il coefficiente di correlazione multipla, è il numero di osservazioni, è il numero di variabili, è l'elemento diagonale della matrice.

Per verificare l'ipotesi, il valore della tabella viene determinato dalla tabella

Prova di Fisher F.

F(α ν1 ν2) è il massimo valore possibile del criterio in funzione dell'influenza di fattori casuali per dati gradi di libertà

ν = m1, ν2 = N− M−1 e livello di significatività α. Qui M– numero di argomenti nel modello.

Il livello di significatività α è la probabilità di rifiutare l'ipotesi corretta, ma a condizione che sia vera (errore di tipo I). Tipicamente α viene considerato pari a 0,05 o 0,01.

Se F f> F tavolo, quindi H0– viene respinta l’ipotesi circa la casualità delle caratteristiche valutate e se ne riconosce la significatività statistica e l’attendibilità. Se al contrario, allora l'ipotesi H0 non viene rifiutata e vengono riconosciute l'insignificanza statistica e l'inaffidabilità dell'equazione di regressione.

7. Valutazione della significatività dei coefficienti di correlazione lineare. -Test dello studente.

Per valutare la significatività statistica dei coefficienti di regressione e del coefficiente di correlazione, viene calcolato il test t di Student. Viene avanzata un'ipotesi H 0 sulla natura casuale degli indicatori, vale a dire sulla loro insignificante differenza da zero. I valori t-test osservati vengono calcolati utilizzando le formule:

| , , , |

dove sono gli errori casuali dei parametri di regressione lineare e il coefficiente di correlazione.

Per la regressione a coppie lineari, l'uguaglianza è soddisfatta, pertanto verificare le ipotesi sulla significatività del coefficiente di regressione rispetto a un fattore e il coefficiente di correlazione equivale a verificare l'ipotesi sulla significatività statistica dell'equazione di regressione nel suo complesso.

In generale, gli errori casuali vengono calcolati utilizzando le formule:

, ,  . .

|

dove è la dispersione residua per grado di libertà:

. .

|

Il valore tabulato (critico) delle statistiche t si trova dalle tabelle della distribuzione t-Student a un livello di significatività di α = 0,05 e dal numero di gradi di libertà. Se T tavolo< T fatto, quindi H 0 viene rifiutato, cioè Non è un caso che i coefficienti di regressione differiscano da zero e si siano formati sotto l'influenza di un fattore che agisce sistematicamente.

8. Analisi dell'influenza dei fattori basata su modelli di regressione multifattoriale: coefficiente di elasticità; coefficiente beta e coefficiente delta.

9. Metodi per il calcolo dei parametri , , della funzione di produzione di Cobb-Douglas.

10. Equazioni di regressione a struttura variabile. Variabili fittizie. Tipi di variabili dummy. Vantaggi dell'utilizzo di variabili fittizie durante la creazione di modelli di regressione.

11. Utilizzo di variabili fittizie per studiare il cambiamento strutturale. Modellare la stagionalità. Numero di variabili binarie a k gradazioni.

Il concetto di multicollinearità. Metodi per rilevare ed eliminare la multicollinearità.

La valutazione quantitativa dei parametri dell'equazione di regressione presuppone che sia soddisfatta la condizione di indipendenza lineare tra le variabili indipendenti. Tuttavia, in pratica, le variabili esplicative hanno spesso un elevato grado di interrelazione tra loro, il che costituisce una violazione di questa condizione. Questo fenomeno si chiama multicollinearità.

Termine collinearità (collineare) denota una correlazione lineare tra due variabili indipendenti, e Multicollinearità (multicollineare) – tra più di due variabili indipendenti. Tipicamente, la multicollinearità si riferisce a entrambi i casi.

Così, multicollinearità significa che esiste una stretta relazione lineare o una forte correlazione tra due o più variabili esplicative (indipendenti). Uno dei compiti dell’econometria è identificare la multicollinearità tra variabili indipendenti.

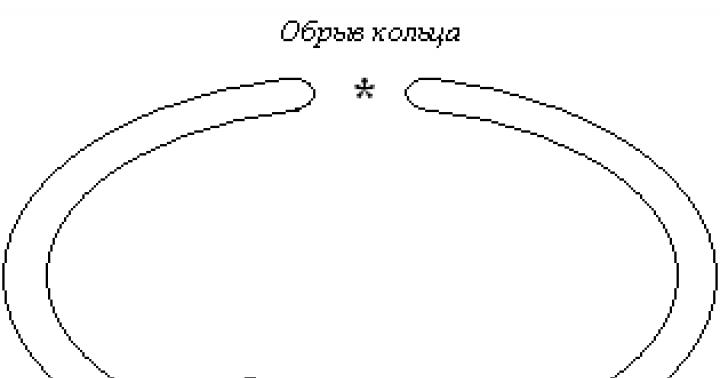

Distinguere perfetto E imperfetto multicollinearità. Perfetto Multicollinearità significa che la variazione in una delle variabili indipendenti può essere completamente spiegata dalla variazione nelle altre variabili.

Altrimenti, la relazione tra loro è espressa da una funzione lineare

![]()

Interpretazione grafica di questo caso:

Interpretazione grafica di questo caso:

Imperfetto La multicollinearità può essere definita come una relazione funzionale lineare tra due o più variabili indipendenti così forte da poter influenzare significativamente le stime dei coefficienti delle variabili nel modello.

La multicollinearità imperfetta si verifica quando due (o più) variabili indipendenti sono in una relazione funzionale lineare tra loro, descritta dall'equazione

A differenza dell'equazione discussa in precedenza, questa include l'entità dell'errore stocastico. Ciò suggerisce che, sebbene la relazione tra e possa essere piuttosto forte, non è così forte da poter spiegare completamente la variazione della variabile con la variazione di , cioè c'è qualche variazione inspiegabile.

Graficamente questo caso è presentato come segue:

|

In quali casi può verificarsi la multicollinearità? Ce ne sono almeno due.

1. Esiste una tendenza globale a cambiamenti simultanei negli indicatori economici. Ad esempio, possiamo citare indicatori come volume di produzione, reddito, consumo, accumulazione, occupazione, investimenti, ecc., i cui valori aumentano durante i periodi di crescita economica e diminuiscono durante i periodi di recessione.

Uno dei motivi della multicollinearità è la presenza di un trend (tendenza) nella dinamica degli indicatori economici.

2. Utilizzo di valori ritardati delle variabili nei modelli economici.

Ad esempio, possiamo considerare modelli che utilizzano sia il reddito del periodo corrente sia i costi di consumo di quello precedente.

In generale, quando si studiano processi e fenomeni economici utilizzando metodi econometrici, è molto difficile evitare la dipendenza tra gli indicatori.

Le conseguenze della multicollinearità si riducono a

1. riduzione dell'accuratezza della valutazione, che si manifesta attraverso

UN. errori troppo grandi in alcune stime,

B. elevato grado di correlazione tra errori,

C. Un forte aumento della dispersione delle stime dei parametri. Questa manifestazione di multicollinearità può anche riflettersi nell'ottenimento di un segno inaspettato durante la stima dei parametri;

2. l'insignificanza delle stime dei parametri per alcune variabili del modello dovuta, innanzitutto, alla presenza della loro relazione con altre variabili, e non al fatto che non influenzano la variabile dipendente. Cioè, le statistiche dei parametri del modello non soddisfano il livello di significatività (il test t di Student non supera il test di adeguatezza);

3. un forte aumento della sensibilità delle stime dei parametri alla dimensione della popolazione delle osservazioni. Cioè, un aumento del numero di osservazioni può influenzare significativamente le stime dei parametri del modello;

4. intervalli di confidenza crescenti;

5. aumentare la sensibilità delle stime ai cambiamenti nella specificazione del modello (ad esempio, all'aggiunta o all'esclusione di variabili dal modello, anche quelle che hanno un effetto non significativo).

Segni di multicollinearità:

1. quando tra coefficienti di correlazione di coppia

tra le variabili esplicative (indipendenti) ci sono quelle il cui livello si avvicina o è pari al coefficiente di correlazione multipla.

Se nel modello sono presenti più di due variabili indipendenti, è necessario uno studio più dettagliato delle relazioni tra le variabili. Questa procedura può essere eseguita utilizzando l'algoritmo Farrar-Glober;

2. quando il determinante della matrice dei coefficienti di correlazione a coppie tra variabili indipendenti si avvicina allo zero:

se , allora esiste multicollinearità completa,

se , allora non esiste multicollinearità;

3. se nel modello si trova un valore di parametro piccolo ad un livello elevato del coefficiente di determinazione parziale e allo stesso tempo il criterio differisce significativamente da zero;

La multicollinearità è la correlazione di due o più variabili esplicative in un'equazione di regressione. Può essere funzionale (esplicito) e stocastico (nascosto). Con multicollinearità funzionale, la matrice XTX è degenerata e (XTX)-1 non esiste, quindi è impossibile da determinare. Più spesso, la multicollinearità si manifesta in forma stocastica, mentre le stime OLS esistono formalmente, ma presentano una serie di svantaggi:

- 1) un piccolo cambiamento nei dati iniziali porta ad un cambiamento significativo nelle stime di regressione;

- 2) le stime hanno errori standard ampi e bassa significatività, mentre il modello nel suo insieme è significativo (valore R2 elevato);

- 3) le stime intervallari dei coefficienti si espandono, peggiorando la loro accuratezza;

- 4) è possibile ottenere un segno sbagliato per il coefficiente di regressione.

Rilevamento

Esistono diversi segni in base ai quali è possibile determinare la presenza di multicollinearità.

Innanzitutto, analisi della matrice di correlazione dei coefficienti di correlazione a coppie:

- - se esistono coppie di variabili che hanno coefficienti di correlazione elevati (> 0,75 - 0,8), si parla di multicollinearità tra loro;

- - se i fattori non sono correlati allora det Q = 1, se la correlazione è completa allora det Q = 0.

Puoi controllare H0: det Q = 1; utilizzando test statistici

dove n è il numero di osservazioni, m = p+1.

Se, allora H0 viene rifiutato e viene dimostrata la multicollinearità.

In secondo luogo, vengono determinati più coefficienti di determinazione di una delle variabili esplicative e di un gruppo di altre. La presenza di un R2 elevato (> 0,6) indica multicollinearità.

In terzo luogo, la vicinanza allo zero dell'autovalore minimo della matrice XTX (cioè la soluzione dell'equazione) indica che anche det(XTX) è vicino allo zero e, quindi, multicollinearità.

In quarto luogo, elevati coefficienti di correlazione parziale.

dove sono le somme algebriche degli elementi della matrice dei coefficienti di correlazione campionaria. I coefficienti di correlazione parziale di ordine superiore possono essere determinati attraverso i coefficienti di correlazione parziale di ordine inferiore utilizzando la formula ricorrente:

In quinto luogo, la presenza di multicollinearità è indicata da alcuni segni esterni del modello costruito, che ne sono le conseguenze. Questi dovrebbero includere quanto segue:

- · alcune stime presentano segni errati dal punto di vista della teoria economica o valori assoluti irragionevolmente elevati;

- · una piccola variazione nei dati statistici iniziali (aggiunta o rimozione di alcune osservazioni) porta ad un cambiamento significativo nelle stime dei coefficienti del modello, cambiandone anche il segno;

- · la maggior parte o addirittura tutte le stime dei coefficienti di regressione risultano statisticamente insignificanti secondo il t-test, mentre il modello nel suo complesso è significativo secondo il F-test.

Esistono numerosi altri metodi per determinare la multicollinearità.

Se il compito principale del modello è prevedere i valori futuri della variabile dipendente, allora con un coefficiente di determinazione R2 sufficientemente grande (> 0,9), la presenza di multicollinearità di solito non influisce sulle qualità predittive del modello. Questa affermazione sarà giustificata se le stesse relazioni tra le variabili correlate permarranno anche in futuro.

Se lo scopo dello studio è determinare la misura in cui ciascuna variabile esplicativa influenza la variabile dipendente, allora la presenza di multicollinearità, che porta ad un aumento degli errori standard, probabilmente distorce le vere relazioni tra le variabili. In questa situazione, la multicollinearità è un problema serio.

Multicollinearitàè la correlazione di due o più variabili in un'equazione di regressione. In presenza di multicollinearità, le stime OLS esistono formalmente, ma presentano una serie di svantaggi:

1) un piccolo cambiamento nei dati iniziali porta ad un cambiamento significativo nelle stime di regressione;

2) le stime hanno errori standard ampi e bassa significatività, mentre il modello nel suo insieme è significativo (l'indice di determinazione ha un valore elevato).

Il motivo principale del verificarsi della multicollinearità è la presenza nell'oggetto studiato che influenzano contemporaneamente alcune variabili di input, ma non vengono prese in considerazione nel modello. Ciò può essere il risultato di una ricerca di scarsa qualità sull'area tematica o della complessità delle relazioni tra i parametri dell'oggetto studiato.

Esistono due tipi di multicollinearità: completa e parziale.

Ad esempio, se in un modello le variabili esplicative sono legate da una relazione lineare, l'equazione originale viene ridotta a una semplice equazione di relazione lineare.

L'ultima equazione non permette di separare i contributi alla spiegazione del comportamento della variabile.

Pieno La multicollinearità (perfetta) si verifica quando esiste una relazione funzionale lineare tra le variabili.

Parziale La collinearità (imperfetta) si verifica quando esistono relazioni statistiche lineari sufficientemente strette tra le variabili esplicative.

La multicollinearità imperfetta dei fattori è caratterizzata dall'entità del coefficiente di correlazione tra loro. Quanto maggiore è il coefficiente di correlazione, tanto più difficile sarà separare l'influenza delle variabili esplicative e tanto meno affidabili saranno le stime dei coefficienti di regressione per queste variabili. Pertanto, se, durante la stima dell'equazione di regressione, diverse variabili esplicative risultassero insignificanti, è necessario scoprire se qualcuna di esse è fortemente correlata tra loro. Per fare ciò, viene calcolata una matrice di correlazione (fornita dai pacchetti statistici standard) e viene controllata la significatività statistica dei coefficienti di correlazione a coppie. Se esiste una forte correlazione (il coefficiente di correlazione in valore assoluto è maggiore di 0,7), uno dei due fattori correlati viene escluso o alcune delle loro funzioni vengono prese come variabile esplicativa. Se solo una variabile risulta insignificante, può essere esclusa o sostituita con un'altra.

Per valutare la presenza di multicollinearità, è possibile utilizzare il determinante della matrice di correlazione tra fattori e il significato della multicollinearità dei fattori può essere valutato utilizzando la statistica.

In alcuni casi, la multicollinearità non è un problema così serio da dover essere identificato ed eliminato. Tutto dipende dagli obiettivi dello studio. Se il compito principale della modellazione è solo quello di prevedere i valori della variabile dipendente, quindi con un coefficiente di determinazione sufficientemente grande (), la presenza di multicollinearità non influisce sulle qualità predittive del modello. Se lo scopo della modellazione è determinare il contributo di ciascun fattore alla variazione della variabile dipendente, allora la presenza di multicollinearità è un problema serio.

Il metodo più semplice per eliminare la multicollinearità è escludere una o più variabili correlate dal modello.

Poiché la multicollinearità dipende direttamente dal campione, è possibile che con un campione diverso non vi sia alcuna multicollinearità o la situazione non sia così grave. Pertanto, per ridurre la multicollinearità, in alcuni casi è sufficiente aumentare la dimensione del campione.

In alcuni casi, il problema della multicollinearità può essere risolto modificando le specifiche del modello: o si cambia la forma del modello, oppure si aggiungono fattori che non erano stati presi in considerazione nel modello originale, ma influenzano significativamente la variabile dipendente.

Letteratura:

1. Eliseeva I.I. Econometria: libro di testo. M.: Finanza e Statistica, 2008.

2. Borodich S.A. Econometria: libro di testo. Mn.: Nuove conoscenze, 2001.

3. Kremer N.Sh. Econometria: un libro di testo per studenti universitari. M.: UNITY-DANA, 2008.