Со всеми людьми, мало-мальски серьезно интересующимися компьютерным «железом», стабильно происходит одна и та же история. Раз в год объявляется какой-нибудь друг/ приятель/ знакомый, который просит помочь ему с выбором компонентов и сборкой нового компьютера.

Со мной, по роду занятий, подобное происходит намного чаще, стандартные типажи таких «просителей» я уже знаю наперечет. По сути их два: «печатная машинка дешево» и «чтоб в игрушки поиграть». Если с первыми все ясно (достаточно посоветовать простейший системник из любого магазина электроники), то желающие играть в современные игры гораздо более разборчивы и привередливы. В них всегда борются стремления сэкономить и собрать «машинку» помощнее, поэтому необходимо подобрать лучшие компоненты по соотношению цена-качество.

Самый больной вопрос – выбор видеокарты, ведь именно от производительности графической системы по большей части и зависит комфортный уровень FPS в играх. Понятно, что идеальный вариант – это топовая видеокарта AMD/NVIDIA текущего поколения. Но флагман дорог и «страдает» высоким уровнем энергопотребления, что дополнительно «раздувает» цену системника за счет мощного блока питания. Еще один момент – современные сверхмощные ускорители, обитающие на вершинах модельных линеек, по-настоящему востребованы в трех-пяти самых «тяжелых» играх, да и то в высоких разрешениях и с форсированным сглаживанием.

Идеальным вариантом для такого требовательного, но бережливого геймера будет третья-четвертая по старшинству видеокарта в ассортименте. Эти ускорители еще называют «народными», за их широкую распространенность. Причем чаще всего речь идет не о дешевых «базовых» ускорителях, а именно о «золотой» середине, - картах из ценового диапазона $180-250. За примерами далеко ходить не надо: пару поколений назад я советовал подешевевшие GeForce GT/GTS 8800, потом Radeon HD 4850, потом были GeForce GTS 250 или Radeon HD 5770 и так далее.

В общем, рецепт тут простой: чтобы не очень дорого и все игры шли на настройках, близких к максимальным. При этом для большей популярности карты есть еще несколько обязательных качеств: не слишком высокое энергопотребление, хорошие разгонные возможности, удачная «референсная» система охлаждения.

Оба ведущих производителя графических карт уже давно уделяют повышенное внимание этому сегменту, который условно именуется «Middle-High». Но в этот раз борьба за кошельки покупателей развернулась с новой силой, компания AMD впервые представила новое поколение ускорителей не «топом», а именно такими карточками «верхнего-среднего уровня» - Radeon HD 6870/6850. В NVIDIA тоже нашли, чем ответить, релиз нового ускорителя GeForce GTX 560 Ti обставлен чуть ли не более помпезно, чем старт продаж «топов» GTX 580/570.

Инженеры компании попытались создать видеокарту «запрограммированную на успех» по тем принципам, которые я описал выше. Недаром в официальном пресс-релизе новую карту именуют не иначе как «sweet spot» (английская идиома, которую можно перевести приблизительно как «золотая середина» или «самое то»). Человечком-символом нового ускорителя стал Hunter (Охотник), знакомьтесь:

NVIDIA давно балуется этими «комиксовыми» образами киборгов, символизирующих новые видеоускорители. Если для GTX 580 персонажем стал тяжелобронированный робот-штурмовик, то тут персонаж более худосочный, но со здоровенной пушкой – эдакий «мал-да-удал» во плоти.

Еще один интересный факт: в официальной презентации несколько страниц уделено сравнению новинки с... нет, не с конкурентами из стана AMD, и даже не с ускорителями предыдущего поколения, а со старушкой GeForce GT 8800, которая в свое время позиционировалась точно также, и нашла немало покупателей. Еще один подтекст – «эй, экономный обладатель карты 8800-й серии, который выжидал все эти годы – самое время для апгрейда».

А какую ностальгию вызывает суффикс Ti в названии… Помнится, когда-то он обозначал принадлежность к мощной серии Titanium, но ни разу не использовался со времен GeForce 4000, а это 2003 год! Вот такое возвращение к корням, спустя восемь лет. Если так пойдет и дальше, карты в поколении GeForce 600 должны получить аббревиатуры FX и PCX, а там, глядишь, и до Riva TNT3 дойдет.

В стремлении сделать видеокарту еще более привлекательной для покупателя, специалисты NVIDIA уделили страничку описанию выдающихся разгонных качеств новинки, что не очень-то характерно для этой компании.

Итак, инженеры постарались «запрограммировать» GeForce GTX 560 Ti на успех, точно попав в популярную нишу. Но удалось ли смешать сей коктейль из цены, производительности и прочих потребительских характеристик в правильной пропорции? Сегодня я постараюсь ответить на этот вопрос. Для начала необходимо ознакомиться с «сухими цифрами» - данными об архитектуре и чистой производительности новинки.

Архитектура

Для пущей наглядности я составил специальную табличку с кратким описанием архитектуры семи видеокарт. Четыре из них относятся к прошлому поколению GeForce 400, три другие – к современному GeForce 500 (включая GTX 560 Ti).

| Модель видеокарты | GeForce GTX 470 | GeForce GTX 480 | GeForce GTX 560 Ti | GeForce GTX 570 | GeForce GTX 580 | |

| Графический процессор | GF104 | GF100 | GF100 | GF114 | GF110 | GF110 |

| Технологический процесс, нм | 40 | 40 | 40 | 40 | 40 | 40 |

| Количество транзисторов, млн штук | ~1950 | ~3000 | ~3000 | ~1950 | ~3000 | ~3000 |

| Площадь кристалла, мм 2 | 367 | 529 | 529 | 367 | 520 | 520 |

| Количество кластеров обработки графики | 2 | 4 | 4 | 2 | 4 | 4 |

| Количество потоковых мультипроцессоров | 7 | 14 | 15 | 8 | 15 | 16 |

| Количество скалярных процессоров | 336 | 448 | 480 | 384 | 480 | 512 |

| Количество блоков растеризации | 24/32 | 40 | 48 | 32 | 40 | 48 |

| Число накладываемых текстур за проход | 56 | 56 | 60 | 64 | 60 | 64 |

| Объём cache L1, Кб | 112 | 224 | 240 | 128 | 240 | 256 |

| Объём cache L2, Кб | 384/512 | 640 | 768 | 512 | 768 | 768 |

| Разрядность шины видеопамяти, бит | 192/256 | 320 | 384 | 256 | 320 | 384 |

| Тип используемой памяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

Такое сравнение интересно тем, что можно более наглядно увидеть «ступеньки» в модельном ряду двух последних поколений.

Здесь необходимо отметить, что в четырехсотой серии еще была промежуточная карта GeForce GTX 465, представлявшая собой «обрезок» GTX 470. Особой популярности эта карточка не сыскала, и запомнилась разве что возможностью «разблокировать» некоторые экземпляры до полноценной 470-ой путем перепрошивки BIOS. В итоге, в «старой» модельной гамме NVIDIA была дополнительная ступенька, отделявшая флагманские ускорители на базе GPU GF100 от более доступных видеокарт, использующих процессор GF104.

На сегодняшний день нет даже намека на то, что NVIDIA собирается выпустить видеокарту GTX 565, поэтому модельный ряд выглядит проще: GTX 580-570-560. Соответственно, и разрыв между ускорителям на базе топового GPU GF110 и младшими картами с GF114 должен быть немного меньше.

Также отмечаю, что модель GeForce GTX 460 существует в двух модификациях – с 768 и 1024 Мбайтами видеопамяти. В данном случае это важно, так как помимо сокращенного объема GDDR5 младшая карта располагает меньшим количеством блоков растеризации и более узкой 192-битой шиной. Таким образом, под обозначением GTX 460 на самом деле существую две платы, производительность которых может разниться на 10-20% в зависимости от условий. Для GTX 560 Ti «облегченная» версия пока не предусмотрена.

Общеизвестно, что новый флагманский GPU NVIDIA – GF110 является переработанной версией GF100 предыдущего поколения. То же можно сказать и о GF114 в сравнении со старым GF104. В целом компоновка элементов процессора осталась неизменной, новые блоки ядра были взяты из резервов, заложенных в конструкцию изначально. Сообщается, что GF114 должен обладать меньшим уровнем тепловыделения, поскольку производится по хорошо обкатанному техпроцессу, а в конструкцию внесены незначительные «оптимизации». Ранее то же самое говорили о GF110.

Более конкретно. Если сравнивать GeForce GTX 560 Ti и GeForce GTX 460 1024 Мбайта (как самую близкую по классу видеокарту предыдущего поколения), то нужно отметить рост числа потоковых процессоров с 336 до 384 штук (прибавка ~14,2%). Это означает, что инженеры компании наконец-то активировали последний (восьмой) графический кластер ядра GF104/114, представив полноценную версию этого GPU. Не правда ли, ситуация очень напоминает таковую с «апгрейдом» GTX 480 до GTX 580? В том случае также был задействован последний кластер ядра (шестнадцатый по счету), который раньше «спал», но был предусмотрен конструкцией еще в прошлом поколении.

Добавление лишнего кластера обеспечило увеличение количества текстурных блоков с 56 до 64 штук (прибавка - все те же 14,2%). По этому параметру новая карточка сравнялась с флагманской GTX 580 и превосходит такие видеокарты, как GTX 470, GTX 480 и даже GTX 570 (которая априори дороже и относится к тому же поколению). А вот блоки растровых операций (ROP) связаны не с отдельными кластерами, а с общими для всего ядра контроллерами памяти (по 8 штук на каждый из 64-битных контроллеров), соответственно, их количество (32 штуки) не увеличилось.

Если считать только потоковые процессоры (занятие неблагодарное, но сама NVIDIA любит этим заниматься), то лесенка по трем старшим видеокартам в прошлом поколении была такая 480 –> 448 -> 336 (отношение 1 -> 0,93 -> 0,7), а в нынешнем 512 -> 480 -> 384 (отношение 1 –> 0,94 -> 0,75). То есть, между двумя старшими картами (GTX x80 и GTX x70) сохранился паритет, а «шестидесятая» чуть подтянулась к ним и теперь представляет собой «три четверти» флагмана, что очень неплохо при такой-то разнице в стоимости!

Но такие «бумажные» сравнения архитектур ничто, без учета рабочих частот, стоимости и других параметров реальных видеокарт. Чтобы прояснить картину, предлагаю ознакомиться со следующей таблицей.

| Наименование видеокарты | GeForce GTX 460 (768/1000 Мбайт) | GeForce GTX 470 | GeForce GTX 480 | GeForce GTX 560 Ti | GeForce GTX 570 | GeForce GTX 580 |

| Дата релиза | 12 июля 2010 | 26 марта 2010 | 26 марта 2010 | 25 января 2011 | 7 декабря 2010 | 9 ноября 2010 |

| Графический процессор | GF104 | GF100 | GF100 | GF114 | GF110 | GF110 |

| Тактовая частота ядра, МГц | 675 | 607 | 700 | 822 | 732 | 772 |

| Тактовая частота шейдерного домена, МГц | 1350 | 1215 | 1401 | 1644 | 1464 | 1544 |

| Тип графической памяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

| Объем видеопамяти, Мбайт | 768/1024 | 1280 | 1536 | 1024 | 1280 | 1536 |

| Разрядность шины памяти, бит | 192/256 | 320 | 384 | 256 | 320 | 384 |

| Реальная/эффективная частота графической памяти МГц | 900/3600 | 837/3348 | 924/3696 | 1002/4008 | 950/3800 | 1002/4008 |

| Полоса пропускания памяти, Гбайт/c | 86,4/115,2 | 134 | 177,4 | 128,3 | 152 | 192,4 |

| Заполнение сцены, млрд пикс / | 16,2/21,6 | 24,3 | 33,6 | 26,3 | 29,28 | 37,0 |

| Заполнение сцены, млрд текс / | 37,8 | 34,0 | 42,0 | 52,5 | 43,9 | 49,4 |

| Производительность FP32, Гфлопс | 907,3 | 1088,6 | 1344,9 | 1259,5 | 1405,4 | 1581 |

| Производительность FP64, Гфлопс | 113,4 | 136,1 | 168,1 | 157,4 | 175,7 | 197,6 |

| TDP, Вт | 150/160 | 215 | 250 | 170 | 219 | 244 |

| Рекомендованная стоимость на момент релиза, USD* | 199/229 | 349 | 499 | 249* | 349 | 499 |

*предварительные данные

А вот это уже интереснее. В сравнении с GeForce GTX 460 исследуемая новинка функционирует на значительно повышенных частотах. Так частота GPU была увеличена с 675 до 822 МГц (прирост составляет 147 МГц или 21,7%). В сочетании с увеличенным количеством исполнительных блоков ядра такая прибавка выглядит еще более весомо, вкупе все это может обеспечить новому ускорителю преимущество в производительности на уровне 25-30%. Также на этот факт указывают данные по «математике» (FP32, FP64) и скорости заполнения сцены.

Кстати, штатные частоты новой видеокарты приблизительно соответствуют тем значениям, которые достигаются при разгоне GeForce GTX 460. В подтверждение можно процитировать по GTX 460, составленный посетителями форума сайт на основе многочисленных сообщений о разгоне этих видеокарт:

…частоты в диапазоне 800-850/1600-1700/4000-4200 являются оптимальными, дальнейший разгон, как правило, требует смены СО, а также большого увеличения вольтажа.

А ведь по заверениям производителя новинка должна очень неплохо разгоняться. Похоже, даже разогнанная GTX 460 никак не сможет потягаться с GTX 560, которая способна уйти «в отрыв».

«Бумажные» показатели производительности очень неточно отражают реальную расстановку сил. Но кое-что по ним определить все-таки можно. Например, по вычислительной мощности и скорости заполнения сцены GeForce GTX 560 Ti здорово обходит GeForce GTX 470. Для этого есть все предпосылки, новая карта уступает 470-ой по количеству потоковых процессоров (на 16,7%) и блоков растеризации (на 25%), зато функционирует на гораздо более высоких частотах (+ 35,4%) и располагает 64 «текстурниками» против 56 у конкурента (+14,2%). Такие данные позволяют надеяться на победу или по крайней мере паритет в борьбе даже с таким грозным соперником. Если верить цифрам, исследуемая видеокарта может подобраться довольно близко и к GeForce GTX 480 или GTX 570, особенно после хорошего разгона.

Немаловажный момент в этой связи – скорость обмена с видеопамятью. Какой толк от производительного высокочастотного GPU, если он «упрется» в узкую полосу пропускания? Да, GeForce GTX 560 Ti и GeForce GTX 460 1024 Мбайта оснащены всего лишь 256-битной шиной, но сегодня это уже не выглядит таким уж минусом: вспомним флагманские видеокарты AMD. Причиной тому – память GDDR5, рабочие частоты которой позволяют получить приличную полосу пропускания. GeForce GTX 560 Ti показывает скорость обмена 128,3 Гбайт/c при эффективной частоте памяти 4008 МГц. Это на 11,3% больше, чем у GeForce GTX 460 1024 Мбайт, и очень близко к показателю GeForce GTX 470. Остальные участники сравнения с широкими 320 и 384-битными шинами уходят далеко вперед. Остается надеяться на разгон, но и базовое значение не выглядит низким.

С теорией разобрались, осталось рассмотреть важные «практические» вопросы энергопотребления и цены.

Новая видеокарта получилась чуть более прожорливой, чем предшествующие GTX 460. Прирост невелик, 170 Вт против 150/160, и это при значительном росте частоты графического процессора и видеопамяти. Очевидно, свою роль сыграли те самые таинственные «оптимизации» техпроцесса, которые по заявлению NVIDIA привели к снижению энергопотребления GF114 на фоне GF104. Интересно также отметить, что GeForce GTX 470, которая на бумаге уступает GTX 560 Ti по производительности, потребляет на 45 Вт больше.

Важно и то, что относительно невысокое потребление позволит легче объединять пару таких карт в SLI, обходясь блоками питания приемлемой мощности. А ведь GTX 460 – это настоящий хит для любителей SLI, такая система при меньшей стоимости часто обходит даже самые мощные одиночные видеокарты, наследница этой конфигурации на базе пары 560-х может стать еще более популярной связкой. Единственное ограничение тут – цена.

А вот с этим есть проблема. Новый ускоритель оказался дороже GTX 460 1024 Мбайт на $20, а младшей GTX 460 768 Мбайт аж на $50. И это только с учетом отпускной цены на момент релиза! Сейчас GTX 460 обеих модификаций успела изрядно подешеветь, и еще больше цена на эту карту упадет после выхода новинки. Та, в свою очередь, поначалу будет стоить очень дорого. Зная реалии российской розницы, я не сильно ошибусь, если назову цифру около 10.000 рублей на первое время. Такой ценник может отпугнуть изрядную часть покупателей, и свести на нет все преимущества нового ускорителя, ведь в «средний класс» он уже не попадает. К счастью, за месяц-другой ситуация просто обязана измениться лучшую сторону.

Подведу итоги раздела. Новинка, призванная заменить GeForce GTX 460, получилась чуть более прожорливой и дорогой. С другой стороны, это справедливо, ведь по моим выкладкам, новая карта стоит чуть ближе к флагманам своего поколения, чем предшественница. Благодаря увеличенным частотам GPU и видеопамяти, ускоритель значительно превосходит GTX 460 и может составить конкуренцию GTX 470. Недостаточная пропускная способность 256-битной шины успешно компенсирована повышением частоты видеопамяти типа GDDR5.

А теперь самое время познакомится с этим «бумажным драконом» воочию.

Конструкция видеокарты

Итак, новая видеокарта перед вами. О ее принадлежности к семейству GeForce 500 свидетельствует незамысловатая графика в виде наклонных полос на кожухе, точно такую же автор видел на GeForce GTX 580 и GTX 570.

Исследуемая видеокарта компактнее своих старших сестер на базе графического процессора GF110. Длина ускорителя составляет ровно 9 дюймов или 227,7 мм в более привычной для нас метрической системе, модели на базе графического процессора GF 110 длиннее – 10,5 дюйма или 267 мм. Высота большинства полноразмерных видеокарт GeForce одинакова и составляет 111 мм. Сравнивая новый ускоритель с GeForce GTX 460, легко заметить, что 560-ая длиннее. Если быть точным, разница составляет почти 18 мм.

Таким образом, GeForce GTX 560 Ti остается крупным ускорителем, хотя проблем с размещением в стандартных корпусах быть не должно.

Негативный момент – подключение шнуров дополнительного питания «сзади»:

Это вопрос личных предпочтений, но я считаю более удачным подключение шнуров «сверху», так как в этом случае видеокарту чуть проще извлечь из корпуса. Кроме того, экономится место за ускорителем, где часто располагается корзина с жесткими дисками, от которых вдобавок отходят собственные шнуры. С другой стороны, подключение «сзади» выгоднее тем, что провода не торчат. Это понравится пользователям, которые любят идеально «прятать» проводку и оптимизировать воздушные потоки в корпусе.

Кстати, для дополнительного питания видеокарты используются два шестиштырьковых разъема дополнительного питания. Заявленный уровень энергопотребления, как я уже писал выше, составляет 170 В. При этом производитель рекомендует использовать в связке с GTX 560 Ti блок питания мощностью не менее 500 Вт, что по нынешнем временам уже очень немного для игрового компьютера.

На заднюю панель видеокарты выведено два разъема DVI и один mini-HDMI. Этот набор является стандартным для старших GeForce, идентичная задняя панель применяется на всех GeForce GTX двух последних поколений.

Ключевое отличие GeForce GTX 560 Ti от старших видеокарт, которое легко заметить при внешнем осмотре – это компоновка. На данном ускорителе используется обычный девятилопастной вентилятор, в то время как GTX 570/580 оснащаются центробежным (его еще часто называют «турбиной»). В очередной раз отмечаю, что конструкция с центробежным вентилятором, на мой взгляд, является более совершенной, из-за «выдува» нагретого воздуха за пределы корпуса и оптимального прохождения воздушного потока вдоль поверхности платы.

В принципе, рассматриваемая видеокарта целиком закрыта кожухом, так что воздушный поток также должен направляться в сторону решетки на задней панели, и выдуваться из корпуса. Однако боковые грани кожуха снабжены прорезями, да и в передней части видеокарты возле разъемов дополнительного питания есть «окно». Простейший тест ладонью показал, что система охлаждения выдувает воздух во всех направлениях, а через решетку проходит совсем слабый поток.

Для повышения эффективности работы вентилятора пластиковый кожух в центре немного прогнут; таким образом в одном из положений лопасти сильнее выступают над поверхностью, что позволяет им захватить чуть больше воздуха. Хорошая проработка деталей.

Рассмотрю систему охлаждения более подобно. Разборку можно осуществлять в разном порядке, но я для начала отделил пластиковый кожух СО, чтобы лучше рассмотреть устройство системы в сборе.

Интересная конструкция, которая внешне напоминает какой-то сумасшедший вертолет в стиле «стимпанк». Но, опустив сравнения, гораздо важнее, что в основе системы лежат три тепловые трубки диаметром 6 мм. Одна из трубок уходит в веерообразный радиатор возле задней панели видеокарты, две других – в похожий радиатор, расположенный «позади» вентилятора. Дополнительный округлый радиатор расположен прямо под крыльчаткой и смыкается с основанием. Конструкция здорово напоминает фирменную разработку MSI – так называемый Cyclone, только сильно уменьшенный в размерах. В одной из моих старых-старых статей было такое фото:

К слову сходная система с двумя «веерами» вокруг вентилятора применялась и на эталонной GeForce GTX 460, различие в количестве тепловых трубок – раньше их было только две. Система получила «усиление» из-за увеличенного TDP видеокарты, и это вселяет надежду на успешный разгон.

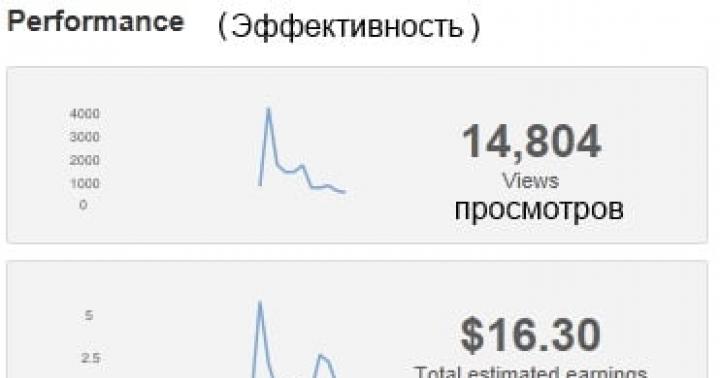

Видеокарта GeForce GTX 560 Ti вышла очень удачным продуктом. Дополнительные вычислительные блоки и повышенные частоты помогли достичь огромного прироста в производительности относительно предшественника GeForce GTX 460 . Но, несмотря на свои характеристики, новинка имеет еще и хороший разгонный потенциал, и многие производители выпустили модели с заводским разгоном. Мы уже рассмотрели несколько видеоадаптеров от Palit и Gainward , которые продемонстрировали возможность работы на частоте ядра вплоть до 950/1900 МГц. Графические ускорители, с которыми познакомимся в данной статье, можно назвать настоящими чемпионами, ведь они работают на еще более высоких частотах. Gigabyte GV-N560SO-1GI и Sparkle Calibre X560 имеют различный дизайн платы, разные системы охлаждения, но объединяет их одно — частота GPU в 1000/2000 МГц.

Начнем мы с обзора видеокарты производства Gigabyte. GV-N560SO-1GI — это старшая модель в линейке продуктов серии GTX 560 Ti. Нам в руки попал образец без упаковки и аксессуаров. Так что сразу переходим к рассмотрению видеоадаптера без описаний коробки и комплектации.

Карта оснащена фирменным «антитурбулентным» кулером WindForce 2X с двумя вентиляторами. Его особая изогнутая форма — отличительная черта систем охлаждения Gigabyte.

Набор внешних разъемов представлен двумя DVI и одним mini HDMI.

Радиатор системы охлаждения включает 50 тонких пластин, нанизанных на четыре медные тепловые трубки, выходящие из основания.

Медное основание по размерам небольшое, и, как видно по отпечатку термопасты, края чипа контактируют уже с алюминиевой рамкой вокруг медного центра. GPU накрыт довольно большой теплораспределительной крышкой прямоугольной формы. Если и кристалл имеет такую вытянутую форму, то отвод тепла от его краев через алюминиевую рамку будет хуже.

Радиатор имеет изогнутую форму из-за наклонного расположения обдувающих вентиляторов. Такая конструкция позволяет реализовать более эффективный обдув всей конструкции.

Вентиляторы (Everflow T128010SM) крепятся к верхнему пластиковому кожуху.

Их диаметр составляет около 80-мм и они имеют изогнутые полупрозрачные лопасти.

На силовые элементы узла питания установлен небольшой алюминиевый радиатор.

Дизайн PCB качественно переработан, плата длиннее стандартной.

Видеоадаптер изготовлен по внутреннему стандарту Gigabyte — Ultra Durable VGA+, который подразумевает использование высококачественной элементной базы (конденсаторы с твердым электролитом, МОП-транзисторы с пониженным сопротивлением открытого канала) и удвоенную толщину медных токопроводящих слоев. На задней стороне платы в схеме фильтрации выходного напряжения используется конденсатор повышенной емкости Proadlizer NEC/TOCIN.

Система питания ядра включает шесть фаз под управлением ШИМ-контроллера ADP4100 от ON Semiconductor.

Видеокарта имеет расширенные возможности по управлению рабочих напряжений и частот. Традиционно, программной оболочкой для всех этих возможностей служит фирменная утилита Gigabyte OC Guru. Также каждая фаза имеет свой светодиод-индикатор на обратной стороне платы. Аппаратно функции контроля, мониторинга и индикации реализованы с помощью PIC-контроллера PIC16F690 и GPIO-контроллера W83L604G.

Для видеокарт серии Super Overclock по словам производителя отбираются лучшие графические процессоры GF114.

Объем видеобуфера стандартный — один гигабайт. Набран восемью микросхемами Samsung K4G10325FE-HC04, которые рассчитаны на рабочие частоты в 5 ГГц.

Как уже упоминалось выше, GPU работает на 1000/2000 МГц. О таком разгоне на Palit и Gainward мы могли только мечтать. Память тоже функционирует на повышенных частотах — 4580 МГц вместо стандартных 4008 МГц. Итоговый прирост по тактовым частотам относительно референса составляет 21,5% для ядра и 14% для памяти. Впечатляет.

В игровых приложениях ядро прогревалось до 69 °С при 23 градусах в помещении. Такой хороший показатель во многом обеспечен высокой скоростью вращения вентиляторов — более 2800 об/мин. Тихой карту в таких условиях не назвать, но шум вполне умеренный и терпимый.

Напряжение питания ядра в 1,0 В довольно низкое для 1 ГГц. Но не будем забывать о специальном отборе чипов, да и в реальности напряжение может немного отличаться от того, что показывает программный мониторинг.

Нам, конечно же, было интересно, получится ли выжать что-то еще сверх 1 ГГц. Оказалось, что это полнее возможно, хотя итоговый прирост вышел довольно скромным. Стабильности удалось добиться лишь на 1015/2030 МГц при напряжении 1,012 В. Большие частоты требовали еще больших напряжений, но видеокарта не выдерживала продолжительную нагрузку. При более мощном радиаторе на VRM можно было надеяться получить еще пару десятков мегагерц «на воздухе». Память без особых проблем работала на частоте в 2480 (4960) МГц, но красивая цифра в 5 ГГц не покорилась.

Для такого небольшого относительно начальных характеристик разгона пришлось поднимать обороты обдувающих вентиляторов до 100% для достижения полной стабильности.

А вот пройти 3DMark 11 нам удалось при частотах 1035/2070/4970 МГц и напряжении 1,025 В. Как видим, потенциал у карты еще есть.

Такой внушительный разгон с воздушным кулером говорит и о хорошем частотном «запасе» для экстремального оверклокинга при охлаждении жидким азотом.

Следующий чемпион попал к нам в полном обмундировании, т.е. в коробке с полноценной комплектацией.

Стиль оформлений упаковки довольно простой, но выглядит все солидно. Название модели и ее технические характеристики приведены на наклейке с обратной стороны.

Комплект поставки включает:

- переходник DVI/D-Sub;

- два переходника питания molex/PCI-E;

- кабель mini-HDMI/HDMI;

- диск с драйверами;

- инструкции.

На заднюю панель выведены два разъема DVI и один mini-HDMI.

Кулер Accelero имеет простую конструкцию — 35 пластин нанизаны на четыре медные тепловые трубки. Форма пластин простая, они приподняты над основанием и кулер вместе с вентиляторами занимает три слота расширения.

Площадь основания немного меньше площади крышки кристалла. Трубки уложены в канавки, все хорошо пропаяно. Но сверху трубки ничем не накрыты, дополнительная пластина, прижимающая их к основанию, могла увеличить площадь контакта и немного поднять эффективность теплообмена.

На силовые элементы установлен скромный по размерам радиатор. Контакт осуществляется через термоклей.

Печатная плата выполнена по референсному дизайну. Необычный вид придает сочетание коричневого цвета текстолита и желтой окраски танталовых конденсаторов.

Подсистема питания GPU включает четыре фазы под управлением контроллера NCP5388, памяти — одну фазу.

Графический процессор GF114-400-A1 является наследником GF110, но оперирует уже всеми 384 потовыми процессорами.

Микросхемы памяти — Samsung K4G10325FE-HC04 со временем доступа 0,4 нс. Точно такие же распаяны у Gigabyte GV-N560SO-1GI.

Частотная формула Sparkle Calibre X560 — 1000/2000/4800 МГц. Память на 220 МГц быстрее, чем у представителя Gigabyte. Относительно стандартных характеристик мы имеем заводской разгон в 21,5% и 20% для ядра и памяти. И это единственный GeForce GTX 560 Ti на рынке со столь мощными частотными характеристиками.

При нашем стандартном 12-минутном тесте Crysis: Warhead на максимальных настройках качества в разрешении 1920x1200 со сглаживанием ядро прогрелось лишь до 65 °С (при 23 градусах в помещении). Великолепный результат, учитывая, что уровень шума меньше, чем у Gigabyte GV-N560SO-1GI.

Быстрее, холоднее и тише — идеальная карта? А вот и не совсем. Температура ядра хоть и низкая, но плата просто раскалена. Радиатор на силовых элементах справляется со своей задачей с трудом. Это и неудивительно, ведь размеры его скромные, а питающее напряжение GPU очень высокое — 1,037 В (хотя реальное его значение может быть и ниже). Наш экземпляр после полутора часа активной работы в игровых тестах стал вести себя немного нестабильно в некоторых приложениях. Можно поднять обороты обдувающих вентиляторов, но мы просто установили возле корпуса тихоходный вентилятор X-Silent 140 на 900 об/мин для обдува видеокарты. В современных корпусах почти всегда имеется вентилятор на боковой панели, так что их владельцы никогда не столкнутся с проблемами перегрева Calibre X560. А вот в корпусе с глухой стенкой и плохой вентиляцией использование видеокарты потребует ручной регулировки оборотов обдувающих вентиляторов кулера в сторону их увеличения.

В таких условиях выжать больше мегагерц из GPU не удалось. Хотя дело тут уже было не в перегреве, потенциал GF114 у этой видеокарты был явно меньше. Пройти все тесты нам удалось лишь на 1005 МГц. Зато память смогла покорить круглую цифру в 5 ГГц, но это дополнительно «подогревало» всю плату и мы даже немного снизили напряжение на ядре, чтобы спокойно пройти тесты на частотах 1005/2010/5000 МГц.

Итоговый разгон скромный, инженеры Sparkle изначально выжали все «соки» из референсного GeForce GTX 560 Ti. Продемонстрировать большее видеокарта может разве что при экстремальном охлаждении.

Характеристики тестируемых видеокарт

Поскольку мы рассматриваем самые быстрые версии GeForce GTX 560 Ti с весьма внушительным заводским разгоном, то мы решили сравнить их со старшими графическими решениями — GeForce GTX 580 и Radeon HD 6970. В роли первого выступит Zotac GeForce GTX 580 AMP! на пониженных частотах, в роли второго — ASUS EAH6970/2DI2S/2GD5 . Также в наше сравнение попал Radeon HD 6950 и простой GeForce GTX 560 Ti от Gainward , работающий на рекомендованных частотах.

| Видеоадаптер | GeForce GTX580 |

Gigabyte GV-N560SO -1GI |

GeForce GTX560Ti | Radeon HD6970 | Radeon HD6950 | |

| Ядро | GF110 | GF114 | GF114 | GF114 | Cayman XT | Cayman Pro |

| Количество транзисторов, млн. шт | 3000 | 1950 | 1950 | 1950 | 2640 | 2640 |

| Техпроцесс, нм | 40 | 40 | 40 | 40 | 40 | 40 |

| Площадь ядра, кв. мм | 520 | 332 | 332 | 332 | 389 | 389 |

| Количество потоковых процессоров | 512 | 384 | 384 | 384 | 1536 | 1408 |

| Количество текстурных блоков | 64 | 64 | 64 | 64 | 96 | 88 |

| Количество блоков рендеринга | 48 | 32 | 32 | 32 | 32 | 32 |

| Частота ядра, МГц | 772 | 1000 | 1000 | 823 | 880 | 800 |

| Частота шейдерного домена, МГц | 1544 | 2000 | 2000 | 1645 | 880 | 800 |

| Шина памяти, бит | 384 | 256 | 256 | 256 | 256 | 256 |

| Тип памяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

| Частота памяти, МГц | 4008 | 4800 | 4580 | 4008 | 5500 | 5000 |

| Объём памяти, МБ | 1536 | 1024 | 1024 | 1024 | 2048 | 2048 |

| Поддерживаемая версия DirectX | 11 | 11 | 11 | 11 | 11 | 11 |

| Интерфейс | PCI-E 2.0 | PCI-E 2.0 | PCI-E 2.0 | PCI-E 2.0 | PCI-E 2.1 | PCI-E 2.1 |

| Заявленная максимальная потребляемая мощность, Вт | 244 | n/a | n/a | 170 | 250-190 | 200-140 |

Тестовый стенд

Конфигурация тестового стенда следующая:

- процессор: Core i7-965 EE (3,2@3,95 ГГц, BCLK 172 МГц);

- кулер: Thermalright Venomous X;

- материнская плата: Gigabyte GA-X58A-UD3R (Intel X58 Express);

- память: G.Skill F3-12800CL8T-6GBRM (3x2GB, DDR3-1600@1720 МГц, 8-8-8-24-1T);

- жесткий диск: Hitachi HDS721010CLA332 (1 ТБ, SATA2, 7200 об/мин);

- блок питания: Seasonic SS-850HT (850 Вт);

- операционная система: Windows 7 Ultimate x64;

- драйвер Radeon: ATI Catalyst 11.3.

- драйвер GeForce GTX 450: NVIDIA GeForce 266.58;

- драйвер GeForce GTX 560 Ti: NVIDIA GeForce 266.66.

Результаты тестирования

Если обычный GeForce GTX 560 Ti не дотягивает до уровня Radeon HD 6950, то рассматриваемые модели от Gigabyte и Sparkle уверенно обходят этого конкурента.

Crysis: Warhead

В этой игре наблюдается полный триумф видеокарт Gigabyte и Sparkle. Они не уступают Radeon HD 6970, а при активном сглаживании даже немного обходят флагмана AMD по минимальному fps! Разница с GeForce GTX 580 составляет примерно 15% в режиме без сглаживания и до 20% при включенном антиалиасинга. Sparkle благодаря более высокой частоте памяти выигрывает до 1,5% у Gigabyte GV-N560SO-1GI.

Just Cause 2

В Just Cause 2 наши видеоадаптеры готовы даже немного потягаться с гигантом GeForce GTX 580 — они обходят его по минимальному fps, но по среднему показателю уступают. Немного странно, но аналогичная расстановка сил у нас была при первом тестировании GeForce GTX 560 Ti на более старых драйверах. Тогда по минимальной частоте кадров разогнанная новинка соперничала со старшими моделями. Старший Radeon может противостоять чемпионам только в простом режиме, при включении сглаживания он уступает им до 12-13% по среднему fps и более 25% по минимальному показателю.

S.T.A.L.K.E.R.: Call of Pripyat

Переходим к играм, поддерживающих DirectX 11.

Еще одна уверенная победа топовых GeForce GTX 560 Ti над Radeon HD 6970. Но в этот раз соперник AMD снижает отрыв до минимума, и именно в тяжелом режиме со сглаживанием.

Colin McRae: DiRT 2

В этой игре Radeon демонстрируют лучшие результаты при активном сглаживании. Впервые Radeon HD 6950 даже обходит старшие GeForce GTX 560 Ti, пусть и с мизерным преимуществом. Вот только производительности видеокарт для такого режима маловато и придется ограничиться режимами без сглаживания. И вот тогда уже наши GeForce занимают нишу между младшим и старшим Cayman.

В этом тесте рассматриваемые видеокарты по уровню производительности вновь оказываются между Radeon HD 6950 и Radeon HD 6970.

Выводы

Впечатления от обеих видеокарт исключительно положительные. Они демонстрируют отличный уровень производительности, легко обходя Radeon HD 6950, а в некоторых приложениях и старший Radeon HD 6970. Это просто великолепный результат, особенно если вспомнить, что речь идет о сравнении топового графического ускорителя AMD и моделей, которые в иерархии NVIDIA занимают третью позицию в списке производительных однопроцессорных графических ускорителей. Такой успех обеспечивается мощным заводским разгоном, который не каждому простому GeForce GTX 560 Ti по плечу.

Sparkle Calibre X560 является самым быстрым видеоадаптером среди GeForce GTX 560 Ti благодаря самым высоким частотам. При этом видеокарта еще довольно тихая и система охлаждения поддерживает очень низкую температуру GPU. Но вот на качественное охлаждение VRM производитель поскупился. Радиатор здесь такой же скромный, как и у Sparkle Calibre X460G . Но если для старой модели его хватало, то новинка будет стабильно работать при организации правильного охлаждения внутри корпуса. Дополнительный вентилятор на обдув или поднятие оборотов вентиляторов у кулера в сочетании со снижением питающего напряжения помогут избавиться от вероятности перегрева. Может и не идеальный во всех отношениях продукт, зато производительность его просто на высоте. Так что Calibre X560 заслуживает награду «Лучший продукт»!

Инженеры Gigabyte не ограничились стандартным дизайном. Их продукт имеет усиленную систему питания и более качественное исполнение. В номинале он немного уступает Sparkle Calibre, потому что рабочая частота памяти ниже на 220 МГц. Но на деле такая разница выливается в отставание в один процент, а то и меньше. Шум более заметный, но зато нет опасности перегрева компонентов, и все работает абсолютно стабильно. Но самое главное, что более качественный дизайн платы и более продуманное охлаждение обеспечивают еще и небольшой запас для дополнительного разгона. Это лучший выбор для геймера и оверклокера. И без сомнения, Gigabyte GV-N560SO-1GI «Лучший продукт»!

Оборудование для тестирования было предоставлено следующими компаниями:

- 1-Инком — память G.Skill F3-12800CL8T-6GBRM;

- Gigabyte — материнская плата GA-X58A-UD3R и видеокарта GV-N560SO-1GI;

- PCShop — видеокарта ASUS EAH6970/2DI2S/2GD5;

- Sparkle — видеокарта Calibre X560;

- Syntex — блок питания Seasonic SS-850HT (S12D-850);

- Thermalright — Thermalright Venomous X;

- Zotac — видеокарта Zotac GeForce GTX 580 AMP!

GeForce GTX 560 Ti | Введение

Ещё в июле прошлого года редакторы THG предположили, что nVidia выключил один из потоковых процессоров (Streaming Multiprocessor) на GeForce GTX 460 с графическим процессором GF104, чтобы избежать вытеснения видеокарты GeForce GTX 465 с рынка. Разве не интересно было бы увидеть версию этого чипа со всеми восемью включёнными потоковыми процессорами? Мы имели в виду, что GeForce GTX 460 уже заняла достойное место среди видеокарт с 336 ядрами CUDA и 56 текстурными блоками. И, конечно же, полнофункциональная версия этого видеочипа может бросить вызов более дорогим (и менее привлекательным) видеокартам GeForce. Также это может быть угрозой для видеокарт Radeon серии HD 6800, rоторые вышли на три месяца позже.

Логично, что nVidia поступила именно так. У GeForce GTX 465 и без GF104 хватает конкурентов. Впрочем, эти видеокарты уже не производятся. Так же стоит напомнить, что nVidia хочет полностью прекратить выпуск видеокарт, основанных на процессоре GF100.

GeForce GTX 470 - единственная видеокарта, оставшаяся у компании, которая использует оригинальную архитектуру Fermi. Она заполнила пробел в линейке видеокарт nVidia со стоимостью в $259 как раз между GTX 460 за $200 и GTX 570 за $349. Это учитывая стартовую цену в 350 долларов. Удивительно, как здоровая конкуренция положительно сказывается на нас, любителей поиграть, не так ли?

nVidia прекращает выпуск GF100 менее чем через год после первого анонса. На смену ему приходит видеокарта GeForce GTX 560 Ti. Вместо того, чтобы использовать графическое ядро версии GF104, в GTX 560 применён более продвинутый чип с улучшениями на уровне базовых элементов, впервые применённый в GeForce GTX 580.

В результате графический процессор, содержащий чуть менее чем два миллиарда транзисторов (1.95 миллиарда, по данным nVidia) соответствует или даже превосходит производительность GF100 с тремя миллиардами транзисторов, реализованных в видеокарте GeForce GTX 470.

GeForce GTX 560 Ti | Как создать более быстрый игровой графический процессор

Как мы все знаем, GeForce 500-й серии почти не отличается по архитектуре от 400-й серии.

Видеокарты GeForce GTX 580 и GTX 570 построены на GF110 – переработанной GF100 с улучшенной фильтрацией текстур, эффективным Z-отсечением, оптимизацией на уровне транзисторов, которая способствует увеличению показателей при равном энергопотреблении.

Таким же образом видеокарта Geforce GTX 560 Ti основана на процессоре GF114 – переделанной версии GF104. Вспомните, что в GF104 уже включены улучшения фильтрации текстур, которые не попали в GF100. То есть пропускная способность 64-битных текселей FP16 удвоена с двух за такт до четырех за такт в каждом текстурном блоке. У GF104 и GF110 есть эти возможности, у GF100 их нет. Более того nVidia решила не переносить улучшения по Z-отсечению в GF114, а вместо этого оставить растровый движок без изменений.

В конечном счёте, GF114 функционально идентичен GF104. По факту nVidia даже указывает такое же количество транзисторов (1.95 миллиарда) и графический процессор производится по такому же 40 нм технологическому процессу TSMC.

Модифицированный процессор работает на более высоких тактовых частотах с меньшим энергопотреблением, что даёт более высокую производительность, но это всё равно улучшенная версия GF104. Конечно, главное отличие в том, что для создания видеокарты GTX 460 nVidia отключает у GF104 один из потоковых процессоров, а в GeForce GTX 560 Ti использует не "обрезанный" GF114. В сравнении с GTX 460 это означает больше тактов, больше ядер CUDA, и, теоретически, лучшую производительность в геометрии, благодаря восьми полиморфным движкам и восьми дополнительным текстурным блокам. Все эти факторы в совокупности создают видеокарту не только полностью заменяющую GeForce GTX 460, но и достаточно быструю, для того, чтобы затмить GeForce GTX 470.

GeForce GTX 560 Ti | Эти характеристики выглядят знакомыми

Если вы уже знакомы с GF104, то эта глава для вас будет чем-то вроде прошлогоднего учебника по GPU101. GF114 состоит из двух GPC (Graphics Processing Clusters), каждый с четырьмя потоковыми процессорами. Как вы уже знаете, все восемь потоковых процессоров полностью включены в GeForce GTX 560 Ti.

|

GF100/GF110 SM

|

GF104/GF114 SM

Ниже мы приведём небольшой отрывок из обзора GeForce GTX 460, немного изменив его:

"В GF114 используется 48 ядер CUDA на SM, вместо 32 ядер на SM, как в GF100. Обеспечение этих более сложных SM информацией требует более высокой пропускной способности инструкций, поэтому мы видим ещё одно улучшение: увеличение блоков диспетчеризации на каждый SM с двух в GF100 до четырех в GF114. Кроме того, каждый SM теперь имеет восемь текстурных блоков (вместо четырех).

Проще говоря – это более "широкий" GPU, чем GF100 и GF110. Результат – улучшенная производительность по сравнению с GF100 в наиболее популярных игровых приложениях.

|

GF114, реализованный в GeForce GTX 560 Ti

Внутри чип также немного отличается. Полный GF100 предлагает шесть независимых от GPC разделов растровых операций ROP, каждый из которых способен выводить восемь 32-х битных пикселей за такт (всего 48). Все шесть разделов связаны с 64-битной шиной памяти, что в сумме даёт шину в 384 бита. GF114 получает максимум из четырёх разделов, что даёт до 32 пикселей за такт и 256-битную шину".

GeForce GTX 560 Ti | Старые суффиксы, новые карты

Поскольку nVidia полностью включила GPU GF114, спецификации GeForce GTX 560 Ti полностью соответствуют графическому процессору. Благодаря 384 ядрам CUDA, получился GPU с большой производительностью шейдеров. Появляется 64 текстурных блока, благодаря 8 более широким SM. Их столько же, сколько и в GF110, однако, для поддержания такой же функциональности на флагманском GeForce GTX 580 требуется 16 SM. nVidia в состоянии обеспечить частоту GPU в 822 МГц, в то время как ядра CUDA работают на частоте 1644 МГц (соотношение 1:2 очевидно). Также как и GeForce GTX 460 1 Гбайт, видеокарта GeForce GTX 560 обладает четырьмя включенными разделами ROP, выдающими до 32 пикселей за такт. Четыре 64-битные шины составляют в сумме 256 бит. На видеокарте установлена видеопамять GDDR 5 объёмом 1 Гбайт с частотой 1002 МГц, что дает пропускную способность в 128.3 Гбайт/с.

| Технические характеристики видеокарт GeForce GTX | ||||

| GeForce GTX 560 Ti | GeForce GTX 570 | GeForce GTX 460 1 Гбайт | GeForce GTX 470 | |

| Graphics Processing Clusters (GPCs) | 2 | 4 | 2 | 4 |

| Streaming Multiprocessors (SMs) | 8 | 15 | 7 | 14 |

| Ядра CUDA | 384 | 480 | 336 | 448 |

| Количество текстурных модулей | 64 | 60 | 56 | 56 |

| ROP блоки | 32 | 40 | 32 | 40 |

| Частота графического процессора, МГц | 822 | 732 | 675 | 607 |

| Частота шейдерных блоков, МГц | 1644 | 1464 | 1350 | 1215 |

| Частота памяти (скорость передачи данных) | 1002 МГц (4008 MT/s) | 950 МГц (3800 MT/s) | 900 МГц (3600 MT/s) | 837 МГц (3348 MT/s) |

| Объём видеопамяти GDDR 5, Гбайт | 1 | 1.25 | 1 | 1.25 |

| Шина видеопамяти, бит | 256 | 320 | 256 | 320 |

| Пропускная способность памяти, Гбайт/с | 128.3 | 152 | 115.2 | 133.9 |

| Скорость наложения текстур, млрд./сек. | 52.6 | 43.9 | 37.8 | 34.0 |

| Технологический процесс (TSMC), нм | 40 | 40 | 40 | 40 |

| Форм-фактор | Двойной слот | Двойной слот | Двойной слот | Двойной слот |

| Внешние интерфейсы | 2 x DL-DVI, 1 x mini-HDMI |

2 x DL-DVI, 1 x mini-HDMI |

2 x DL-DVI, 1 x mini-HDMI |

2 x DL-DVI, 1 x mini-HDMI |

| Потребляемая мощность, Вт | 170 | 219 | 160 | 215 |

Внешне GeForce GTX 560 Ti выглядит также, как и GeForce GTX 460. Обе карты используют осевые вентиляторы, направляющие поток воздуха на массивные алюминиевые радиаторы с медным основанием. Обе карты двухслотовые с одинаковым количеством выходов, включающих два двухканальных DVI-разъёма и один мини-HDMI порт. Кроме того, обе карты требуют внешнее питание и оснащены парой вспомогательных шестиканальных входов.

|

Однако есть несколько различий. Длина GeForce GTX 560 Ti – 23см, а GTX 460 – 21см. Под пластмассовым кожухом GTX 560 можно увидеть на одну тепловую трубку больше, что позволить рассеять большее количество тепла. Есть также металлическая пластина, закрывающая чипы памяти и схему питания видеокарты. Раньше эти компоненты просто оставались открытыми.

Конечно, сейчас мы говорим об эталонном дизайне. В лаборатории уже появилось несколько видеокарт GTX 560 от сторонних производителей, не соответствующих референсной версии от nVidia. Например, видеокарта Gigabyte имеет длину 24 см, два вентилятора, 6+1 фаз стабилизатора питания (против 3+1 в референсной версии) и совершенно другую печатную плату.

nVidia оснащает свою эталонную модель той же схемой контроля питания, что и на видеокарте GeForce GTX 580. Эта схема предотвращает перегрузки схемы регулирования напряжения. Компания говорит, что включать их в GeForce GTX 560 Ti или нет – это дело производителей видеокарты.

GeForce GTX 560 Ti | Ах да, об этом Ti…

В зависимости от вашего возраста, суффикс Ti от NVidia GeForce GTX 560 Ti может иметь, а может и не иметь смысл. История заключается в том, что ещё в 2002 году nVidia ограничила "ориентированные на производительность" видеокарты суффиксом Ti, а "бюджетные" видеокарты суффиксом MX. В линейке GeForce Ti было несколько различных моделей, большинство было основано на GPU NV25, но мы отчетливо помним, что GeForce 4 Ti 4200 являлся лидером. Если у вас всё в порядке с поиском в интернете, то вы даже сможете найти несколько наших обзоров этой карты 2002 года.

Как бы там ни было, nVidia возвращает суффикс Ti. Когда компания спросила нас, что мы думаем о названии этой карты, мы сначала немного опешили. "Мило, парни". Но если посмотреть внимательнее, то название имеет смысл. GF114 – это микросхема, которая сможет управлять любой видеокартой. И вместо того, чтобы начинать морочить потребителю голову цифровыми индексами (GTX 555, GTX 550, и так далее) мы предполагаем, что в скором времени сможем увидеть GeForce GTX SE, если nVidia представит менее производительную копию GF114.

Дифференциация по суффиксу не настолько выразительна, как уже принятая система исчисления. Если вспомнить времена GeForce 4, тогда менее дорогие видеокарты серии MX были сняты с производства из-за того, что плелись за самыми медленными видеокартами GeForce 3 по производительности. В наши дни производительность ещё не всё, есть много базовых функций, которые стоит принять во внимание. Но даже сейчас, есть возможность запутать неподкованного человека, который уделяет больше внимания играм, чем "железу", которое он покупает.

К счастью, мы не думаем, что nVidia пойдёт на эти хитрости, но GeForce GTX 460 и GF104 ещё свежи в памяти. Возможно, также как и в июле, видеокарты партнеров начнут просачиваться на рынок с всё более и более агрессивными частотами (и более высокими ценами). К тому времени, когда AMD запустил свой GPU на основе Barts, NVidia пришлось нелегко, уговаривая кого-нибудь протестировать разогнанные видеокарты от партнёров, чтобы сравнивать их с эталонными видеокартами от AMD. Возможно, более тщательное сегментирование линейки GeForce GTX 560 не вызовет повторение этой ситуации, которая внутри nVidia вызвала много негатива.

GeForce GTX 560 Ti | Производительность тесселяции

Учитывая особое внимание, которое AMD первоначально уделяло тесселяции в DirectX 11, а также внимание, которое nVidia уделяет тесселяции в DirectX 11 сейчас, нам захотелось пропустить видеокарты обоих производителей через самый тяжёлый тест, чтобы оценить влияние архитектуры на производительность в геометрии. Этим тестом должен был стать Unigine Heaven Demo, но теперь, когда стал доступен игровой тест HAWX 2, мы решили переключиться с искусственного теста на него.

Тестируя видеокарты nVidia было интересно наблюдать, как менялась частота кадров в зависимости от количества полиморфных движков в образцах. Мы обнаружили, что возможности архитектуры Fermi не обязательно масштабируется линейно, как могла бы предположить nVidia. Это проявляется в том, что GTX 570 с процессором GF110 использует пятнадцать полиморфных движков, GTX 560 – восемь движков, а разница при включении/выключении тесселяции в HAWX 2 всего один процент. Очевидно, что геометрия - не критический параметр.

Ситуация с AMD не намного яснее. Cayman получил второй блок тесселяции, в то время как Barts обходится только одним, но всё равно масштабируется лучше. Единственное, что можно утверждать, это то, что архитектура Cypress предлагает больше при включённой тесселяции. Отличный вариант на сегодня – это Radeon HD 5870, особенно если его удастся найти с большой скидкой. Но если всё больше разработчиков будут следовать примеру Ubisoft с игрой HAWX 2, широко использующей геометрию, то понадобиться больше производительности, чем на оптимизированных под геометрическую нагрузку видеокартах Radeon HD 6000 серии.

GeForce GTX 560 Ti | Аппаратное обеспечение и тесты

| Конфигурация тестового стенда | |

| Процессор | Intel Core i7-2600K (Sandy Bridge) 3.4 ГГц, разогнанный до 4 ГГц (40х100 МГц), LGA 1155, 8 Мбайт кэш L3, Hyper-Threading enabled, Power-savings enabled |

| Материнская плата | ASUS Maximus IV Extreme (LGA 1155) Intel P67, BIOS 0504 |

| Оперативная память | 8 Гбайт (4 x 2 Гбайт) Kingston DDR3-1333, KHX2000C8D3T1K3/6GX @ 8-8-8-24, 1.65 В |

| Жёсткий диск | 160 Гбайт SATA 3 Гбит/с, Intel SSDSA2M160G2GC |

| Видеокарта | GeForce GTX 560 Ti 1 Гбайт GeForce GTX 570 1.25 Гбайт GeForce GTX 460 1 Гбайт GeForce GTX 470 1.25 Гбайт Radeon HD 6950 2 Гбайт Radeon HD 6870 1 Гбайт Radeon HD 5870 1 Гбайт Radeon HD 4870 X2 2 Гбайт |

| Блок питания | Cooler Master UCP-1000 W |

| Программное обеспечение и драйверы | |

| Операционная система | Windows 7 Ultimate 64-бит |

| DirectX | DirectX 11 |

| Драйвер видеокарты | AMD 8.82.2 GeForce Release 266.56 (для GTX 560 Ti) GeForce Release 263.09 (для GTX 570) GeForce Release 260.99 (для GTX 460 и 470) |

| Игры | |

| Lost Planet 2 | Highest Quality Settings, No AA / No AF, 4x MSAA / 16x AF, vsync off, 1680x1050 / 1900x1080 / 2560x1600, DirectX 11, Steam version |

| Just Cause 2 | Highest Quality Settings, No AA / 2x AF, 8x AA / 16x AF, vsync off, 1680x1050 / 1920x1080 / 2560x1600, Bokeh filter and GPU water disabled (для видеокарт nVidia), Concrete Jungle Benchmark |

| Metro 2033 | High Quality Settings, AAA / 4x AF, 4x MSAA / 16x AF, 1680x1050 / 1920x1080 / 2560x1600, Built-in Benchmark, Steam version |

| F1 2010 | Ultra High Settings, No AA / No AF, 8x AA / No AF, 1680x1050 / 1920x1080 / 2560x1600, Steam version, Custom benchmark script, DX11 Rendering |

| Aliens Vs. Predator | Benchmark High Quality Settings, SSAO, No AA / 16xAF, Ultra Quality Settings, 4x MSAA / No AF, vsync off, 1680x1050 / 1920x1080 / 2560x1600 |

| Battlefield: Bad Company 2 | Custom (Highest) Quality Settings, No AA / No AF, 8x MSAA / 16xAF, 1680x1050 / 1920x1080 / 2560x1600, opening cinematic, 145 second sequence, FRAPS |

| 3DMark11 | Performance Default |

| HAWX 2 | Highest Quality Settings, 8x AA, 1920x1200, Retail Version, Built-in Benchmark, Tessellation on/off |

| World of Warcraft: Cataclysm | Ultra Quality Settings, No AA / 16x AF, 8x AA / 16x AF, From Crushblow to The Krazzworks, 1680x1050 / 1920x1080 / 2560x1600, FRAPS, DirectX 9 Rendering |

GeForce GTX 560 Ti | Результаты тестирования

Не так давно мы обсуждали тест 3DMark11 с nVidia по телефону. Кажется, компании не нравится этот тест, потому что он не отражает будущее развитие игр, а именно, более широкое использование геометрии для улучшения реализма.

Несомненно, в 3DMark11 акцент делается на освещение, в частности на одном из шейдеров DirectX 10. Однако у нас состоялся откровенный разговор с Futuremark, которые сказали, что они спроектировали свой тест с правильной оптимизаций тесселяции. Излишняя геометрия сцены сильно сказывается на качестве визуального отображения, но потенциально может значительно снизить производительность видеокарт начального уровня и средних видеокарт. В то время, как первый графический тест в 3DMark вообще не затрагивает геометрию, то второй, третий и четвертый тесты включают то, что мы считаем разумным количеством тесселяции – то есть, нет ни одной сцены с настолько большими треугольниками, где мы могли бы подумать: "О! Здесь можно было бы добавить немого геометрии".

Конечно, nVidia утверждает, что подобный синтетический тест, ориентируется на будущие игры, а не на те, которые вышли сегодня. Однако, Futuremark утверждает, что разработчики игр не будут увеличивать сложность сцен ради их сложности.

|

Согласно Futuremark, 3DMark11 содержит достаточно геометрии для увеличения реализма

В конце концов, более важно, насколько 3DMark11 правильно отражает большинство реальных игр. Когда вы просмотрите на результаты тестов, основанных на играх с DirectX 11 (все, что мы тестировали сегодня, за исключением World of Warcraft, основано на DirectX11), то заметите, что на самом деле 3DMark11, по какой-то причине, не всегда хорошо справляется. Наиболее заметна разница между GeForce GTX 560 Ti и Radeon HD 6870. В этом тесте видеокарта от AMD обгоняет nVidia, но во всех случае с реальными играми (за исключением F1 2010 – об этом чуть позже) nVidia вырывается вперед. GTX 470 также даёт непропорционально низкий результат, по сравнению с Radeon HD 6870. Интересно заметить, что даже в собственной линейке AMD Radeon HD 5870 побеждает Radeon HD 6950 во многих тестах, хотя 3DMark11 наоборот показывает существенный отрыв.

Возможно, 3DMark11 больше представляет будущее, чем думает nVidia, если двойной тесселяционный движок помог HD 6950 так далеко уйти вперёд от HD 5870. Или, может быть, уверенность AMD в шейдерах освещения DirectX 10 только подчеркивает высокую производительность DX10, в то время как nVidia, возможно, предлагает более дальновидную архитектуру, ориентированную на будущее. В любом случае не основывайте своё решение о покупке только на результатах синтетического теста. Люди в Futurmark приложили много усилий, чтобы исключить влияние политики, которую проводят AMD/nVidia, участвуя в разработках игр, но это приводит, в свою очередь, к разным результатам в синтетических тестах и в реальных играх.

Metro 2033 (DX11)

В разрешениях 1680x1050 и 1920x1080 выделяются GeForce GTX 570 и Radeon HD 6950 2 Гбайт, особенно с включенным сглаживанием. На менее производительных видеокартах вряд ли необходимо включать сглаживание, так как Metro 2033 одна из наиболее требовательных игр, которые мы использовали в нашем тестировании.

Как это не удивительно, Radeon HD 5870 уверенно занимает третье место во всех трёх тестах, доказав, что предыдущее поколение карт AMD по-прежнему конкурентоспособно, более чем через год после выхода.

GeForce GTX 560 Ti от nVidia находится в середине, побив Radeon HD 6870 без сглаживания, потеряв немного в двух разрешениях со сглаживанием, а затем обходит видеокарту AMD при разрешении 2560x1600 (хотя и не на играбельной частоте кадров). Наверное, ещё более примечательным является тот факт, что 560 Ti обошёл карту GeForce GTX 470, которая основана на более сложном GPU, рассеивает больше тепла и потребляет больше энергии.

LostPlanet 2 (DX11)

На самом деле не удивительно, что карты GeForce доминируют в Lost Planet 2, ведь она с логотипом TWIMTBP (The WayIt’s Meant To Be Played). Удивительно то, что Radeon HD 6950 занял второе место при разрешении 2560x1600.

GeForce GTX 560 Ti ставят сегодня в один ряд с GeForce GTX 470, показывая нам, что ядра CUDA, сами по себе, не приводят к увеличению производительности - текстурная пропускная способность также важна, и архитектура GF114 лучше подходит для массовых игр, чем некоторые более мощные графические процессоры от NVidia.

Интересно, что AMD Radeon HD 5870 плетётся на последнем месте, однако при разрешении 2560x1600 он поднялся на один пункт.

Aliens Vs. Predator (DX11)

Radeon HD 5870 возвращает себе лидерство среди видеокарт AMD среднего уровня, побил даже Radeon HD 6950 2 Гбайт во всех трёх разрешениях.

Тем временем, nVidia GeForce GTX 560 Ti попадает в середину, обогнав Radeon HD 6870 и GeForce GTX 470. На самом деле довольно трудно получить хорошую частоту кадров с включенным 4xAA, поэтому мы рекомендуем обратить больше внимания на тесты с выключенным сглаживанием.

Battlefield: Bad Company 2 (DX11)

Многие игры, первыми начавшие поддерживать DirectX 11 были помечены как "проверенные DX11 игры". Они, конечно, поддерживали некоторые функции DirectX 11, но этого недостаточно, чтобы показать все способности API. Battlefield: Bad Company 2 была одной из первых игр DX11-класса и она тоже получила отметку "проверенной" игры, также как AvP и DIRT2.

GeForce GTX 560 Ti от NVidia довольно хорошо показала себя в разрешении 1680x1050, немного опередив GTX 470 и даже более дорогой Radeon HD 6950 на 2 Гбайт. Далее, в разрешении 1920x1080 GTX 560 Ti проиграла HD 6950, а при 2560x1600 оказалась даже ниже, чем Radeon HD 6870. В этом разрешении мы наблюдаем три видеокарты, такие как HD 6870, GTX 560 и GTX 470, у которых практически одинаковое количество кадров в секунду.

Настоящая новость состоит в том, что Radeon HD 5870 от AMD обогнал почти все карты (кроме GeForce GTX 570) на всех трёх разрешениях.

GeForce GTX 560 Ti | Результаты тестирования. Продолжение

F1 2010 (DX11)

Мы слышали, что F1 2010 тоже отмечен как "проверенная" игра DX11-класса, но фактически она уступает DiRT 2 из-за удаления поддержки тесселяции и ограничивая поддержку API только шейдерной маской и эффектом размытия. Тем не менее, игра выглядит довольно хорошо.

На разрешениях 1680x1050 и 1920x1080 GeForce GTX 570 занимает первое место, однако Radeon HD серии 5000 и 6000 идут следом. На разрешении 2560x1600 Radeon HD 5870 от AMD даже занял первое место.

Между тем, GeForce GTX 560 Ti немного отстаёт. Он смог поравняться с GeForce GTX 470, которую должен заменить, но всё же проигрывает более дешёвым картам от AMD.

Just Cause 2

Хотя Just Cause 2 тоже имеет логотип TWIMTBP, Radeon HD 5870 наглядно показывает нам, что видеокартам от nVidia этот логотип не сильно помогает, но похоже это не относится к картам серии HD 6000.

Radeon HD 6950 2 Гбайт смог обойти GeForce GTX 560 Ti только при разрешении 2560x1600. Если бы Radeon HD 5870 не показал лучшие цифры за меньшие деньги, можно было бы подозревать, что это из-за спонсорского логотипа nVidia.

World Of Warcraft: Cataclysm

С недавнего времени, мы стали получать множество просьб о включении World of Warcraft в наши постоянные обзоры видеокарт, что мы и сделали. Кроме того мы хотели провести дополнительные тесты по масштабированию производительности конфигураций с несколькими видеокартами, так как в игре изначально отсутствовала поддержка таких конфигураций. Более подробно об этом расскажем ниже.

Поскольку уровень производительности одиночных видеокарт продолжает расти, результаты здесь довольно близки к тем, что мы видели перед этой частью. Разница в том, что мы запускаем игру в том виде, как она поставляется - с режимом DirectX 9 (а не с экспериментальным кодом для запуска DX11, который улучшает производительность). Как и раньше, видеокарты от nVidia показали себя очень хорошо, GeForce GTX 570 и 560 Ti заняли два первых места во всех разрешениях.

Radeon HD 6950 борется с GeForce GTX 470 за третье место. Остальные видеокарты расположились ниже. Стоит отметить, что Radeon HD 5870 занимает четвертое место при разрешении 2560x1600 и идёт сразу после Radeon HD 6950. Опять же, архитектура Cypress демонстрирует своё превосходство.

Мы забежали немного вперед и добавили результаты Radeon HD 4870 X2 для тех, кто использует старые видеокарты класса DirectX 10. Как видно, старый флагман всё ещё способен потягаться с современными моделями, даже на высоких настройках при разрешении 2560x1600. Однако, у HD4870 X2 есть небольшая проблема с высоким качеством при использовании последней бета-версией драйвера от AMD.

|

это должна была быть вода…

Масштабирование в SLI и CrossFire

В Lost Planet 2 GeForce GTX 560 Ti в одиночном режиме доминирует над Radeon HD 5870 и 6870, поэтому тот факт, что пара этих карт делает то же самое в SLI, на самом деле не удивляет.

Возможно, более интересным будет то, что Radeon HD 5870 и 6870 показали почти одинаковую производительность. Мы видели, как Radeon HD 6870 выдавал больше кадров на разрешении 1680x1050 и 1920x1080, пропустив HD 5870 вперед только при 2560x1600. Однако в CrossFire, два HD 6870 показали небольшой отрыв в разрешении 2560x1600, тем самым демонстрируя лучшее масштабирование карт на основе Barts.

С Aliens Vs. Predator абсолютно другая история. В режиме одиночной карты Radeon HD 5870 занял второе место в разрешении 2560x1600, и он использует это преимущество, чтобы занять первое место в тесте двух видеокарт. GeForce GTX 560 Ti и Radeon HD 6870 прежде показывавшие почти одинаковые результаты и сейчас оказались очень близки в SLI и CrossFire.

В F1, в сдвоенном режиме, GeForce GTX 560 Ti, как и в одиночном, показал себя плохо, и две видеокарты от AMD опять вырвались вперед. Более дешёвый Radeon HD 6870 даже показал более высокую частоту кадров с включенным 8x MSAA, чем GTX 560 Ti с выключенным.

Лучшее масштабирование Radeon HD 6870 позволяет ему выигрывать у двух GeForce GTX 560 Ti в режиме SLI, несмотря на то, что видеокарта от nVidia была быстрее при 2560x1600 в режиме одиночной карты. Более примечательно то, что Radeon HD 5870 в CrossFire превосходит другие пары видеокарт и финиширует на первом месте.

Мы буквально бились головой о стену в течение нескольких дней, пытаясь выяснить проблему запуска World of Warcraft: Cataclysm от Blizzard на SLI/CrossFire. По словам AMD, она выпустила обновление профиля CrossFire вскоре после того, как мы закончили тестирование. У nVidia всё ещё есть отчеты об ошибках, указывающих, что масштабирование не такое целостное, каким оно должно быть. Однако, после ряда мелких исправлений и обновлений драйверов устройств, мы рады сообщить, что теперь можно увидеть масштабирование в том же Crushblow при пролёте The Krazzworks. nVidia утверждает, что не видит идеального масштабирования, но производительности двух GeForce GTX 560 Тi (с 8-кратным сглаживанием) достаточно, чтобы соответствовать двум Radeon HD 5870 (без сглаживания). Radeon HD 6870 отстаёт так же, как и в результатах тестов одиночных видеокарт.

GeForce GTX 560 Ti | Разгон

|

Gigabyte прислал нам свою видеокарту GV-N560SO-1GI, специально разогнанную до 1 ГГц (по сравнению со штатной частотой 822 МГц) для графического процессора и до 1145 МГц (по сравнению с частотой 1 ГГц) для видеопамяти. Представители Gigabyte говорят, что эта карта будет продаваться по цене $269 – это на $20 больше, по сравнению с ранее заявленной ценой в $249.

Как вы можете видеть, GeForce GTX 560 Ti, работающая на частоте 1 ГГц существенно быстрее, чем референсные видеокарты от nVidia, присланные ранее. Это не так быстро, как GeForce GTX 570, как обещает Gigabyte, но факт в том, что результаты довольно похожи, а цена на $80 меньше. Теперь, Gigabyte использует свой собственный процесс отбора GF114, способных устойчиво работать на частоте 1 ГГц. Не каждый графический процессор способен работать на таком уровне. Однако справедливо предположить, что большинство GeForce GTX 560 будут уверенно работать со среднюю скорость. nVidia подтверждает, что частотf около 900 МГц довольно типична для видеочипов, протестированных ранее.

GeForce GTX 560 Ti | Шум и энергопотребление

Мощность

Изменив недавно способ измерения мощности, мы хотели убедиться, что получаем правильные результаты. Запустив несколько игр на DirectX 9, 10 и 11, мы не смогли получить уровень энергопотребления выше, чем в игре Metro 2033 (хотя, по-видимому, старые игры могут выдать и более высокое энергопотребление). Однако мы заметили, что низкие разрешения более требовательны к питанию, чем высокие. Это имеет некоторый смысл - если вы не создаете искусственно высокие нагрузки на GPU, центральный процессор вынужден работать более интенсивно. Поэтому наш тест энергопотребления проходит при разрешении 1680x1050 с использованием AAA и 4x AF.

Очевидно, что Radeon HD 4870 X2 был в своё время настоящим "зверем". Видеокарты с двумя GPU и сейчас могут предоставить приличную производительность в современных играх, но они буквально высасывают энергию во время работы. Абсолютная скорость может быть и не такой высокой, но соотношение производительности на ватт оставляет желать лучшего.

Следующим по потреблению энергии идёт GeForce GTX 570, а сразу же за ним GeForce GTX 470. Отличие заключается в том, что GTX 570 намного более производительная, а разница в 4 Вт всё-таки небольшая по сравнению со скоростью, которую вы получите.

| Видеокарта | Средняя мощность системы, Вт |

| GeForce GTX 560 Ti | 263.3 |

| GeForce GTX 570 | 292.6 |

| GeForce GTX 460 | 241.0 |

| GeForce GTX 470 | 288.9 |

| Radeon HD 6950 | 253.1 |

| Radeon HD 6870 | 234.1 |

| Radeon HD 5870 | 249.6 |

| Radeon HD 4870 X2 | 402.0 |

GeForce GTX 560 Ti потребляет меньше этих двух видеокарт, в среднем на 25 Вт, но всё же больше, чем Radeon HD 6950 2 Гбайт от AMD, который, быстрее при высоких разрешениях. Общая разница в 10 Вт по энергопотреблению всей системы делает соотношение производительность на ватт в пользу AMD.

Radeon HD 5870, GeForce GTX 460 и Radeon HD 6870 оказались близко друг к другу и замыкают список. Однако, как вы могли видеть из анализа тестирования, Radeon HD 5870, безусловно, фаворит по производительность, и это более чем через год после появления.

Шум

Мы не смогли включить Radeon HD 4870 X2 в наши тесты DirectX 11, потому что, он поддерживает только DirectX 10. Но мы смогли протестировать его на шум, энергопотребление и производительность в World Of Warcraft. Эта карта служит хорошей отправной точкой в нашем акустическом тесте. Под нагрузкой, карта довольно сильно шумит.

Однако, на холостом ходу Radeon HD 4870 X2 шумит не больше других видеокарт, рассмотренных здесь. Наиболее шумные карты, как правило, являются флагманами, а не картами среднего класса и цены. Надо сказать, что nVidia действительно решает проблему шума видеокарт на базе GF100. GeForce GTX 560 Ti является самой тихой картой из всех протестированных. После 10-го запуска Metro 2033 она производит столько шума, сколько производит GeForce GTX 460 на холостом ходу.

GeForce GTX 560 Ti | Заключение

Мы не были впечатлены высочайшей графикой до запуска Radeon HD 6990 от AMD на базе Antilles. Radeon HD 5970 стоит около $ 600 и более. Но эта видеокарта, выпущена более года назад. GeForce GTX 580 стоит $500. Если вы покупаете несколько флагманских карт для того, чтобы соединить их в SLI или Crossfire, это обойдётся вам в непомерную сумму около $1000 и более. Сейчас появились варианты в среднем классе.

GeForce GTX 460, Radeon HD 6870, GeForce GTX 570, Radeon HD 6950 – любые из этих видеокарт в SLI или Crossfire смогут вас порадовать.

Теперь появляется GeForce GTX 560 Ti, занимающий место как раз в центре этой четверки видеокарт. С точки зрения производительности, эта видеокарта практически в точности заменяет GeForce GTX 470. С точки зрения цены, она сохранит вам $10. С точки зрения шума, 560 Ti определённо является победителем, хотя и GTX 470 тоже несильно шумит, как например GeForce GTX 480. GTX 560 Ti также выигрывает по энергопотреблению, требуя в среднем на 25 Вт меньше, чем GTX 470.

Все эти вещи, взятые по отдельности, являются дополнительными усовершенствованиями, которые nVidia всё равно должна была сделать. Благодаря мощному и горячему графическому процессору GF100, GeForce GTX 470 стоит в продуктовой линейке компании наряду с более изящными картами, такими как GTX 570 и 460. Таким образом, GeForce GTX 560 Ti не впечатляет даже при всех этих маленьких дополнениях, собранных вместе. Но в этой видеокарте нет ничего плохого, это просто улучшенная версия GTX 470, но на $10 дешевле.

Мы без энтузиазма смотрим на видеокарты партнёров nVidia, построенных на GF114. Видеокарта GV-N560SO-1GI от Gigabyte не побила GeForce GTX 570 ни в одном из наших тестов, но она была очень близко в некоторых из них. Gigabyte утверждает, что видеокарта будет продаваться по цене $269. Это довольно низкая цена для карты с тактовой частотой работы графического процессора в 1 ГГц. Однако сможет ли компания поддерживать эту цену, когда GeForce GTX 570 продаётся за $349?

А как же конкуренты? Хотя GeForce GTX 560 Ti почти во всём быстрее, чем Radeon HD 6870 и всего на $20-$40 дороже было бы несправедливо не отметить, что некоторые HD 6870 продаются за менее чем $200 с учётом скидок. Даже сейчас на конфигурацию Crossfire можно потратить на $100 меньше, чем на SLI с GeForce 560 Ti. Radeon HD 5870 также выглядит довольно хорошо, но только если вы сможете найти его дешевле, чем GeForce.

Несомненно, сейчас лучшее время для обновления устаревшей на одно-два поколения видеокарты. Если вы уже приобрели приличную карту в прошлом году, то GeForce 560 Ti вряд ли даёт повод потратить лишние $250. 560 Ti немного быстрее, немного эффективнее, немного тише и немного дешевле, чем GeForce GTX 470, с которой можно попрощаться.

Постскриптум: AMD появляется с двадцатью Radeon HD 6950 1 Гбайт

Мы любим хорошую конкуренцию, но плохой маркетинг может всё испортить.

AMD обратилась к нам с заявлением, что будет поставлять версию Radeon HD 6950 на 1 Гбайт в середине февраля по цене между $269 и $279. "Ну и хорошо", подумали мы тогда. "Беспокоиться будет тогда, когда она выйдет... через три недели. До тех пор, это всего лишь пустые слова на бумаге".

Через некоторое время видеокарты появились и, конечно, мы пропустили их через наш полный набор тестов.

Почти в каждом случае, меньший буфер кадров (и более жёсткая синхронизация памяти) выдаёт на один или два кадра в секунду больше, чем в модели на 2 Гбайт. Это недостойно отдельной диаграммы. В игре Metro 2033 с включенным 4х MSAA и 16x AF, видеокарте на 1 Гбайт не хватило объёма буфера, чтобы поддерживать производительность и FPS упал до 10 кадров в секунду против 30 на 2 Гбайт версии.

Если честно, то возможно AMD должны была представить Radeon HD 6950 первой, а не видеокарту на 2 Гбайт за $300. Однако они не делают этого, возможно, чтобы избежать конкуренции с Radeon HD 6870 по цене $240-$260. Очевидно, что AMD выпустил их вместе до старта продаж видеокарты от nVidia, а опцию как бы придержали в резерве, пока не увидели, что GTX 560 Ti может. Потеря продаж HD 6870 в пользу более дешёвого Radeon HD 6950 звучит лучше для AMD, чем потеря продаж в пользу nVidia.

Теперь, перед лицом GeForce GTX 560 Ti, AMD говорит, что Radeon HD 6950 на 1 Гбайт будет оценен в $259, а Radeon HD 6870 понизится до $219. Останутся ли эти цены или нет, ещё предстоит выяснить. В любом случае, наше заключение относительно GTX 560 Ti не меняется. Он по-прежнему не даёт нам повод к апгрейду. Если сравнивать видеокарты по производительности, то решения от AMD выглядят лучше.

Грязные сплетни создают…

История бы закончилась, если бы Radeon HD 6950 1 Гбайт не появился. Накануне запуска nVidia, один из партнёров говорил нам о том, что AMD выставила на продажу HD 6950 1Гбайт на складе в Newegg за $259. На момент написания статьи в доступности было 20 видеокарт. Мы разговаривали с Newegg и они подтвердили это. Когда вы это прочтёте, их уже не будет в продаже.

Очевидно, что 20 человек будут очень рады получить видеокарту, которая быстрее, чем GeForce GTX 560 Ti за точно такую же цену. Всем остальным придётся подождать. В любом случае, это один из самых слабых маркетинговых ходов, который мы видели. Видеокарта от AMD достаточно сильна, чтобы выстоять самостоятельно, даже при изначально-прогнозируемой цене $269 - $279.

Маловероятно, что вы купите HD 6950 1 Гбайт, если играете на трёх мониторной конфигурации Eyefinity в CrossFire. Для этого вам понадобится видеокарта с памятью в 2 Гбайт, чтобы поддерживать разрешение 5760x1080 с активным AA и AF. Однако Radeon HD 6950 1 Гбайт более привлекателен на разрешении 1920x1080 с максимальной детализацией или на 2560x1600, но с чуть меньшей детализацией.

В сущности, благодаря памяти, Radeon HD 6950 создает достойную конкуренцию GeForce GTX 560 Ti от nVidia.

ВведениеКак известно всем, кто хоть в какой-то мере интересуется новинками рынка дискретной компьютерной графики, "роды" GeForce GTX 480 были трудными, и первенец новой архитектуры NVIDIA Fermi появился на свет не в полной конфигурации. Лишь ближе к концу 2010 года компания завершила работу над ошибками, явив на суд публики улучшенную версию ядра GF100 - GF110. Доработанный и усовершенствованный наследник, наконец, смог стать тем, чем должен был стать GF100 с самого начала, и решения на его основе, GeForce GTX 580 и GeForce GTX 570, завоевали наши симпатии, великолепно проявив себя в игровых тестах.

Но с самого начала было понятно, что этим NVIDIA не ограничится, и процесс замены семейства GeForce 400 семейством GeForce 500 будет продолжаться и дальше. Следующим кандидатом в этой цепочке закономерно стал GeForce GTX 460. Надо сказать, что решения на базе GF104 изначально вышли более удачными, нежели старшие модели GeForce 400, использовавшие GF100. Во-первых, сам чип был более простым и более дешёвым в производстве, а, во-вторых, он умел выполнять фильтрацию текстур FP16 на полной скорости.

Всё это позволило ему на долгое время стать "основным боевым танком" NVIDIA, способным успешно сражаться с врагом и побеждать его. В ценовой категории "199-229" долларов GeForce GTX 460 768MB и GeForce GTX 460 1GB долгое время не имели себе равных, а присутствие на рынке большого количества моделей с серьёзным заводским разгоном свидетельствовало о высоком потенциале GF104. Однако, и у этого ядра был свой "тёмный секрет" - из восьми имеющихся в его составе мультипроцессоров активно было только семь, что давало 336 ALU и 56 текстурных блоков, в то время, как физических их было 384 и 64, соответственно.

Вряд ли GF104 страдал теми же "детскими болезнями", что и GF100, просто NVIDIA, по всей видимости, пыталась выпустить на рынок новое массовое графическое ядро как можно быстрее, обеспечив при этом максимальный выход годных кристаллов. Многие обозревательские ресурсы предполагали, что вслед за усечённой версией GF104 может увидеть свет полная, однако, при жизни семейства GeForce 400 этого так и не произошло.

Это случилось только сегодня, 25 января, когда NVIDIA представила миру наследника GF104 - ядро GF114, а также новую графическую карту класса "performance-mainstream" на его основе. В терминологии NVIDIA класс доступных, но высокопроизводительных игровых видеокарт называется "Hunter", но мы предпочитаем сравнение с современными боевыми танками. В этой перспективе флагманские модели стоимостью более 250 долларов представляются мощными, тяжёлыми и отлично вооружёнными моделями танков, которые, однако, в силу своей относительной малочисленности не могут создать перевеса по всему фронту. Эта тяжёлая и неблагодарная работа ложится на плечи более массовых боевых машин, сочетающих в себе простоту с приемлемыми тактико-техническими характеристиками.

Новой боевой машиной NVIDIA такого класса и стал GeForce GTX 560 Ti, анонсированный сегодня. Признаться, возврат к использованию приставок в названиях графических нас удивил. "Ti", очевидно, означает "Titanium", что должно намекать на великолепные потребительские качества новинки, однако, использование всевозможных приставок и суффиксов разрушает стройную систему наименований и возвращает нас в далёкий 2001 год, когда вышеупомянутая приставка была впервые использована в названии одной из моделей GeForce 2. На наш взгляд, можно было бы ограничиться названием GeForce GTX 560 и не создавать потенциальной путаницы в умах покупателей.

Так или иначе, новый GeForce GTX 560 Ti здесь, и мы собираемся познакомиться с ним поближе, дабы выяснить, на что способен новый массовый "танк" NVIDIA на поле боя.

NVIDIA GeForce GTX 560 Ti: архитектура

Как и в случае с GeForce GTX 580/570, организация нового ядра не изменилась. По сути, GF114 представляет собой полностью активный GF104, оптимизированный для достижения более высоких тактовых частот при сохранении уровня энергопотребления в разумных пределах.

Два кластера GPC включают в себя по четыре мультипроцессора, каждый из которых, в свою очередь, несёт в своём составе по 48 универсальных поточных ядер, и, соответственно, общее количество этих ядер равно 384. Каждый мультипроцессор обслуживается восемью блоками текстурных операций, так что общее количество активных TMU в новом чипе составляет 64. Архитектура текстурных процессоров не изменилась со времён GF104. Они способны выполнять полноскоростную фильтрацию текстур формата FP16, наряду с традиционным форматом INT8. А вот фильтрация текстур в формате FP32 осуществляется в четыре раза медленнее. Объём кэша второго уровня, как и в GF104, составляет 512 КБ.

Кроме того, каждый мультипроцессор включает в себя и блок PolyMorph Engine, что ставит GF114 на голову выше любого решения AMD в области обработки геометрических данных и тесселяции. Даже два блока тесселяции третьего поколения в составе Cayman вряд ли смогут поспорить на равных с восемью блоками GF114. Конфигурация растровой подсистемы GF114 осталась прежней и включает в себя 32 блока RBE. Поскольку эта подсистема напрямую связана с подсистемой памяти, последняя по-прежнему состоит из четырёх 64-битных контроллеров, так что общая ширина шины, связывающей GPU с банком локальной памяти составляет 256 бит.

Что касается мультимедийных возможностей, то здесь заметных нововведений не замечено, но они, в сущности, и не нужны: уже GF104 умел всё, необходимое по современным меркам, включая полное аппаратное декодирование и масштабирование видео высокого разрешения в форматах H.264 и VC-1, а также защищённый вывод многоканального звука в форматах Dolby TrueHD и DTS-HD Master Audio посредством Protected Audio Path. Единственное весомое преимущество, которым в этой сфере может похвастаться AMD, это поддержка аппаратного декодирования DivX.