Przekazanie dobrej pracy do bazy wiedzy jest łatwe. Skorzystaj z poniższego formularza

Będą wam bardzo wdzięczni studenci, doktoranci, młodzi naukowcy, którzy wykorzystują bazę wiedzy w swoich badaniach i pracy.

Podobne dokumenty

Opis funkcjonalności technologii Data Mining jako nieznanego procesu wykrywania danych. Badanie systemów wnioskowania dla reguł asocjacyjnych i mechanizmów algorytmów sieci neuronowej. Opis algorytmów klastrowania i zastosowań Data Mining.

test, dodano 14.06.2013

Podstawa do grupowania. Wykorzystanie Data Mining jako sposobu „odkrywania wiedzy w bazach danych”. Wybór algorytmów klastrowych. Pobieranie danych z bazy danych repozytorium zdalnego warsztatu. Grupowanie studentów i zadań.

praca semestralna, dodano 07/10/2017

Ulepszenie technologii rejestrowania i przechowywania danych. Specyfika współczesnych wymagań przetwarzania danych informacyjnych. Koncepcja szablonów odzwierciedlających fragmenty relacji wieloaspektowych w danych stanowiąca rdzeń nowoczesnej technologii Data Mining.

praca testowa, dodano 09.02.2010

Eksploracja danych, historia rozwoju eksploracji danych i odkrywanie wiedzy. Elementy technologiczne i metody eksploracji danych. Kroki w odkrywaniu wiedzy. Wykrywanie zmian i odchyleń. Powiązane dyscypliny, wyszukiwanie informacji i ekstrakcja tekstu.

raport dodano 16.06.2012

Data Mining jako proces wspomagania decyzji na podstawie wyszukiwania ukrytych wzorców (wzorców informacyjnych) w danych. Jego prawa i etapy wdrażania, historia rozwoju tej technologii, ocena zalet i wad, możliwości.

esej dodany 17.12.2014

Klasyfikacja zadań DataMining. Twórz raporty i podsumowania. Funkcje Data Miner w Statistica. Zadanie klasyfikacji, grupowania i regresji. Narzędzia analizy Statistica Data Miner. Istotą problemu jest poszukiwanie reguł asocjacyjnych. Analiza predyktorów przeżycia.

praca semestralna, dodano 19.05.2011

Obiecujące obszary analizy danych: analiza informacji tekstowych, eksploracja danych. Analiza uporządkowanych informacji przechowywanych w bazach danych. Proces analizy dokumentów tekstowych. Funkcje przetwarzania danych.

streszczenie, dodano 02/13/2014

Klasyfikacja zadań eksploracji danych. Zadanie grupowania i wyszukiwania reguł asocjacyjnych. Definicja klasy obiektu zgodnie z jego właściwościami i charakterystyką. Znajdowanie częstych zależności między obiektami lub zdarzeniami. Operacyjne i analityczne przetwarzanie danych.

praca testowa, dodano 1/13/2013

Ministerstwo Edukacji i Nauki Federacji Rosyjskiej

Federalna państwowa edukacyjna instytucja szkolnictwa wyższego

„KRAJOWE BADANIA UNIWERSYTET POLITYCZNY TOMSKA”

Instytut Cybernetyki

Kierunek Informatyka i inżynieria komputerowa

Zakład VT

Praca testowa

dyscyplina informatyki i inżynierii komputerowej

Temat: Metody eksploracji danych

Wprowadzenie

Eksploracja danych. Podstawowe pojęcia i definicje

1 etapy eksploracji danych

2 elementy systemu wydobywczego

3 techniki eksploracji danych w eksploracji danych

Metody eksploracji danych

1 Zawarcie reguł asocjacyjnych

2 algorytmy sieci neuronowej

3 Metody najbliższego sąsiada i najbliższych sąsiadów

4 Drzewa decyzyjne

5 Algorytmy grupowania

6 algorytmów genetycznych

Obszary zastosowania

Producenci eksploracji danych

Krytyka metod

Wniosek

Referencje

Wprowadzenie

Rezultatem rozwoju technologii informatycznych jest ogromna ilość danych gromadzonych w formie elektronicznej, szybko rosnąca. Ponadto dane z reguły mają heterogeniczną strukturę (teksty, obrazy, audio, wideo, dokumenty hipertekstowe, relacyjne bazy danych). Dane gromadzone przez długi czas mogą zawierać wzorce, trendy i relacje, które są cennymi informacjami w planowaniu, prognozowaniu, podejmowaniu decyzji i monitorowaniu procesów. Jednak osoba fizycznie nie jest w stanie skutecznie analizować takich ilości heterogenicznych danych. Metody tradycyjnej statystyki matematycznej od dawna twierdzą, że są głównym narzędziem do analizy danych. Nie pozwalają one jednak na syntezę nowych hipotez, ale mogą być wykorzystane jedynie do potwierdzenia wstępnie sformułowanych hipotez i „surowej” analizy eksploracyjnej, która stanowi podstawę internetowego przetwarzania analitycznego (OLAP). Często to właśnie sformułowanie hipotezy okazuje się najtrudniejszym zadaniem podczas analizy do późniejszego podjęcia decyzji, ponieważ nie wszystkie wzorce w danych są oczywiste na pierwszy rzut oka. Dlatego technologie eksploracji danych są uważane za jeden z najważniejszych i najbardziej obiecujących tematów badań i zastosowań w branży technologii informatycznych. W tym przypadku eksploracja danych jest rozumiana jako proces określania nowej, poprawnej i potencjalnie użytecznej wiedzy w oparciu o duże tablice danych. Tak więc w przeglądzie technologii MIT opisano Data Mining jako jedną z dziesięciu nowych technologii, które zmienią świat.

1. Eksploracja danych. Podstawowe pojęcia i definicje

Eksploracja danych to proces wykrywania wcześniej nieznanych, nietrywialnych, praktycznie przydatnych i dostępnych interpretacji wiedzy w „surowych” danych, które są niezbędne do podejmowania decyzji w różnych sferach działalności człowieka.

Istotę i cel technologii Data Mining można sformułować w następujący sposób: jest to technologia zaprojektowana do wyszukiwania dużych ilości danych o nieoczywistych, obiektywnych i użytecznych wzorcach w praktyce.

Nieoczywiste wzorce to wzorce, których nie można wykryć standardowymi metodami przetwarzania informacji ani specjalistycznymi metodami.

Pod obiektywnymi prawami należy rozumieć prawa, które są w pełni zgodne z rzeczywistością, w przeciwieństwie do ekspertyzy, która jest zawsze subiektywna.

Ta koncepcja analizy danych zakłada, że:

§ dane mogą być niedokładne, niekompletne (zawierać luki), sprzeczne, niejednorodne, pośrednie, a jednocześnie mieć gigantyczne ilości; dlatego zrozumienie danych w konkretnych aplikacjach wymaga znacznego wysiłku intelektualnego;

§ same algorytmy analizy danych mogą mieć „elementy inteligencji”, w szczególności zdolność uczenia się na podstawie precedensów, to znaczy wyciągania ogólnych wniosków na podstawie prywatnych obserwacji; opracowanie takich algorytmów wymaga również znacznego wysiłku intelektualnego;

§ procesy przetwarzania surowych danych w informacje, a informacji w wiedzę nie można wykonywać ręcznie i wymagają one automatyzacji.

Technologia Data Mining opiera się na koncepcji wzorców (wzorców), które odzwierciedlają fragmenty relacji wieloaspektowych w danych. Wzorce te są wzorcami nieodłącznymi w podpróbkach danych, które mogą być zwięźle wyrażone w postaci czytelnej dla człowieka.

Wzory są wyszukiwane za pomocą metod, które nie są ograniczone z góry założeniami dotyczącymi struktury próby i rodzaju rozkładu wartości analizowanych wskaźników.

Ważną cechą Data Mining jest niestandardowa i nieoczywistość pożądanych wzorców. Innymi słowy, narzędzia Data Mining różnią się od narzędzi do statystycznego przetwarzania danych i narzędzi OLAP tym, że zamiast sprawdzać współzależności uprzednio zakładane przez użytkowników, mogą, w oparciu o dostępne dane, samodzielnie znaleźć takie współzależności i postawić hipotezę o ich naturze. Istnieje pięć standardowych typów wzorców identyfikowanych metodami Data Mining:

· Skojarzenie - wysokie prawdopodobieństwo wzajemnych zdarzeń komunikacyjnych. Przykładem stowarzyszenia są towary w sklepie, często kupowane razem;

· Sekwencja - wysokie prawdopodobieństwo łańcucha zdarzeń związanych z czasem. Przykładem sekwencji jest sytuacja, w której w pewnym okresie po zakupie jednego produktu istnieje duże prawdopodobieństwo, że będzie on nabywał inny;

· Klasyfikacja - istnieją znaki charakteryzujące grupę, do której należy to zdarzenie lub przedmiot;

· Klastrowanie - wzorzec podobny do klasyfikacji i różniący się tym, że same grupy nie są zdefiniowane jednocześnie - są wykrywane automatycznie podczas przetwarzania danych;

· Wzorce tymczasowe - obecność wzorców w dynamice zachowania niektórych danych. Typowym przykładem tymczasowego wzorca są sezonowe wahania popytu na niektóre towary lub usługi.

1.1 Etapy w procesie eksploracji danych

Tradycyjnie w procesie eksploracji danych wyróżnia się następujące kroki:

1. Badanie obszaru tematycznego, w wyniku którego formułowane są główne cele analizy.

2. Zbieranie danych.

Wstępne przetwarzanie danych:

a) Czyszczenie danych - eliminacja niespójności i przypadkowego „szumu” z danych źródłowych

b. Integracja danych - łączenie danych z kilku możliwych źródeł w jednym magazynie. Konwersja danych. Na tym etapie dane są przekształcane do postaci odpowiedniej do analizy. Często stosuje się agregację danych, dyskretyzację atrybutów, kompresję danych i redukcję wymiarów.

4. Analiza danych. W ramach tej fazy algorytmy eksploracji są używane do wydobywania wzorców.

5. Interpretacja znalezionych wzorów. Ten krok może obejmować wizualizację wyodrębnionych wzorców, identyfikację naprawdę użytecznych wzorców na podstawie niektórych funkcji narzędziowych.

Wykorzystanie nowej wiedzy.

1.2 Elementy systemów wydobywczych

Zazwyczaj w systemach eksploracji danych wyróżnia się następujące główne elementy:

1. Baza danych, hurtownia danych lub inne repozytorium informacji. Może to być jedna lub więcej baz danych, przechowywania danych, arkuszy kalkulacyjnych, innych typów repozytoriów, w których można przeprowadzać czyszczenie i integrację.

2. Serwer bazy danych lub hurtownia danych. Określony serwer jest odpowiedzialny za pobieranie danych materiałowych na podstawie żądania użytkownika.

Baza wiedzy. Jest to wiedza domenowa, która wskazuje, jak wyszukiwać i oceniać przydatność powstałych wzorców.

Usługa pozyskiwania wiedzy. Jest integralną częścią systemu eksploracji danych i zawiera zestaw modułów funkcjonalnych do zadań takich jak charakteryzacja, wyszukiwanie asocjacji, klasyfikacja, analiza skupień i analiza odchyleń.

Moduł oceny wzoru. Ten element oblicza miary zainteresowania lub wzorce użyteczności.

Graficzny interfejs użytkownika. Moduł ten odpowiada za komunikację między użytkownikiem a systemem eksploracji danych, wizualizację wzorców w różnych formach.

1.3 Metody eksploracji danych w Data Mining

Większość metod analitycznych stosowanych w technologii Data Mining to dobrze znane algorytmy matematyczne i metody. Nowością w ich zastosowaniu jest możliwość ich wykorzystania w rozwiązywaniu określonych problemów ze względu na pojawiające się możliwości sprzętu i oprogramowania. Należy zauważyć, że większość metod Data Mining została opracowana w ramach teorii sztucznej inteligencji. Rozważ najczęściej stosowane metody:

Wyprowadzanie reguł asocjacyjnych.

2. Algorytmy sieci neuronowej, których idea opiera się na analogii z funkcjonowaniem tkanki nerwowej i że parametry początkowe są uważane za sygnały przekształcane zgodnie z istniejącymi połączeniami między „neuronami”, a odpowiedź całej sieci jest uważana za odpowiedź wynikającą z analizy do danych źródłowych.

Wybór bliskiego analogu danych źródłowych z istniejących danych historycznych. Zwana także metodą „najbliższego sąsiada”.

Drzewa decyzyjne - hierarchiczna struktura oparta na zestawie pytań sugerujących odpowiedź „Tak” lub „Nie”.

Modele klastrów służą do łączenia podobnych zdarzeń w grupy na podstawie podobnych wartości kilku pól w zestawie danych.

W następnym rozdziale opisujemy bardziej szczegółowo powyższe metody.

2. Metody eksploracji danych

2.1. Zawarcie reguł asocjacyjnych

Reguły asocjacyjne to reguły w formie „jeśli ... to ...”. Poszukiwanie takich reguł w zbiorze danych ujawnia ukryte relacje w pozornie niepowiązanych danych. Jednym z najczęściej cytowanych przykładów skojarzonych wyszukiwań reguł jest problem ze znalezieniem stabilnych relacji w koszyku. Problemem jest ustalenie, które produkty razem kupują klienci, aby specjaliści ds. Marketingu mogli odpowiednio umieścić te produkty w sklepie, aby zwiększyć sprzedaż.

Reguły asocjacyjne są zdefiniowane jako wyciągi formularza (X1, X2, ..., Xn) -\u003e Y, przy czym rozumie się, że Y może być obecny w transakcji, pod warunkiem, że X1, X2, ..., Xn są obecne w tej samej transakcji. Należy zauważyć, że słowo „może” sugeruje, że reguła nie jest tożsamością, ale jest możliwa z pewnym prawdopodobieństwem. Ponadto zestaw elementów może działać jako Y, a nie tylko jeden element. Prawdopodobieństwo znalezienia Y w transakcji, w której występują elementy X1, X2, ..., Xn, nazywa się pewnością. Procent transakcji zawierających regułę całkowitej liczby transakcji nazywany jest wsparciem. Poziom pewności, który powinien przewyższyć wiarygodność reguły, nazywa się ciekawością.

Istnieją różne typy reguł asocjacyjnych. W najprostszej formie reguły asocjacyjne zgłaszają tylko obecność lub brak powiązania. Takie reguły nazywane są logiczną regułą stowarzyszenia. Przykładem tej zasady jest: „klienci, którzy kupują jogurt, kupują również masło o niskiej zawartości tłuszczu”.

Reguły, które zbierają razem kilka reguł asocjacji, nazywane są wielopoziomowymi lub uogólnionymi regułami asocjacji. Podczas konstruowania takich reguł elementy są zwykle pogrupowane według hierarchii, a wyszukiwanie odbywa się na najwyższym poziomie koncepcyjnym. Na przykład „klienci kupujący mleko również kupują chleb”. W tym przykładzie mleko i chleb zawierają hierarchię różnych rodzajów i marek, jednak wyszukiwanie na niższym poziomie nie pozwoli ci znaleźć interesujących reguł.

Bardziej złożonym rodzajem reguły są Zasady Ilościowego Stowarzyszenia. Ten rodzaj reguły jest przeszukiwany przy użyciu atrybutów ilościowych (np. Cena) lub jakościowych (np. Płeć) i jest zdefiniowany jako (

Powyższe typy reguł nie wpływają na fakt, że transakcje z natury są zależne od czasu. Na przykład wyszukiwanie przed wystawieniem produktu na sprzedaż lub po jego zniknięciu z rynku wpłynie negatywnie na próg wsparcia. Mając to na uwadze, w algorytmach wyszukiwania Temporal Association Rules wprowadzono pojęcie czasu życia atrybutu.

Problem wyszukiwania reguł asocjacyjnych można ogólnie rozłożyć na dwie części: wyszukiwanie często spotykanych zestawów elementów i generowanie reguł na podstawie znalezionych często znalezionych zbiorów. Poprzednie badania w przeważającej części obejmowały te obszary i rozszerzały je w różnych kierunkach.

Od czasu pojawienia się algorytmu Apriori algorytm ten jest najczęściej używany w pierwszym etapie. Wiele ulepszeń, na przykład szybkości i skalowalności, ma na celu ulepszenie algorytmu Apriori, skorygowanie jego błędnej zdolności do generowania zbyt wielu kandydatów na najbardziej powszechne zestawy elementów. Apriori generuje zestawy elementów przy użyciu tylko dużych zestawów znalezionych w poprzednim kroku, bez ponownego rozpatrywania transakcji. Zmodyfikowany algorytm AprioriTid ulepsza Apriori, wykorzystując bazę danych tylko przy pierwszym przejściu. W obliczeniach w kolejnych krokach wykorzystywane są tylko dane utworzone podczas pierwszego przejścia i mające znacznie mniejszy rozmiar niż oryginalna baza danych. Prowadzi to do ogromnego wzrostu wydajności. Dalszą ulepszoną wersję algorytmu, zwaną AprioriHybrid, można uzyskać, jeśli Apriori jest używany przez kilka pierwszych przebiegów, a następnie, w późniejszych przebiegach, gdy k-ty zestaw kandydatów może być już w pełni zapisany w pamięci komputera, przełącz się na AprioriTid.

Dalsze wysiłki na rzecz poprawy algorytmu Apriori związane są z równoległością algorytmu (Count Count Distribution, Data Distribution, Candidate Distribution itp.), Jego skalowaniem (Intelligent Data Distribution, Hybrid Distribution), wprowadzeniem nowych struktur danych, takich jak drzewa często występujących elementów (wzrost FP )

Drugi etap charakteryzuje się przede wszystkim niezawodnością i zainteresowaniem. W nowych modyfikacjach opisana powyżej obsługa wymiarów, jakości i czasu jest dodawana do tradycyjnych reguł boolowskich. Algorytm ewolucyjny jest często używany do wyszukiwania reguł.

2.2 Algorytmy sieci neuronowej

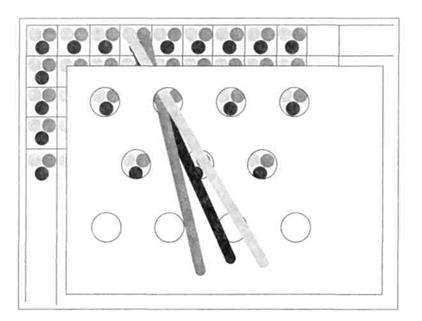

Sztuczne sieci neuronowe pojawiły się w wyniku zastosowania aparatu matematycznego do badania funkcjonowania ludzkiego układu nerwowego w celu jego odtworzenia. Mianowicie: zdolność układu nerwowego do uczenia się i korygowania błędów, co powinno pozwolić nam na symulację, choć z grubsza, pracy ludzkiego mózgu. Główną strukturalną i funkcjonalną częścią sieci neuronowej jest formalny neuron, pokazany na ryc. 1, gdzie x0, x1, ..., xn są składowymi wektora sygnału wejściowego, w0, w1, ..., wn są wagami sygnałów wejściowych neuronu, ay jest sygnałem wyjściowym neuronu.

Ryc. 1. Neuron formalny: synapsy (1), sumator (2), przetwornik (3).

Formalny neuron składa się z 3 rodzajów elementów: synaps, sumatora i przetwornika. Synapsa charakteryzuje siłę połączenia między dwoma neuronami.

Sumator wykonuje dodawanie sygnałów wejściowych, uprzednio pomnożonych przez odpowiednie wagi. Konwerter implementuje funkcję jednego argumentu - wyjście sumatora. Ta funkcja nazywa się funkcją aktywacji lub funkcją przenoszenia neuronu.

Formalne neurony opisane powyżej można łączyć w taki sposób, że sygnały wyjściowe niektórych neuronów są wprowadzane do innych. Powstały zestaw połączonych neuronów nazywa się sztucznymi sieciami neuronowymi (ANN) lub, w skrócie, sieciami neuronowymi.

Wyróżnia się następujące trzy ogólne typy neuronów, w zależności od ich pozycji w sieci neuronowej:

Neurony wejściowe (węzły wejściowe), które są zasilane sygnałami wejściowymi. Takie neurony, neurony z reguły mają jedno wejście o masie jednostkowej, nie ma odchylenia, a wartość wyjściowa neuronu jest równa sygnałowi wejściowemu;

Neurony wyjściowe (węzły wyjściowe), których wartości wyjściowe reprezentują wynikowe sygnały wyjściowe sieci neuronowej;

Ukryte neurony (ukryte węzły), które nie mają bezpośrednich połączeń z sygnałami wejściowymi, podczas gdy wartości sygnałów wyjściowych ukrytych neuronów nie są sygnałami wyjściowymi z ANN.

Zgodnie ze strukturą połączeń międzyneuronalnych wyróżnia się dwie klasy ANN:

Bezpośrednia propagacja ANN, w której sygnał rozchodzi się tylko od neuronów wejściowych do neuronów wyjściowych.

Cykliczny ANN - ANN z informacją zwrotną. W takich ANN sygnały mogą być przesyłane między dowolnymi neuronami, niezależnie od ich lokalizacji w ANN.

Istnieją dwa ogólne podejścia do szkolenia ANN:

Trening z nauczycielem.

Uczenie się bez nauczyciela.

Nauczanie z nauczycielem (uczenie nadzorowane) polega na wykorzystaniu gotowego zestawu przykładów szkolenia. Każdy przykład zawiera wektor sygnałów wejściowych i odpowiedni wektor referencyjnych sygnałów wyjściowych, które zależą od zadania. Ten zestaw nazywa się zestawem treningowym lub zestawem treningowym. Trening sieci neuronowej ma na celu taką zmianę wag połączeń ANN, w których wartość sygnałów wyjściowych ANN różni się w jak najmniejszym stopniu od wymaganych wartości sygnałów wyjściowych dla danego wektora sygnałów wejściowych.

Podczas uczenia się bez nauczyciela (nauka bez nadzoru) dostosowuje się wagi połączeń w wyniku rywalizacji między neuronami lub z uwzględnieniem korelacji sygnałów wyjściowych neuronów, między którymi istnieje połączenie. W przypadku szkolenia bez nauczyciela próbka szkolenia nie jest wykorzystywana.

Sieci neuronowe są wykorzystywane do rozwiązywania szerokiego zakresu zadań, na przykład planowania ładunków dla promów kosmicznych i prognozowania kursów walut. Jednak nie są one często używane w systemach eksploracji danych ze względu na złożoność modelu (wiedza zapisana jako wagi kilkuset połączeń międzyururonowych jest całkowicie poza ludzką analizą i interpretacją) oraz długi czas uczenia się w dużym zestawie szkoleniowym. Z drugiej strony sieci neuronowe mają takie zalety w zastosowaniu do analizy danych, jak odporność na zaszumione dane i wysoka dokładność.

2.3 Metody najbliższego sąsiada i najbliższych sąsiadów

Algorytm najbliższego sąsiada i k-najbliższego sąsiada (KNN) są oparte na podobieństwie obiektów. Algorytm najbliższego sąsiada rozróżnia spośród wszystkich znanych obiektów obiekt, który jest jak najbliżej (używając metryki odległości między obiektami, na przykład Euklidesa) do nowego, wcześniej nieznanego obiektu. Głównym problemem metody najbliższego sąsiada jest jej wrażliwość na wartości odstające w danych treningowych.

Opisanego problemu można uniknąć dzięki algorytmowi KNN, który rozróżnia wszystkie obserwacje już najbliższych sąsiadów, podobnych do nowego obiektu. Na podstawie klas najbliższych sąsiadów podejmuje się decyzję dotyczącą nowego obiektu. Ważnym zadaniem tego algorytmu jest wybór współczynnika k - liczby rekordów, które zostaną uznane za podobne. Modyfikacja algorytmu, w którym wkład sąsiada jest proporcjonalny do odległości do nowego obiektu (metoda najbliższych sąsiadów ważonych k) pozwala na osiągnięcie większej dokładności klasyfikacji. Metoda k najbliższych sąsiadów pozwala również oszacować dokładność prognozy. Na przykład wszyscy k najbliższych sąsiadów mają tę samą klasę, więc prawdopodobieństwo, że sprawdzany obiekt będzie miał tę samą klasę, jest bardzo wysokie.

Wśród cech algorytmu warto zwrócić uwagę na odporność na nietypowe wartości odstające, ponieważ prawdopodobieństwo takiego wejścia do liczby najbliższych sąsiadów jest niewielkie. Jeśli tak się stanie, wówczas wpływ na głosowanie (szczególnie zrównoważony) (dla k\u003e 2) również będzie nieznaczny, a zatem wpływ na wynik klasyfikacji będzie niewielki. Zaletą jest także prosta implementacja, łatwość interpretacji wyniku algorytmu, możliwość modyfikacji algorytmu za pomocą najbardziej odpowiednich kombinacji funkcji i metryk, co pozwala dostosować algorytm do konkretnego zadania. Algorytm KNN ma również szereg wad. Po pierwsze, zestaw danych użyty dla algorytmu musi być reprezentatywny. Po drugie, nie można oddzielić modelu od danych: aby sklasyfikować nowy przykład, musisz użyć wszystkich przykładów. Ta funkcja poważnie ogranicza użycie algorytmu.

2.4 Drzewa decyzyjne

Termin „drzewa decyzyjne” oznacza rodzinę algorytmów opartych na prezentacji reguł klasyfikacji w hierarchicznej, spójnej strukturze. Jest to najpopularniejsza klasa algorytmów do rozwiązywania problemów eksploracji danych.

Rodzina algorytmów do konstruowania drzew decyzyjnych pozwala przewidzieć wartość parametru dla danego przypadku na podstawie dużej ilości danych o innych podobnych przypadkach. Zazwyczaj algorytmy z tej rodziny są używane do rozwiązywania problemów, które pozwalają podzielić wszystkie dane źródłowe na kilka odrębnych grup.

Podczas stosowania algorytmów do konstruowania drzew decyzyjnych do zestawu danych źródłowych wynik jest wyświetlany w postaci drzewa. Takie algorytmy umożliwiają wdrożenie kilku poziomów takiego rozdzielenia, dzieląc powstałe grupy (gałęzie drzew) na mniejsze na podstawie innych cech. Separacja trwa do momentu, gdy przewidywane wartości staną się takie same (lub, w przypadku ciągłej wartości przewidywanego parametru, zamknij) dla wszystkich uzyskanych grup (liści drzewa). To właśnie te wartości służą do prognozowania na podstawie tego modelu.

Działanie algorytmów do konstruowania drzew decyzyjnych opiera się na zastosowaniu metod analizy regresji i korelacji. Jednym z najpopularniejszych algorytmów tej rodziny jest CART (drzewa klasyfikacji i regresji), oparty na dzieleniu danych w gałęzi drzewa na dwie gałęzie podrzędne; dalszy podział tej gałęzi zależy od tego, ile danych początkowych opisuje ta gałąź. Niektóre inne podobne algorytmy pozwalają podzielić gałąź na większą liczbę gałęzi potomnych. W tym przypadku separacja opiera się na najwyższym współczynniku korelacji dla gałęzi danych opisanej przez parametr, zgodnie z którym następuje separacja, i parametrze, który należy przewidzieć w przyszłości.

Popularność tego podejścia wiąże się z jasnością i zrozumiałością. Ale drzewa decyzyjne zasadniczo nie są w stanie znaleźć „najlepszych” (najbardziej kompletnych i dokładnych) reguł w danych. Realizują naiwną zasadę sekwencyjnego oglądania znaków i faktycznie znajdują części tych wzorów, tworząc jedynie iluzję logicznego wniosku.

2.5 Algorytmy grupowania

Klastrowanie polega na rozkładaniu wielu obiektów na grupy zwane klastrami. Główną różnicą między klastrowaniem a klasyfikacją jest to, że lista grup nie jest jasno zdefiniowana i jest ustalana podczas działania algorytmu.

Ogólne zastosowanie analizy skupień ogranicza się do następujących kroków:

· Wybór próbki obiektów do grupowania;

· Określenie zestawu zmiennych, według których oceniane będą obiekty w próbce. W razie potrzeby - normalizacja wartości zmiennych;

· Obliczanie wartości miary podobieństwa między obiektami;

· Zastosowanie metody analizy skupień do tworzenia grup podobnych obiektów (klastrów);

· Prezentacja wyników analizy.

Po otrzymaniu i przeanalizowaniu wyników można dostosować wybraną metrykę i metodę grupowania, aby uzyskać optymalny wynik.

Wśród algorytmów klastrowania wyróżnia się grupy hierarchiczne i płaskie. Algorytmy hierarchiczne (zwane również algorytmami taksonomii) budują nie tylko jedną partycję próbki w rozłączne klastry, ale system zagnieżdżonych partycji. Zatem wynikiem działania algorytmu jest drzewo klastrów, których rdzeniem jest cała próbka, a liście są najmniejszymi klastrami. Płaskie algorytmy budują jedną partycję obiektów w rozłączne klastry.

Kolejna klasyfikacja algorytmów klastrowania obejmuje algorytmy jasne i rozmyte. Algorytmy jasne (lub rozłączne) kojarzą numer klastra z każdym obiektem przykładowym, to znaczy każdy obiekt należy do tylko jednego klastra. Algorytmy rozmyte (lub przecinające się) dla każdego obiektu kojarzą zestaw wartości rzeczywistych, które pokazują stopień relacji obiektu do klastrów. Zatem każdy obiekt należy do każdego klastra z pewnym prawdopodobieństwem.

Wśród hierarchicznych algorytmów klastrowych wyróżnia się dwa główne typy: algorytmy poprzedzające i następcze. Algorytmy odgórne działają zgodnie z zasadą „zstępującą”: \u200b\u200bpo pierwsze wszystkie obiekty są umieszczane w jednym klastrze, który jest następnie dzielony na coraz mniejsze klastry. Algorytmy poprzedzające są bardziej powszechne, które na początku pracy umieszczają każdy obiekt w osobnym klastrze, a następnie łączą klastry w większe, aż wszystkie wybrane obiekty znajdą się w jednym klastrze. W ten sposób konstruowany jest system partycji zagnieżdżonych. Wyniki takich algorytmów są zwykle przedstawiane w formie drzewa.

Wadą algorytmów hierarchicznych jest system kompletnych partycji, które mogą być zbędne w kontekście rozwiązania problemu.

Rozważmy teraz płaskie algorytmy. Najprostsze w tej klasie są kwadratowe algorytmy błędów. Problem klastrowania dla tych algorytmów można uznać za budowanie optymalnej partycji obiektów na grupy. Ponadto optymalność można zdefiniować jako wymóg minimalizacji średniego błędu kwadratowego partycji:

,

,

gdzie c j jest „środkiem masy” gromady j (punkt ze średnimi wartościami cech dla tego klastra).

Najpopularniejszym algorytmem w tej kategorii jest metoda k-średnich. Algorytm ten buduje określoną liczbę klastrów zlokalizowanych jak najdalej od siebie. Algorytm dzieli się na kilka etapów:

Losowo wybierz k punkty, które są początkowymi „środkami masy” skupisk.

2. Przypisz każdy obiekt do gromady z najbliższym „środkiem masy”.

Jeśli kryterium zatrzymania algorytmu nie jest spełnione, wróć do kroku 2.

Jako kryterium zatrzymania działania algorytmu zwykle wybiera się minimalną zmianę błędu standardowego. Możliwe jest również zatrzymanie działania algorytmu, jeśli w kroku 2 nie było obiektów przemieszczających się z klastra do klastra. Wady tego algorytmu obejmują konieczność określenia liczby klastrów dla partycji.

Najpopularniejszym algorytmem grupowania rozmytego jest algorytm c-średnich. Jest to modyfikacja metody k-średnich. Kroki algorytmu:

1. Wybierz początkową rozmytą partycję n obiekty na k klastry, wybierając macierz członkostwa U rozmiar n x k.

2. Korzystając z macierzy U, znajdź wartość kryterium błędu rozmytego:

,

,

gdzie c k - „środek masy” rozmytej gromady k:

3. Ponownie zgrupuj obiekty, aby zmniejszyć tę wartość kryterium błędu rozmytego.

4. Wróć do kroku 2, aż matryca się zmieni U nie stanie się nieznaczny.

Algorytm ten może nie być odpowiedni, jeśli liczba klastrów nie jest wcześniej znana lub konieczne jest jednoznaczne przypisanie każdego obiektu do jednego klastra.

Kolejną grupą algorytmów są algorytmy oparte na teorii grafów. Istotą takich algorytmów jest to, że próbka obiektów jest reprezentowana w postaci wykresu G \u003d (V, E)których wierzchołki odpowiadają obiektom, a krawędzie mają ciężar równy „odległości” między obiektami. Zaletami algorytmów grupowania wykresów są widoczność, względna łatwość implementacji i możliwość wprowadzenia różnych ulepszeń w oparciu o względy geometryczne. Głównymi algorytmami są algorytm wyboru połączonych komponentów, algorytm konstruowania minimalnego drzewa opinającego oraz algorytm klastrowania warstwa po warstwie.

Aby wybrać parametr R zwykle budowany jest histogram rozkładów odległości parami. W przypadku problemów z dobrze zdefiniowaną strukturą danych skupień histogram będzie miał dwa piki - jeden odpowiada odległościom wewnątrzklastrowym, drugi odległościom międzyklastrowym. Parametr R wybrane z minimalnej strefy między tymi pikami. Jednocześnie kontrolowanie liczby klastrów przy użyciu progu odległości jest raczej trudne.

Algorytm minimalnego drzewa opinającego najpierw tworzy minimalne drzewo opinające na wykresie, a następnie kolejno usuwa krawędzie o największej wadze. Algorytm grupowania warstwa po warstwie opiera się na wyborze połączonych elementów wykresu na pewnym poziomie odległości między obiektami (wierzchołkami). Poziom odległości jest ustalany przez próg odległości. c. Na przykład, jeśli odległość między obiektami, to.

Warstwowy algorytm grupowania tworzy sekwencję wykresów podrzędnych G.odzwierciedlające hierarchiczne relacje między klastrami:

![]() ,

,

gdzie G. t \u003d (V, E t )

- wykres poziomu z t ![]() ,

,

z t jest dziesiątym progiem odległości, m jest liczbą poziomów hierarchii,

G. 0 \u003d (V, o), o jest pustym zbiorem krawędzi wykresu uzyskanym dla t 0 = 1,

G. m \u003d G, tj. wykres obiektów bez ograniczeń odległości (długość krawędzi wykresu), ponieważ t m \u003d 1.

Zmieniając progi odległości ( z 0 , ..., z m), gdzie 0 \u003d z 0 < z 1 < …< z m \u003d 1, możliwe jest kontrolowanie głębokości hierarchii wynikowych klastrów. W ten sposób algorytm klastrowania warstwa po warstwie może tworzyć zarówno płaską partycję danych, jak i hierarchiczną.

Klastrowanie pozwala osiągnąć następujące cele:

· Poprawia zrozumienie danych poprzez identyfikację grup strukturalnych. Podział próbki na grupy podobnych obiektów umożliwia uproszczenie dalszego przetwarzania danych i podejmowania decyzji poprzez zastosowanie innej metody analizy do każdego klastra;

· Umożliwia kompaktowe przechowywanie danych. Aby to zrobić, zamiast przechowywać całą próbkę, można zostawić jedną typową obserwację z każdej grupy;

· Wykrywanie nowych nietypowych obiektów, które nie wpadły w żaden klaster.

Zazwyczaj klastrowanie jest stosowane jako metoda pomocnicza w analizie danych.

2.6 Algorytmy genetyczne

Algorytmy genetyczne należą do uniwersalnych metod optymalizacji, które pozwalają na rozwiązywanie problemów różnego rodzaju (kombinatoryczne, ogólne problemy z ograniczeniami i bez ograniczeń) oraz o różnym stopniu złożoności. Ponadto algorytmy genetyczne charakteryzują się możliwością wyszukiwania pojedynczych kryteriów i kryteriów wielokryterialnych na dużej przestrzeni, której krajobraz nie jest gładki.

Ta grupa metod wykorzystuje iteracyjny proces ewolucji sekwencji generacji modeli, w tym operacje selekcji, mutacji i krzyżowania. Na początku algorytmu populacja jest formowana losowo. Aby ocenić jakość zakodowanych rozwiązań, wykorzystywana jest funkcja sprawności, która jest niezbędna do obliczenia sprawności każdej osoby. Zgodnie z wynikami oceny osób, najbardziej przystosowane z nich wybiera się do przejścia. W wyniku krzyżowania wybranych osobników za pomocą krzyżowego operatora genetycznego powstaje potomstwo, którego informacja genetyczna powstaje w wyniku wymiany informacji chromosomowych między osobnikami rodzicielskimi. Stworzeni potomkowie tworzą nową populację, a niektórzy potomkowie mutują, co wyraża się losową zmianą ich genotypów. Etap, w tym sekwencja „Ocena populacji” - „Selekcja” - „Przejście” - „Mutacja”, nazywa się pokoleniem. Ewolucja populacji składa się z sekwencji takich pokoleń.

Wyróżnia się następujące algorytmy selekcji do hodowli:

Panmixia Obie osoby tworzące parę rodzicielską są losowo wybierane z całej populacji. Każda osoba może zostać członkiem kilku par. To podejście jest uniwersalne, ale wydajność algorytmu maleje wraz ze wzrostem liczby ludności.

· Hodowla Osoby o sprawności fizycznej nie niższej niż średnia mogą zostać rodzicami. Takie podejście zapewnia szybszą konwergencję algorytmu.

Chów wsobny. Metoda opiera się na parowaniu opartym na bliskim pokrewieństwie. Przez pokrewieństwo rozumie się tutaj odległość między członkami populacji, zarówno w sensie geometrycznej odległości jednostek w przestrzeni parametrów, jak i hemingowej odległości między genotypami. Dlatego rozróżnij wsród genotypów i fenotypów. Pierwszy członek pary, która ma zostać skrzyżowana, jest wybierany losowo, a drugi jest bardziej prawdopodobne, że jest najbliżej niej. Chów wsobny można scharakteryzować właściwością koncentracji poszukiwań w lokalnych węzłach, co w rzeczywistości prowadzi do podziału populacji na odrębne grupy lokalne wokół obszarów podejrzanych o ekstremum.

· Krzyżowanie. Formacja pary na podstawie dalekiego pokrewieństwa dla najbardziej odległych osób. Outbreeding ma na celu zapobieganie konwergencji algorytmu do już znalezionych rozwiązań, zmuszając algorytm do przeglądania nowych, niezbadanych obszarów.

Algorytmy tworzenia nowej populacji:

· Wybór ekstrakcji. Spośród wszystkich osób o tych samych genotypach pierwszeństwo mają ci, których sprawność jest wyższa. W ten sposób osiąga się dwa cele: znalezione najlepsze rozwiązania, które mają różne zestawy chromosomów, nie są tracone, a populacja stale utrzymuje wystarczającą różnorodność genetyczną. Wytłaczanie tworzy nową populację odległych osobników, zamiast grupowania się wokół obecnie znalezionego rozwiązania. Metodę tę stosuje się do zadań ekstremalnych.

· Wybór elity. Elitarne metody selekcji zapewniają, że najlepsi członkowie populacji przetrwają selekcję. Jednocześnie niektóre z najlepszych osób przechodzą bez zmian do następnej generacji. Szybką zbieżność zapewnianą przez elitarną selekcję można zrekompensować odpowiednią metodą wyboru par rodzicielskich. W takim przypadku często używają krzyżowania. To właśnie ta kombinacja „krzyżowania - selekcji elitarnej” jest jedną z najbardziej skutecznych.

· Wybór turnieju. Wybór turnieju realizuje n turniejów, aby wybrać n osób. Każdy turniej opiera się na doborze k elementów z populacji i wybieraniu spośród nich najlepszej osoby. Najczęstszy wybór turnieju z k \u003d 2.

Jedną z najpopularniejszych aplikacji algorytmów genetycznych w dziedzinie Data Mining jest poszukiwanie najbardziej optymalnego modelu (poszukiwanie algorytmu pasującego do specyfiki danego obszaru). Algorytmy genetyczne są wykorzystywane przede wszystkim do optymalizacji topologii sieci neuronowych i wag. Można ich również używać jako samodzielnego narzędzia.

3. Aplikacje

Technologia Data Mining ma naprawdę szeroki zakres zastosowań, będąc w rzeczywistości zestawem uniwersalnych narzędzi do analizy danych dowolnego typu.

Marketing

Jednym z pierwszych obszarów, w których zastosowano technologie eksploracji danych, był marketing. Zadanie, które rozpoczęło opracowywanie metod Data Mining, nazywa się analizą koszyka zakupów.

To zadanie polega na identyfikacji produktów, które kupujący chcą kupować razem. Znajomość koszyka zakupów jest niezbędna w kampaniach reklamowych, tworzeniu osobistych rekomendacji dla klientów, opracowywaniu strategii tworzenia zapasów towarów i sposobów ich rozmieszczania w parkietach handlowych.

Również w marketingu podejmowane są takie zadania, jak określenie docelowej grupy odbiorców produktu w celu skuteczniejszej promocji; badanie wzorców tymczasowych, które pomaga przedsiębiorstwom podejmować decyzje dotyczące tworzenia zapasów; tworzenie modeli predykcyjnych, które umożliwiają przedsiębiorstwom rozpoznanie charakteru potrzeb różnych kategorii klientów o określonych zachowaniach; przewidywanie lojalności klienta, które pozwala wstępnie zidentyfikować moment, w którym klient odchodzi, analizując swoje zachowanie i ewentualnie zapobiec utracie cennego klienta.

Przemysł

Jednym z ważnych obszarów w tym obszarze jest monitorowanie i kontrola jakości, w których za pomocą narzędzi analitycznych można przewidzieć awarię sprzętu, awarie i zaplanować naprawy. Przewidywanie popularności niektórych cech i wiedza, które cechy są zwykle zamawiane razem, pomaga zoptymalizować produkcję i zorientować ją na rzeczywiste potrzeby konsumentów.

Medycyna

W medycynie analiza danych jest również stosowana z powodzeniem. Przykładem zadania jest analiza wyników badań, diagnostyka, porównanie skuteczności metod leczenia i leków, analiza chorób i ich rozprzestrzeniania się oraz identyfikacja skutków ubocznych. Technologie Data Mining, takie jak reguły asocjacyjne i wzorce sekwencyjne, zostały z powodzeniem zastosowane w celu identyfikacji związków między podawaniem leku a skutkami ubocznymi.

Genetyka molekularna i inżynieria genetyczna

Być może najostrzejszym, a jednocześnie najwyraźniej zadaniem wykrywania wzorców w danych eksperymentalnych jest genetyka molekularna i inżynieria genetyczna. Tutaj jest sformułowany jako definicja markerów, które są rozumiane jako kody genetyczne, które kontrolują pewne fenotypowe oznaki żywego organizmu. Takie kody mogą zawierać setki, tysiące lub więcej powiązanych elementów. Wynikiem analizy analitycznej danych jest także związek między zmianami w sekwencji ludzkiego DNA a ryzykiem różnych chorób odkrytych przez naukowców genetyki.

Chemia stosowana

Metody eksploracji danych są również stosowane w dziedzinie chemii stosowanej. To często rodzi pytanie o wyjaśnienie cech struktury chemicznej różnych związków, które determinują ich właściwości. Takie zadanie jest szczególnie istotne w analizie złożonych związków chemicznych, których opis obejmuje setki i tysiące elementów strukturalnych i ich wiązań.

Kontrola przestępczości

W celu zapewnienia bezpieczeństwa narzędzia Data Mining są używane stosunkowo niedawno, jednak już uzyskano praktyczne wyniki, które potwierdzają skuteczność eksploracji danych w tym obszarze. Szwajcarscy naukowcy opracowali system analizy aktywności protestacyjnej w celu przewidywania przyszłych incydentów oraz system śledzenia pojawiających się cyberzagrożeń i działań hakerów na świecie. Ten drugi system pozwala przewidywać cyberzagrożenia i inne zagrożenia bezpieczeństwa informacji. Ponadto z powodzeniem zastosowano metody wyszukiwania danych w celu wykrywania oszustw związanych z kartami kredytowymi. Analizując przeszłe transakcje, które później okazały się nieuczciwe, bank ujawnia pewne stereotypy takich oszustw.

Inne zastosowania

· Analiza ryzyka. Na przykład, identyfikując kombinacje czynników związanych z płatnymi wnioskami, ubezpieczyciele mogą zmniejszyć swoje straty z tytułu zobowiązań. Znany jest przypadek, gdy w USA duża firma ubezpieczeniowa stwierdziła, że \u200b\u200bkwoty wypłacane za wnioski od osób pozostających w związku małżeńskim są dwukrotnością kwoty za wnioski złożone przez osoby samotne. Firma odpowiedziała na tę nową wiedzę, zmieniając swoją ogólną politykę udzielania rabatów klientom rodzinnym.

· Meteorologia. Prognozowanie pogody za pomocą metod sieci neuronowej, w szczególności stosuje się samoorganizujące się mapy Kohonen.

· Polityka kadrowa. Narzędzia analityczne pomagają służbom HR w wyborze najlepszych kandydatów na podstawie analizy ich danych CV, w celu modelowania cech idealnych pracowników na dane stanowisko.

4. Producenci Data Mining

Data Mining jest tradycyjnie drogim oprogramowaniem. Dlatego do niedawna głównymi odbiorcami tej technologii były banki, firmy finansowe i ubezpieczeniowe, duże przedsiębiorstwa handlowe, a głównymi zadaniami wymagającymi korzystania z Data Mining były ocena ryzyka kredytowego i ubezpieczeniowego oraz opracowanie polityk marketingowych, planów taryfowych i innych zasad współpracy z klientami. W ostatnich latach sytuacja uległa pewnym zmianom: na rynku oprogramowania pojawiły się stosunkowo niedrogie narzędzia Data Mining, a nawet systemy bezpłatnej dystrybucji, które udostępniły tę technologię małym i średnim przedsiębiorstwom.

Wśród płatnych narzędzi i systemów do analizy danych liderami są SAS Institute (SAS Enterprise Miner), SPSS (SPSS, Clementine) i StatSoft (STATISTICA Data Miner). Rozwiązania Angoss (Angoss KnowledgeSTUDIO), IBM (IBM SPSS Modeler), Microsoft (Microsoft Analysis Services) i (Oracle) Oracle Data Mining są dość dobrze znane.

Wybór wolnego oprogramowania jest również zróżnicowany. Istnieją uniwersalne narzędzia analityczne, takie jak JHepWork, KNIME, Orange, RapidMiner, a także narzędzia specjalistyczne, na przykład Carrot2 - framework do grupowania danych tekstowych i wyników wyszukiwania, Chemicalize.org - rozwiązanie w dziedzinie chemii stosowanej, NLTK (Natural Language Toolkit) narzędzie do przetwarzania języka naturalnego (przetwarzanie języka naturalnego).

5. Krytyka metod

Wyniki Data Mining w dużej mierze zależą od poziomu przygotowania danych, a nie od „wspaniałych możliwości” określonego algorytmu lub zestawu algorytmów. Około 75% prac nad Data Mining to gromadzenie danych, które odbywa się jeszcze przed zastosowaniem narzędzi analitycznych. Nieumiejętne korzystanie z narzędzi doprowadzi do bezsensownego marnowania potencjału firmy, a czasem do milionów dolarów.

Opinia Herb Edelstein, światowej sławy eksperta w dziedzinie eksploracji danych, hurtowni danych i CRM: „Ostatnie badanie przeprowadzone przez Two Crows wykazało, że eksploracja danych jest wciąż na wczesnym etapie rozwoju. Wiele organizacji jest zainteresowanych tą technologią, ale tylko kilka aktywnie wdraża takie projekty. Udało nam się odkryć jeszcze jedną ważną kwestię: proces wdrażania Data Mining w praktyce jest bardziej skomplikowany niż się spodziewano: zespoły porwały mit, że narzędzia Data Mining są łatwe w użyciu. Zakłada się, że wystarczy uruchomić takie narzędzie w bazie danych terabajtów, a przydatne informacje natychmiast się pojawią. W rzeczywistości udany projekt Data Mining wymaga zrozumienia istoty działalności, znajomości danych i narzędzi, a także procesu analizy danych. ” Dlatego przed użyciem technologii Data Mining konieczne jest staranne przeanalizowanie ograniczeń nałożonych przez metody i związane z nimi krytyczne problemy, a także trzeźwa ocena możliwości tej technologii. Krytyczne problemy obejmują:

1. Technologia nie może udzielić odpowiedzi na pytania, które nie zostały zadane. Nie może zastąpić analityka, a jedynie daje mu potężne narzędzie ułatwiające i usprawniające jego pracę.

2. Złożoność opracowywania i obsługi aplikacji Data Mining.

Ponieważ technologia ta jest interdyscyplinarną dziedziną, w celu opracowania aplikacji obejmującej Data Mining konieczne jest zaangażowanie specjalistów z różnych dziedzin, a także zapewnienie wysokiej jakości interakcji.

3. Kwalifikacje użytkownika.

Różne narzędzia Data Mining mają różny stopień „przyjazności” interfejsu i wymagają pewnych umiejętności użytkownika. Dlatego oprogramowanie musi być zgodne z poziomem szkolenia użytkowników. Korzystanie z Data Mining powinno być nierozerwalnie związane z zaawansowanym szkoleniem użytkownika. Jednak specjalistów od Data Mining, dobrze znających procesy biznesowe, jest obecnie niewielu.

4. Wydobycie użytecznych informacji jest niemożliwe bez dobrego zrozumienia istoty danych.

Konieczny jest staranny wybór modelu i interpretacja wykrywanych zależności lub wzorców. Dlatego praca z takimi narzędziami wymaga ścisłej współpracy między ekspertem w danej dziedzinie a specjalistą w zakresie narzędzi Data Mining. Modele stałe muszą być odpowiednio zintegrowane z procesami biznesowymi, aby móc oceniać i aktualizować modele. Ostatnio systemy Data Mining zostały dostarczone w ramach technologii hurtowni danych.

5. Złożoność przygotowania danych.

Pomyślna analiza wymaga wysokiej jakości przetwarzania danych. Według analityków i użytkowników baz danych proces wstępnego przetwarzania może zająć do 80% całego procesu eksploracji danych.

Tak więc, aby technologia działała sama, zajmie to dużo wysiłku i czasu, które trzeba poświęcić na wstępną analizę danych, wybór modelu i dostosowanie.

6. Duży odsetek wyników fałszywych, fałszywych lub niepomocnych.

Za pomocą technologii Data Mining można znaleźć naprawdę bardzo cenne informacje, które mogą dać znaczącą przewagę w planowaniu, zarządzaniu i podejmowaniu decyzji w przyszłości. Jednak wyniki uzyskane za pomocą metod Data Mining dość często zawierają fałszywe i bezsensowne wnioski. Wielu ekspertów twierdzi, że narzędzia Data Mining mogą generować ogromną liczbę statystycznie niewiarygodnych wyników. Aby zmniejszyć odsetek takich wyników, należy zweryfikować adekwatność uzyskanych modeli do danych testowych. Nie można jednak całkowicie uniknąć fałszywych wniosków.

7. Wysoki koszt.

Wysokiej jakości oprogramowanie jest wynikiem znacznej pracy dewelopera. Dlatego oprogramowanie Data Mining było tradycyjnie drogim oprogramowaniem.

8. Dostępność wystarczającej ilości reprezentatywnych danych.

Narzędzia Data Mining, w przeciwieństwie do narzędzi statystycznych, teoretycznie nie wymagają ściśle określonej ilości danych historycznych. Ta funkcja może powodować wykrywanie fałszywych, fałszywych modeli, aw rezultacie przyjęcie ich na podstawie nieprawidłowych decyzji. Konieczne jest kontrolowanie statystycznego znaczenia odkrytej wiedzy.

algorytm wydobywania klastrów sieci neuronowej

Wniosek

Podano krótki opis obszarów zastosowania oraz krytykę technologii Data Mining i opinię ekspertów w tej dziedzinie.

Listaliteratura

1. Han i Micheline Kamber. Data Mining: koncepcje i techniki. Druga edycja. - University of Illinois at Urbana-Champaign

Berry, Michael J. A. Techniki eksploracji danych: marketing, sprzedaż i zarządzanie relacjami z klientami - wydanie 2.

Siu Nin Lam. Odkrywanie reguł asocjacyjnych w eksploracji danych. - Wydział Informatyki University of Illinois w Urbana-Champaign

Systemy OLAP zapewniają analitykowi narzędzia do testowania hipotez do analizy danych, to znaczy głównym zadaniem analityka jest generowanie hipotez, które rozwiązuje na podstawie swojej wiedzy i doświadczenia. Wiedza istnieje jednak nie tylko u ludzi, ale także w zgromadzonych danych, które są analizowane . Taka wiedza jest zawarta w ogromnej ilości informacji, których dana osoba nie jest w stanie samodzielnie zbadać. Pod tym względem prawdopodobne jest, że przeoczą hipotezy, które mogą przynieść znaczące korzyści.

Aby wykryć „ukrytą” wiedzę, stosuje się specjalne metody automatycznej analizy, za pomocą których musisz praktycznie uzyskać wiedzę z „blokad” informacji. Termin „eksploracja danych (DataMining)” lub „eksploracja danych” został przypisany do tego obszaru.

Istnieje wiele definicji DataMining, które się uzupełniają. Oto niektóre z nich.

DataMining to proces odkrywania nietrywialnych i praktycznie przydatnych wzorców w bazach danych. (BaseGroup)

DataMining to proces wydobywania, badania i modelowania dużych ilości danych w celu wykrycia nieznanych wcześniej struktur (wzorów) w celu osiągnięcia korzyści biznesowych (SAS Institute)

DataMining jest procesem, którego celem jest wykrywanie nowych znaczących korelacji, wzorców i trendów w wyniku przesiewania dużej ilości przechowywanych danych przy użyciu technik rozpoznawania próbek oraz przy użyciu metod statystycznych i matematycznych (GartnerGroup)

DataMining to badanie i odkrywanie przez „maszynę” (algorytmy, sztuczna inteligencja) w surowych danych ukrytej wiedzy, żewcześniej nieznane, nietrywialne, praktycznie przydatne, dostępne do interpretacjiprzez człowieka. (A. Bargesyan „Data Analysis Technologies”)

DataMining to proces odkrywania przydatnej wiedzy o firmie (N.M. Abdikeev „KBA”)

Wykrywalne właściwości wiedzy

Zastanów się nad właściwościami odkrytej wiedzy.

- Wiedza musi być nowa, wcześniej nieznana. Wysiłki włożone w odkrycie wiedzy, która jest już znana użytkownikowi, się nie opłaca. Dlatego nowa, nieznana wcześniej wiedza ma wartość.

- Wiedza powinna być nietrywialna. Wyniki analizy powinny odzwierciedlać nieoczywiste, nieoczekiwanewzorce w danych, które składają się na tak zwaną wiedzę ukrytą. Wyniki, które można uzyskać w prostszy sposób (na przykład poprzez wizualne oglądanie), nie uzasadniają zastosowania potężnych metod DataMining.

- Wiedza powinna być praktycznie przydatna. Znaleziona wiedza powinna mieć zastosowanie, w tym w zakresie nowych danych, z dość wysokim poziomem niezawodności. Przydatność polega na tym, że ta wiedza może przynieść pewne korzyści w ich zastosowaniu.

- Wiedza powinna być dostępna dla ludzkiego zrozumienia. Znalezione wzorce muszą być logicznie możliwe do wyjaśnienia, w przeciwnym razie istnieje możliwość, że są przypadkowe. Ponadto odkryta wiedza powinna być przedstawiona w formie czytelnej dla człowieka.

W DataMining modele służą do reprezentowania zdobytej wiedzy. Rodzaje modeli zależą od metod ich tworzenia. Najczęstsze to: reguły, drzewa decyzyjne, klastry i funkcje matematyczne.

Zadania DataMining

Przypomnijmy, że technologia DataMining opiera się na koncepcji wzorców reprezentujących prawidłowości. W wyniku odkrycia tych wzorów, ukrytych gołym okiem, problemy DataMining zostały rozwiązane. Różne typy wzorców, które można wyrazić w formie zrozumiałej dla ludzi, odpowiadają określonym zadaniom DataMining.

Nie ma zgodności co do zadań, które należy przypisać do DataMining. Najbardziej renomowane źródła wymieniają następujące: klasyfikacja,

grupowanie, prognozowanie, asocjacja, wizualizacja, analiza i wykrywanie

odchylenia, ocena, analiza związków, podsumowanie.

Poniższy opis ma na celu ogólne przedstawienie zadań DataMining, porównanie niektórych z nich, a także przedstawienie metod rozwiązywania tych zadań. Najczęstsze zadania DataMining to klasyfikacja, klastrowanie, asocjacja, prognozowanie i wizualizacja. W związku z tym zadania są podzielone według rodzaju wytwarzanych informacji, jest to najbardziej ogólna klasyfikacja zadań DataMining.

Klasyfikacja

Zadanie dzielenia zestawu obiektów lub obserwacji na zdefiniowane z góry grupy, zwane klasami, wewnątrz których każda z nich powinna być do siebie podobna, posiadając w przybliżeniu te same właściwości i znaki. Rozwiązanie opiera się naanaliza wartości atrybutów (znaków).

Klasyfikacja jest jednym z najważniejszych zadań.Eksploracja danych . Jest stosowany wmarketing w ocenie zdolności kredytowej kredytobiorców, określanielojalność klientów rozpoznawanie wzorów , diagnostyka medyczna i wiele innych aplikacji. Jeśli analityk zna właściwości obiektów każdej klasy, to gdy nowa obserwacja dotyczy konkretnej klasy, właściwości te mają do niej zastosowanie automatycznie.

Jeśli liczba klas jest ograniczona do dwóch, wówczasklasyfikacja binarna do których można zredukować wiele bardziej złożonych zadań. Na przykład zamiast określać takie stopnie ryzyka kredytowego, jak „Wysoki”, „Średni” lub „Niski”, można użyć tylko dwóch - „Wydanie” lub „Odmowa”.

DataMining wykorzystuje wiele różnych modeli do klasyfikacji:sieci neuronowe, drzewa decyzyjne , obsługują maszyny wektorowe, metodę k-najbliższego sąsiada, algorytmy pokrycia itp., w konstrukcji których stosuje się szkolenie z nauczycielem, gdyzmienna wyjściowa (etykieta klasy ) ustawia się dla każdej obserwacji. Klasyfikacja jest formalnie oparta na partycjiprzestrzenie cech na obszarach, w ramach których każdywektory wielowymiarowe uważane za identyczne. Innymi słowy, jeśli obiekt wpada w obszar przestrzeni związany z określoną klasą, należy do niego.

Grupowanie

Krótki opis Klastrowanie jest logicznym rozszerzeniem pomysłu.

klasyfikacja. To zadanie jest bardziej skomplikowane, cechą klastrowania jest to, że klasy obiektów nie są początkowo z góry określone. Efektem grupowania jest podział obiektów na grupy.

Przykład metody rozwiązania problemu klastrowania: uczenie się „bez nauczyciela” specjalnego rodzaju sieci neuronowych - samoorganizujących się map Kohonena.

Stowarzyszenie (stowarzyszenia)

Krótki opis W trakcie rozwiązywania problemu wyszukiwania reguł asocjacyjnych stwierdza się prawidłowości między powiązanymi zdarzeniami w zbiorze danych.

Różnica między powiązaniem a dwoma poprzednimi zadaniami DataMining: wyszukiwanie wzorców odbywa się nie na podstawie właściwości analizowanego obiektu, ale między kilkoma zdarzeniami, które występują jednocześnie. Najbardziej znanym algorytmem rozwiązywania problemu znajdowania reguł asocjacyjnych jest algorytm Apriori.

Sekwencja lub sekwencyjne skojarzenie

Krótki opis Sekwencja pozwala znaleźć tymczasowe wzorce między transakcjami. Zadanie sekwencji jest podobne do powiązania, ale jej celem jest ustalenie wzorców nie między jednocześnie występującymi zdarzeniami, ale między zdarzeniami powiązanymi w czasie (tj. Występującymi w określonym przedziale czasu). Innymi słowy, sekwencja zależy od wysokiego prawdopodobieństwa łańcucha zdarzeń związanych z czasem. W rzeczywistości powiązanie jest szczególnym przypadkiem sekwencji z opóźnieniem czasowym równym zero. To zadanie DataMining jest również nazywane problemem sekwencyjnym.

Reguła sekwencji: po zdarzeniu X zdarzenie Y nastąpi po pewnym czasie.

Przykład Po zakupie mieszkania mieszkańcy w 60% przypadków kupują lodówkę w ciągu dwóch tygodni, a telewizor w 50% przypadków w ciągu dwóch miesięcy. Rozwiązanie tego problemu jest szeroko stosowane w marketingu i zarządzaniu, na przykład w zarządzaniu cyklem klienta (CustomerLifecycleManagement).

Regresja, prognozowanie (prognozowanie)

Krótki opis W wyniku rozwiązania problemu prognozowania w oparciu o cechy danych historycznych szacuje się pominięte lub przyszłe wartości docelowych wskaźników numerycznych.

Aby rozwiązać takie problemy, szeroko stosuje się metody statystyki matematycznej, sieci neuronowe itp.

Dodatkowe zadania

Definiowanie odchyleń lub wartości odstających (DeviationDetection)analiza odchyleń lub wartości odstających

Krótki opis Celem rozwiązania tego problemu jest wykrycie i analiza danych, które najbardziej różnią się od całego zestawu danych, w celu zidentyfikowania tak zwanych nietypowych wzorców.

Oszacowanie

Zadanie szacowania sprowadza się do przewidywania ciągłych wartości atrybutu.

Analiza linków

Zadanie znajdowania zależności w zbiorze danych.

Wizualizacja (grafizacja)

W wyniku wizualizacji powstaje obraz graficzny analizowanych danych. Aby rozwiązać problem wizualizacji, stosuje się metody graficzne, które pokazują obecność wzorców w danych.

Przykładem technik wizualizacji jest prezentacja danych w wymiarach 2-D i 3-D.

Podsumowanie

Zadanie, którego celem jest opis konkretnych grup obiektów z analizowanego zestawu danych.

Wystarczająco blisko wspomnianej klasyfikacji jest podział zadań DataMining na następujące: badania i odkrywanie, prognozowanie i klasyfikacja, objaśnienia i opisy.

Automatyczne poszukiwanie i odkrywanie (bezpłatne wyszukiwanie)

Przykład zadania: odkrycie nowych segmentów rynku.

Aby rozwiązać tę klasę problemów, stosuje się metody analizy skupień.

Prognozy i klasyfikacja

Przykładowe zadanie: przewidywanie wzrostu sprzedaży na podstawie bieżących wartości.

Metody: regresja, sieci neuronowe, algorytmy genetyczne, drzewa decyzyjne.

Klasyfikacja i prognozy tworzą grupę tzw. Modelowania indukcyjnego, w wyniku czego zapewnione jest badanie analizowanego obiektu lub układu. W procesie rozwiązywania tych problemów na podstawie zbioru danych opracowuje się ogólny model lub hipotezę.

Objaśnienie i opis

Przykład zadania: charakterystyka klientów według danych demograficznych i historii zakupów.

Metody: drzewa decyzyjne, systemy reguł, reguły asocjacji, analiza linków.

Jeśli dochód klienta wynosi ponad 50 konwencjonalnych jednostek, a jego wiek to ponad 30 lat, klasa klienta jest pierwsza.

Porównanie klastrowania i klasyfikacji

|

Funkcja |

Klasyfikacja |

Grupowanie |

|

Uczenie się sterowalności |

Kontrolowane |

Niekontrolowane |

|

Strategie |

Szkolenie nauczycieli |

Uczenie się bez nauczyciela |

|

Etykieta klasy |

Zestaw do nauki po którym następuje etykieta wskazująca klasa, do której należy obserwacja |

Etykiety do nauki zestawy są nieznane |

|

Podstawa klasyfikacji |

Nowe dane sklasyfikowane na podstawie zestawu treningowego |

Biorąc pod uwagę dużo danych do celów ustanowienie istnienia klasy lub klastry danych |

Zakresy DataMining

Należy zauważyć, że dziś technologia DataMining jest najczęściej stosowana w rozwiązywaniu problemów biznesowych. Być może powodem jest to, że w tym kierunku zwrot z korzystania z narzędzi DataMining może, według niektórych źródeł, wynosić nawet 1000%, a koszt jego wdrożenia może szybko się zwrócić.

Rozważymy szczegółowo cztery główne obszary zastosowania technologii DataMining: naukę, biznes, badania rządowe i kierowanie internetem.

zadania biznesowe. Główne obszary: bankowość, finanse, ubezpieczenia, CRM, produkcja, telekomunikacja, e-commerce, marketing, giełda i inne.

Czy udzielić pożyczki klientowi

Segmentacja rynku

Przyciąganie nowych klientów

Oszustwa związane z kartami kredytowymi

Aplikacja DataMining dla rozwiązywanie problemów na poziomie państwowym. Główne kierunki: poszukiwanie oszustów podatkowych; fundusze na walkę z terroryzmem.

Aplikacja DataMining dla badania naukowe. Główne obszary: medycyna, biologia, genetyka molekularna i inżynieria genetyczna, bioinformatyka, astronomia, chemia stosowana, badania związane z uzależnieniem od narkotyków i inne.

Korzystanie z DataMining do rozwiązania Zadania sieciowe. Główne kierunki: wyszukiwarki (wyszukiwarki), liczniki i inne.

E-commerce

W dziedzinie handlu elektronicznego DataMining służy do formowania

Ta klasyfikacja umożliwia firmom identyfikację określonych grup klientów i prowadzenie polityki marketingowej zgodnie z odkrytymi zainteresowaniami i potrzebami klientów. DataMining dla e-commerce jest ściśle powiązany z WebMining.

Główne zadania DataMining w produkcji przemysłowej:

· Kompleksowa analiza systemowa sytuacji produkcyjnych;

· Krótkoterminowa i długoterminowa prognoza rozwoju sytuacji produkcyjnych;

· Opracowanie opcji rozwiązań optymalizacyjnych;

· Prognozowanie jakości produktu w zależności od niektórych parametrów

proces technologiczny;

· Wykrywanie ukrytych trendów i wzorców rozwoju produkcji

procesy

· Prognozowanie wzorców rozwoju procesów produkcyjnych;

· Wykrywanie ukrytych czynników wpływu;

Wykrywanie i identyfikacja nieznanych wcześniej związków między

parametry produkcyjne i czynniki wpływu;

· Analiza środowiska pod kątem interakcji procesów produkcyjnych i prognozowania

zmiany jego cech;

procesy

· Wizualizacja wyników analiz, przygotowanie wstępnych raportów i projektów

możliwe rozwiązania z szacunkami wiarygodności i skuteczności możliwych wdrożeń.

Marketing

W marketingu DataMining jest bardzo szeroko stosowany.

Główne pytania marketingowe „Co to jest na sprzedaż?”, „Jak to jest na sprzedaż?”, „Kto jest

konsument? ”

Wykład na temat problemów związanych z klasyfikacją i klastrowaniem szczegółowo opisuje zastosowanie analizy skupień do rozwiązywania problemów marketingowych, takich jak segmentacja konsumentów.

Innym powszechnym zestawem metod rozwiązywania problemów marketingowych są metody i algorytmy do znajdowania reguł asocjacyjnych.

Z powodzeniem stosuje się tu również wyszukiwanie wzorców tymczasowych.

Handel detaliczny

W sektorze detalicznym, podobnie jak w marketingu, stosuje się następujące zasady:

· Algorytmy wyszukiwania reguł asocjacyjnych (do określania często występujących zestawów

towary kupowane jednocześnie przez kupujących). Identyfikacja takich reguł pomaga

umieść towary na półkach parkietów, opracuj strategie zakupu towarów

oraz ich umieszczenie w magazynach itp.

· Wykorzystanie sekwencji czasowych, na przykład w celu ustalenia

niezbędne ilości zapasów towarów w magazynie.

· Klasyfikacja i metody grupowania w celu identyfikacji grup lub kategorii klientów,

wiedza o tym przyczynia się do pomyślnej promocji towarów.

Giełda

Oto lista wyzwań rynku giełdowego, które można rozwiązać za pomocą technologii danych.

Wydobycie: · prognozowanie przyszłych wartości instrumentów finansowych i ich wskaźników

przeszłe wartości;

· Prognoza trendu (przyszły kierunek ruchu - wzrost, spadek, płaski) finansów

instrument i jego siła (mocna, umiarkowanie silna itp.);

· Przydział struktury klastrowej rynku, przemysłu, sektora dla określonego zestawu

cechy;

· Dynamiczne zarządzanie portfelem;

· Zmienność prognoz;

· Ocena ryzyka;

· Przewidywanie początku kryzysu i prognoza jego rozwoju;

· Wybór aktywów itp.

Oprócz obszarów działalności opisanych powyżej, technologia DataMining może być stosowana w wielu różnych obszarach biznesowych, w których istnieje potrzeba analizy danych i gromadzona jest pewna ilość informacji retrospektywnych.

Korzystanie z DataMining w CRM

Jednym z najbardziej obiecujących obszarów aplikacji DataMining jest wykorzystanie tej technologii w analitycznym CRM.

CRM (CustomerRelationshipManagement) - zarządzanie relacjami z klientem.

W przypadku jednoczesnego korzystania z tych technologii pozyskiwanie wiedzy łączy się z „pozyskiwaniem pieniędzy” z danych klientów.

Ważnym aspektem w działach marketingu i sprzedaży jest kompilacjacałościowy widok klientów, informacje o ich cechach, cechach, strukturze bazy klientów. CRM wykorzystuje tak zwane profilowanieklienci, dając pełny widok wszystkich niezbędnych informacji o klientach.

Profilowanie klientów obejmuje następujące elementy: segmentacja klientów, rentowność klientów, utrzymanie klientów, analiza reakcji klientów. Każdy z tych komponentów można badać za pomocą DataMining, a ich analiza jako całość, jako komponenty profilujące, może w rezultacie dostarczyć wiedzy, której nie można uzyskać z każdej indywidualnej cechy.

Webmining

WebMining można tłumaczyć jako „eksploracja danych w sieci”. WebIntelligence lub Web.

Intelekt jest gotowy „otworzyć nowy rozdział” w szybkim rozwoju biznesu elektronicznego. Zdolność do określania zainteresowań i preferencji każdego odwiedzającego poprzez obserwowanie jego zachowania stanowi poważną i kluczową zaletę konkurencji na rynku e-commerce.

Systemy WebMining mogą odpowiedzieć na wiele pytań, na przykład, który z odwiedzających jest potencjalnym klientem sklepu internetowego, która grupa klientów sklepu internetowego generuje największe przychody, jakie są zainteresowania konkretnego odwiedzającego lub grupy odwiedzających.

Metody

Klasyfikacja metod

Istnieją dwie grupy metod:

- metody statystyczne oparte na wykorzystaniu średniego zgromadzonego doświadczenia, co znajduje odzwierciedlenie w danych retrospektywnych;

- metody cybernetyczne, w tym wiele heterogenicznych podejść matematycznych.

Wada tej klasyfikacji: zarówno algorytmy statystyczne, jak i cybernetyczne w taki czy inny sposób polegają na porównaniu doświadczeń statystycznych z wynikami monitorowania bieżącej sytuacji.

Zaletą takiej klasyfikacji jest wygoda interpretacji - służy ona do opisania narzędzi matematycznych współczesnego podejścia do wydobywania wiedzy z tablic obserwacji początkowych (operacyjnych i retrospektywnych), tj. w zadaniach eksploracji danych.

Rozważ bardziej szczegółowo grupy przedstawione powyżej.

Metody eksploracji danych statystycznych

W tych metody to cztery powiązane ze sobą sekcje:

- wstępna analiza charakteru danych statystycznych (testowanie hipotez stacjonarności, normalności, niezależności, jednorodności, oszacowanie rodzaju funkcji rozkładu, jej parametrów itp.);

- identyfikowanie relacji i wzory (analiza regresji liniowej i nieliniowej, analiza korelacji itp.);

- wielowymiarowa analiza statystyczna (liniowa i nieliniowa analiza dyskryminacyjna, analiza skupień, analiza składników, analiza czynnikowa itp.);

- modele dynamiczne i prognozy oparte na szeregach czasowych.

Arsenał metod statystycznych Data Mining dzieli się na cztery grupy metod:

- Analiza opisowa i opis danych źródłowych.

- Analiza linków (analiza korelacji i regresji, analiza czynnikowa, analiza wariancji).

- Analiza statystyczna wielowymiarowa (analiza składowa, analiza dyskryminacyjna, analiza regresji wielowymiarowej, korelacje kanoniczne itp.).

- Analiza szeregów czasowych (modele dynamiczne i prognozowanie).

Techniki eksploracji danych cybernetycznych

Drugim kierunkiem eksploracji danych jest wiele podejść, połączonych ideą matematyki komputerowej i wykorzystaniem teorii sztucznej inteligencji.

Ta grupa obejmuje następujące metody:

- sztuczne sieci neuronowe (rozpoznawanie, grupowanie, prognozowanie);

- programowanie ewolucyjne (w tym algorytmy dla metody grupowego rozliczania argumentów);

- algorytmy genetyczne (optymalizacja);

- pamięć asocjacyjna (poszukiwanie analogów, prototypów);

- logika rozmyta;

- drzewa decyzyjne;

- systemy przetwarzania wiedzy eksperckiej.

Analiza skupień

Celem grupowania jest poszukiwanie istniejących struktur.

Grupowanie jest procedurą opisową, nie zawiera żadnych wniosków statystycznych, ale umożliwia przeprowadzenie analizy eksploracyjnej i badanie „struktury danych”.

Sama koncepcja „klastra” jest niejednoznacznie zdefiniowana: każde badanie ma swoje własne „klastry”. Pojęcie klastra jest tłumaczone jako „klaster”, „pęczek”. Klaster można scharakteryzować jako grupę obiektów o wspólnych właściwościach.

Charakterystykę klastra można nazwać dwoma znakami:

- wewnętrzna jednolitość;

- izolacja zewnętrzna.

Pytanie zadawane przez analityków przy rozwiązywaniu wielu problemów dotyczy sposobu organizacji danych w struktury wizualne, tj. rozwinąć taksonomię.

Grupowanie było wykorzystywane przede wszystkim w takich naukach, jak biologia, antropologia i psychologia. Do rozwiązywania problemów ekonomicznych klastrowanie od dawna nie jest używane ze względu na specyfikę danych ekonomicznych i zjawisk.

Klastry mogą się nie nakładać lub być wykluczające (nie nakładające się, wyłączne) i przecinające się (nakładające się).

Należy zauważyć, że w wyniku zastosowania różnych metod analizy skupień można uzyskać klastry o różnych kształtach. Na przykład klastry typu „łańcuchowego” są możliwe, gdy klastry są reprezentowane przez długie „łańcuchy”, podłużne klastry itp., A niektóre metody mogą tworzyć klastry o dowolnym kształcie.

Różne metody mogą próbować tworzyć klastry o określonych rozmiarach (na przykład małe lub duże) lub zakładać obecność klastrów o różnych rozmiarach w zbiorze danych. Niektóre metody analizy skupień są szczególnie wrażliwe na hałas lub wartości odstające, inne są mniej wrażliwe. W wyniku zastosowania różnych metod grupowania można uzyskać nierówne wyniki, jest to normalne i jest cechą działania algorytmu. Te cechy należy wziąć pod uwagę przy wyborze metody klastrowania.

Podajemy krótki opis podejść do grupowania.

Algorytmy partycjonowania na podstawie algorytmów partycjonowania iteracyjny:

- dzielenie obiektów na k klastrów;

- iteracyjna redystrybucja obiektów w celu poprawy klastrowania.

- Algorytmy hierarchiczne:

- aglomeracja: każdy obiekt jest początkowo klastrem, klastrami,

- łącząc się ze sobą, tworząc większy klaster itp.

Metody oparte na koncentracji obiektów (metody oparte na gęstości):

- w oparciu o umiejętność łączenia obiektów;

- ignoruj \u200b\u200bhałas, znajdując klastry o dowolnym kształcie.

Siatka - metody (metody oparte na siatce):

- kwantyzacja obiektów w strukturze siatki.

Metody modelowe (oparte na modelu):

- za pomocą modelu, aby znaleźć klastry najbardziej odpowiednie dla danych.

Metody analizy skupień. Metody iteracyjne.

Przy dużej liczbie obserwacji hierarchiczne metody analizy skupień nie są odpowiednie. W takich przypadkach stosowane są niehierarchiczne metody oparte na separacji, które są iteracyjnymi metodami fragmentacji pierwotnej populacji. W procesie podziału tworzone są nowe klastry do momentu spełnienia reguły zatrzymania.

Takie niehierarchiczne grupowanie polega na dzieleniu zestawu danych na pewną liczbę pojedynczych klastrów. Istnieją dwa podejścia. Pierwszym z nich jest określenie granic klastrów jako najgęstszych sekcji w wielowymiarowej przestrzeni danych źródłowych, tj. definicja klastra, w którym występuje duża „koncentracja punktów”. Drugim podejściem jest zminimalizowanie miary różnic w obiektach

Algorytm K-średnich (k-średnich)

Najczęstszą niehierarchiczną metodą jest algorytm k-średnich, zwany także szybka analiza skupień. Pełny opis algorytmu można znaleźć w pracy Hartigan i Wong (HartiganandWong, 1978). W przeciwieństwie do metod hierarchicznych, które nie wymagają wstępnych założeń dotyczących liczby klastrów, aby móc skorzystać z tej metody, konieczna jest hipoteza o najbardziej prawdopodobnej liczbie klastrów.

Algorytm k-średnich konstruuje k klastrów zlokalizowanych w możliwie dużych odległościach. Głównym rodzajem problemów, które rozwiązuje algorytm k-średnich, jest istnienie założeń (hipotez) dotyczących liczby klastrów, które powinny być możliwie różne. Wybór k może być oparty na wcześniejszych badaniach, rozważaniach teoretycznych lub intuicji.

Ogólna idea algorytmu: dana stała liczba k klastrów obserwacyjnych jest odwzorowywana na klastry, dzięki czemu średnie w klastrze (dla wszystkich zmiennych) różnią się od siebie tak bardzo, jak to możliwe.

Opis algorytmu

1. Początkowy rozkład obiektów w klastrach.

- Wybrana jest liczba k, a na pierwszym etapie punkty te są uważane za „centra” klastrów.

- Każdy klaster ma jedno centrum.

Wybór początkowych centroidów można przeprowadzić w następujący sposób:

- wybór k-obserwacji w celu maksymalizacji początkowej odległości;

- losowy wybór obserwacji k;

- wybór pierwszych k-obserwacji.

W rezultacie każdy obiekt jest przypisany do określonego klastra.

2. Proces iteracyjny.

Obliczane są centra klastrów, które następnie i dalej są średnimi klastrami średnimi. Przedmioty są ponownie rozpowszechniane.

Proces obliczania centrów i redystrybucji obiektów trwa do momentu spełnienia jednego z warunków:

- centra klastrów ustabilizowane, tj. wszystkie obserwacje należą do gromady, która należała do bieżącej iteracji;

- liczba iteracji jest równa maksymalnej liczbie iteracji.

Na rysunku pokazano przykład algorytmu k-średnich dla k równego dwa.

Przykład algorytmu k-średnich (k \u003d 2)

Wybór liczby klastrów to złożony problem. Jeśli nie ma żadnych założeń dotyczących tej liczby, zaleca się utworzenie 2 klastrów, a następnie 3, 4, 5 itd., Porównując wyniki.

Kontrola jakości grupowania

Po uzyskaniu wyników analizy skupień metodą k-średnich należy sprawdzić poprawność klastrowania (tj. Aby ocenić, jak bardzo klastry różnią się od siebie).

W tym celu obliczane są średnie wartości dla każdego klastra. Przy dobrym grupowaniu należy uzyskać bardzo różne średnie dla wszystkich pomiarów, a przynajmniej dla większości z nich.

Zalety algorytmu k-średnich:

- łatwość użycia;

- prędkość użytkowania;

- zrozumiałość i przejrzystość algorytmu.

Wady algorytmu k-średnich:

- algorytm jest zbyt wrażliwy na wartości odstające, które mogą zniekształcać średnią.

Możliwym rozwiązaniem tego problemu jest zastosowanie modyfikacji algorytmu, algorytmu k-mediany;

- algorytm może działać wolno na dużych bazach danych. Możliwym rozwiązaniem tego problemu jest użycie próbki danych.

Sieci bayesowskie

W teorii prawdopodobieństwa pojęcie zależności informacji modeluje się poprzez zależność warunkową (lub ściśle: brak warunkowej niezależności), która opisuje, w jaki sposób zmienia się nasze zaufanie do wyniku zdarzenia, gdy zdobywamy nową wiedzę o faktach, pod warunkiem, że znamy już pewien zestaw innych faktów.

Wygodnie i intuicyjnie jest wyobrażać sobie zależności między elementami za pomocą ukierunkowanej ścieżki łączącej te elementy na wykresie. Jeśli związek między elementami xiy nie jest bezpośredni i jest realizowany przez trzeci element z, logiczne jest oczekiwanie, że element z będzie na ścieżce między xiy. Takie węzły pośredniczące „odetną” relację między xiy, to znaczy symulować sytuację warunkowej niezależności między nimi przy znanej wartości czynników bezpośredniego wpływu.Te języki modelowania to sieci bayesowskie, które służą do opisu zależności warunkowych między pojęciami określonego obszaru tematycznego.

Sieci bayesowskie to struktury graficzne do reprezentowania probabilistycznych związków między dużą liczbą zmiennych i do wnioskowania probabilistycznego na podstawie tych zmiennych.Klasyfikacja „naiwna” (bayesowska) jest dość przejrzystą i zrozumiałą metodą klasyfikacji. Nazywa się ją „naiwną”, ponieważ opiera się na założeniu wzajemnościniezależność znaków.

Właściwości klasyfikacji:

1. Wykorzystanie wszystkich zmiennych i określenie wszystkich zależności między nimi.

2. Obecność dwóch założeń dotyczących zmiennych:

- wszystkie zmienne są równie ważne;

- wszystkie zmienne są statystycznie niezależne, tj. wartość jednej zmiennej nie mówi nic o wartości innej.

Istnieją dwa główne scenariusze zastosowania sieci bayesowskich:

1. Analiza opisowa. Obszar tematyczny jest wyświetlany w postaci wykresu, którego węzły reprezentują pojęcia, a ukierunkowane łuki wyświetlane za pomocą strzałek ilustrują bezpośrednie związki między tymi pojęciami. Związek między pojęciami xiy oznacza: znajomość wartości x pomaga w bardziej świadomym założeniu o wartości y. Brak bezpośredniego związku między pojęciami modeluje warunkową niezależność między nimi dla znanych wartości pewnego zestawu pojęć „oddzielających”. Na przykład rozmiar buta dziecka jest oczywiście związany ze zdolnością dziecka do czytania przez wiek. Tak więc większy rozmiar buta daje większą pewność, że dziecko już czyta, ale jeśli znamy już wiek, to znajomość rozmiaru buta nie dostarczy nam dodatkowych informacji na temat zdolności dziecka do czytania.

Jako inny, przeciwny przykład, rozważamy takie początkowo niezwiązane czynniki, jak palenie i przeziębienie. Ale jeśli znamy na przykład objaw, że dana osoba cierpi na kaszel rano, to wiedza o tym, że nie pali, zwiększa naszą pewność, że jest przeziębiona.

2. Klasyfikacja i prognozowanie. Sieć bayesowska, umożliwiająca warunkową niezależność szeregu pojęć, może zmniejszyć liczbę wspólnych parametrów dystrybucji, umożliwiając im zaufanie do dostępnych woluminów danych. Tak więc, przy 10 zmiennych, z których każda może przyjąć 10 wartości, liczba wspólnych parametrów rozkładu wynosi 10 miliardów - 1. Jeśli założymy, że tylko 2 zmienne zależą od siebie między sobą, wówczas liczba parametrów wynosi 8 * (10-1) + (10 * 10-1) \u003d 171. Mając realistyczny model rozkładu połączeń w zasobach obliczeniowych, nieznaną wartość pojęcia, możemy przewidzieć, na przykład, jak najbardziej prawdopodobna wartość tego pojęcia ze znanymi wartościami innych pojęć.

Zauważono takie zalety sieci bayesowskich, jak metoda DataMining:

Model definiuje zależności między wszystkimi zmiennymi, dzięki czemu jest to łatweradzić sobie z sytuacjami, w których wartości niektórych zmiennych są nieznane;

Sieci bayesowskie są dość łatwe do interpretacji i pozwalają na etapiemodelowanie predykcyjne jest łatwe do analizy zgodnie ze scenariuszem „co jeśli”;

Metoda bayesowska pozwala na naturalne łączenie wzorów,pochodzi z danych, a na przykład wiedzy eksperckiej uzyskanej wyraźnie;

Korzystanie z sieci bayesowskich pozwala uniknąć problemu przekwalifikowania(przeregulowanie), tj. nadmierna złożoność modelu, co jest słabościąwiele metod (np. drzewa decyzyjne i sieci neuronowe).

Naiwne podejście bayesowskie ma następujące wady:

Prawidłowe jest mnożenie prawdopodobieństw warunkowych tylko wtedy, gdy wszystkie prawdopodobieństwa wejściowezmienne są naprawdę statystycznie niezależne; chociaż często ta metodapokazuje wystarczająco dobre wyniki, jeśli warunki statystyczne nie są spełnioneniezależność, ale teoretycznie taka sytuacja powinna być rozwiązywana przez bardziej złożonemetody oparte na szkoleniu sieci bayesowskich;

Bezpośrednie przetwarzanie zmiennych ciągłych nie jest możliwe - są one wymaganekonwersja do skali interwału, dzięki czemu atrybuty są dyskretne; jednak takietransformacje mogą czasami prowadzić do utraty znaczących wzorców;

Wpływ na wynik klasyfikacji w naiwnym podejściu bayesowskim ma jedynie wpływindywidualne wartości zmiennych wejściowych, łączny wpływ par lubtrzy wartości różnych atrybutów nie są tutaj brane pod uwagę. To może się poprawićjakość modelu klasyfikacji pod względem dokładności prognostycznej,zwiększyłoby to jednak liczbę testowanych opcji.

Sztuczne sieci neuronowe